Was ist Requesty LLM Gateway?

Requesty ist ein LLM Gateway Das fungiert als intelligente Middleware für all Ihre LLM-Anforderungen. Integration mit Mehr als 200 LLM-Anbieter Ändern Sie dazu nur einen Wert: Ihre Basis-URL. Verwenden Sie einen einzigen API-Schlüssel, um auf alle Anbieter zuzugreifen, und vergessen Sie Aufladegebühren und Ratenbegrenzungen.

Sobald Sie die Basis-URL ändern, erhalten Sie Folgendes:

- Nachverfolgung: Sehen Sie alle Ihre LLM-Inferenzaufrufe, ohne etwas an Ihrem Code ändern zu müssen.

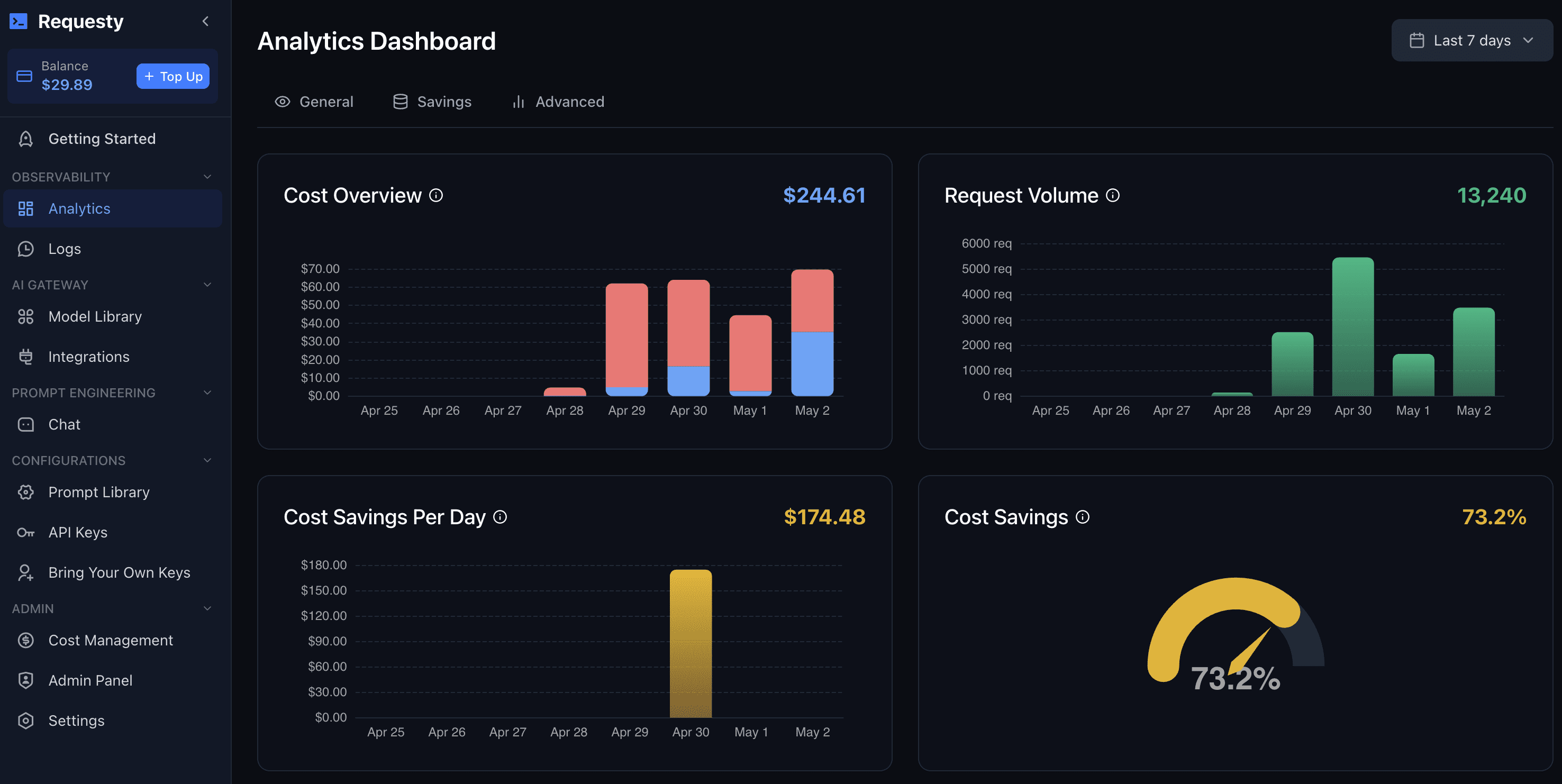

- Telemetrie: Sehen Sie Latenzzeiten, Anfrageanzahlen, Caching-Raten und mehr, ohne etwas an Ihrem Code ändern zu müssen.

- Abrechnung: Sehen Sie genau, wie viel Sie bei jedem Anbieter und für jeden Anwendungsfall ausgeben.

- Datensicherheit: Schützen Sie Ihre personenbezogenen Daten und Unternehmensgeheimnisse, indem Sie diese maskieren, bevor sie den LLM-Anbieter erreichen.

- Datenschutz: Beschränken Sie die Nutzung auf Anbieter in einer bestimmten Region

- Intelligente Routenplanung: Routenanfragen basierend auf Requestys intelligentem Routing-Klassifizierungsmodell werden weitergeleitet, wodurch Kosten gespart und die Leistung verbessert wird.

Anwendungsfälle und Funktionen

1. Greifen Sie mit einem einzigen API-Schlüssel auf über 200 Modelle zu. ohne jegliche Ratenbegrenzungen

2. Erhalten Sie Zugriff auf OpenAI. an alle LLM-Anbieter

3. Erhalten Sie aggregierte Tracking-, Telemetrie- und Abrechnungsdaten für alle Ihre LLM-Inferenzaufrufe

Einloggen

Einloggen