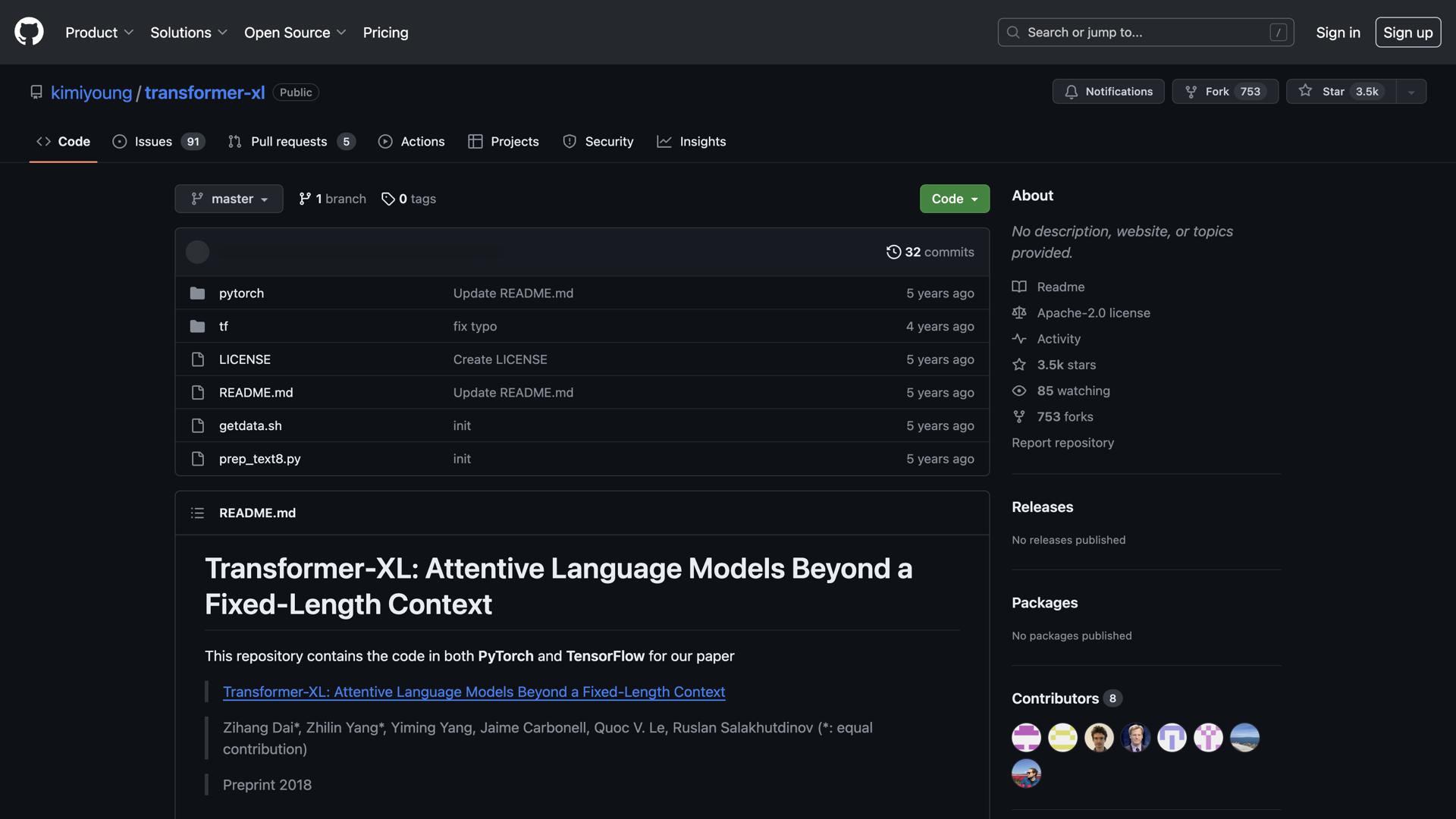

Transformer-XL ist ein leistungsstarke, hochmoderne Bibliothek für die Verarbeitung natürlicher Sprache (NLP). Diese Open-Source-Bibliothek wurde entwickelt, um die Art und Weise, wie Entwickler Sprachmodelle erstellen, grundlegend zu verändern. Sie ermöglicht es Entwicklern, schnell und präzise Sprachmodelle für vielfältige Aufgaben zu erstellen und bietet so eine beispiellose Geschwindigkeit und Genauigkeit beim Verstehen natürlicher Sprache.

Die Bibliothek verfügt über eine einzigartiger adaptiver Speichermechanismus und ein Wiederholungsmechanismus auf SegmentebeneDiese innovativen Funktionen ermöglichen es Entwicklern, anspruchsvolle Sprachmodelle zu erstellen, die komplexe sprachliche Muster und längere Kontextabhängigkeiten problemlos verarbeiten können.

Transformer-XL bietet einen breites Spektrum vortrainierter Modelle Diese Modelle eignen sich hervorragend als Ausgangspunkt für vielfältige Anwendungen. Sie lassen sich leicht anpassen und feinabstimmen, um spezifische Aufgabenanforderungen zu erfüllen, wodurch Entwicklungszeit und -aufwand deutlich reduziert werden. Ob Textgenerierung, Sprachübersetzung, Stimmungsanalyse oder andere NLP-Aufgaben – Transformer-XL bietet Ihnen die nötige Flexibilität und Leistung.

Die Plattform kombiniert Geschwindigkeit, intuitives Design und FlexibilitätDamit ist es die ideale Wahl für Entwickler, die robuste und zuverlässige Sprachmodelle erstellen möchten. Die benutzerfreundliche Oberfläche und die umfassende Dokumentation gewährleisten, dass sowohl Anfänger als auch erfahrene Anwender die Funktionen effektiv nutzen können.

Anwendungsfälle und Funktionen

1. Vorab trainierte Modelle anpassen, um schnell Sprachmodelle zu erstellen

Nutzen Sie bestehende Modelle und passen Sie diese an Ihren spezifischen Anwendungsfall an, um Zeit und Rechenressourcen zu sparen und gleichzeitig eine hohe Leistung zu gewährleisten.

2. Nutzen Sie erweiterte Funktionen und Werkzeuge, um Genauigkeit und Geschwindigkeit zu erhöhen.

Nutzen Sie modernste Mechanismen wie adaptives Gedächtnis und segmentbasierte Rekursion, um eine überlegene Modellleistung zu erzielen.

3. Nutzen Sie adaptive Speichermechanismen, um zuverlässige Sprachmodelle zu erstellen.

Entwickeln Sie Modelle, die Langzeitabhängigkeiten effektiv erfassen und den Kontext über längere Sequenzen hinweg aufrechterhalten können, um konsistente und genaue Ergebnisse zu gewährleisten.

Einloggen

Einloggen