So nutzen Sie Apple AI im Jahr 2026: Der vollständige Leitfaden für Einsteiger zu den intelligenten Funktionen von Apple

Im schnelllebigen Jahr 2026 hat sich Künstliche Intelligenz von einer Neuheit zu einem ebenso unverzichtbaren Bestandteil der Infrastruktur wie Elektrizität entwickelt. Während die Konkurrenz um den Aufbau massiver Cloud-basierter Modelle wetteiferte, verfolgte Apple eine langfristige Strategie und konzentrierte sich auf ein einzigartiges Angebot: Persönliche IntelligenzApple Intelligence ist nicht nur ein Chatbot; es handelt sich um eine tief integrierte, datenschutzorientierte Schicht, die Apps orchestriert, den persönlichen Kontext versteht und Aufgaben im gesamten Apple-Ökosystem ausführt.

Dieses System, das ursprünglich mit iOS 18 eingeführt wurde und in iOS 26 deutlich ausgereifter ist, stellt einen Wandel von „Generativer KI“ (Erstellung von Inhalten) zu "Agentische KI" (Es erledigt Dinge für Sie). Ob Ihr iPhone vor einem Meeting einen chaotischen Slack-Thread zusammenfasst oder Ihr iPad in Sekundenschnelle ein Storyboard für eine Kundenpräsentation erstellt – Apple Intelligence ist als unsichtbarer Motor Ihrer Produktivität konzipiert.

Was hebt Apple in der hart umkämpften KI-Branche des Jahres 2026 von anderen ab?

- Architektur mit Fokus auf Datenschutz: Durch die Nutzung des „Private Cloud Compute“-Standards (PCC) stellt Apple sicher, dass die Daten selbst dann für Apple kryptografisch unzugänglich sind, wenn Aufgaben Ihr Gerät verlassen und in die Cloud verlagert werden.

- Der NPU-Vorteil: Mit den A19- und M5-Chips werden 80 % der Anfragen direkt auf dem Gerät verarbeitet, wodurch Latenzfreiheit und Funktionalität auch ohne Internetverbindung gewährleistet werden.

- Systemweiter Kontext: Im Gegensatz zu eigenständigen Apps weiß Apple Intelligence, was auf Ihrem Bildschirm angezeigt wird, wer Ihre Kontakte sind und wie Ihr Kalender aussieht, und verknüpft diese Datenpunkte nahtlos miteinander.

Schritt 1: Hardware-Vorbereitung und -Einrichtung

Bevor diese Funktionen genutzt werden können, ist die Hardwarekompatibilität der entscheidende Faktor. Ab Januar 2026 bedeuten die Anforderungen der Neural Engine, dass ältere Geräte (vor 2023) möglicherweise von den On-Device-Verarbeitungsfunktionen ausgeschlossen werden.

Kompatible Geräte (Liste 2026)

- iPhone: iPhone 15 Pro/Max, iPhone 16 Serie (alle), iPhone 17 Serie (alle). Anmerkung: Der A17 Pro Chip war die Basis für die erste Welle lokaler LLMs.

- iPad: Alle Modelle mit M1-Chip oder neuer (iPad Air 5. Generation+, iPad Pro 2021+).

- Mac: Alle Apple Silicon Macs (M1-, M2-, M3-, M4- und M5-Serie). Intel Macs sind mittlerweile weitgehend auf Cloud-basierte Funktionen beschränkt.

- Wearables: Apple Watch Series 10+ und Ultra 3 (für Gesundheitsinformationen und grundlegende Siri-Abfragen).

So aktivieren Sie Apple Intelligence

Der Einrichtungsprozess wurde in iOS 26 vereinfacht, erfordert jedoch spezifische Schritte zum Herunterladen der lokalisierten Large Language Models (LLMs).

- Betriebssystem aktualisieren: Stellen Sie sicher, dass Sie iOS 26.1 oder macOS Sonoma 26 verwenden. Für eine optimierte Akkulaufzeit wird das Winter-Update (26.2) empfohlen.

- Navigieren Sie zu Einstellungen: Gehe zu Einstellungen > Apple Intelligence & SiriDie

- Aktivieren & Herunterladen: Tippen Sie auf „Apple Intelligence aktivieren“. Das Gerät lädt ein Kernmodell herunter (ca. 4 GB). Profi-Tipp: Führen Sie dies während des Ladevorgangs und bei bestehender WLAN-Verbindung durch.

- Sprachkonfiguration: Wählen Sie Ihre primäre Sprache. Ab 2026 wird endlich eine nahtlose zweisprachige Unterstützung eingeführt (z. B. Umschalten zwischen Englisch und Mandarin).

Die vereinfachte Benutzeroberfläche in den iOS-Einstellungen ermöglicht schnelles Herunterladen von Modellen und Konfigurieren der Sprache.

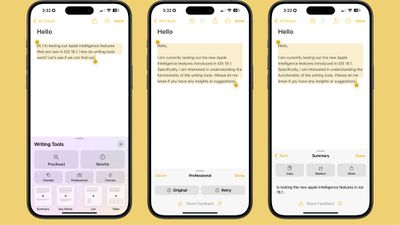

Die vereinfachte Benutzeroberfläche in den iOS-Einstellungen ermöglicht schnelles Herunterladen von Modellen und Konfigurieren der Sprache. Kernproduktivität: Systemweite Schreibwerkzeuge beherrschen

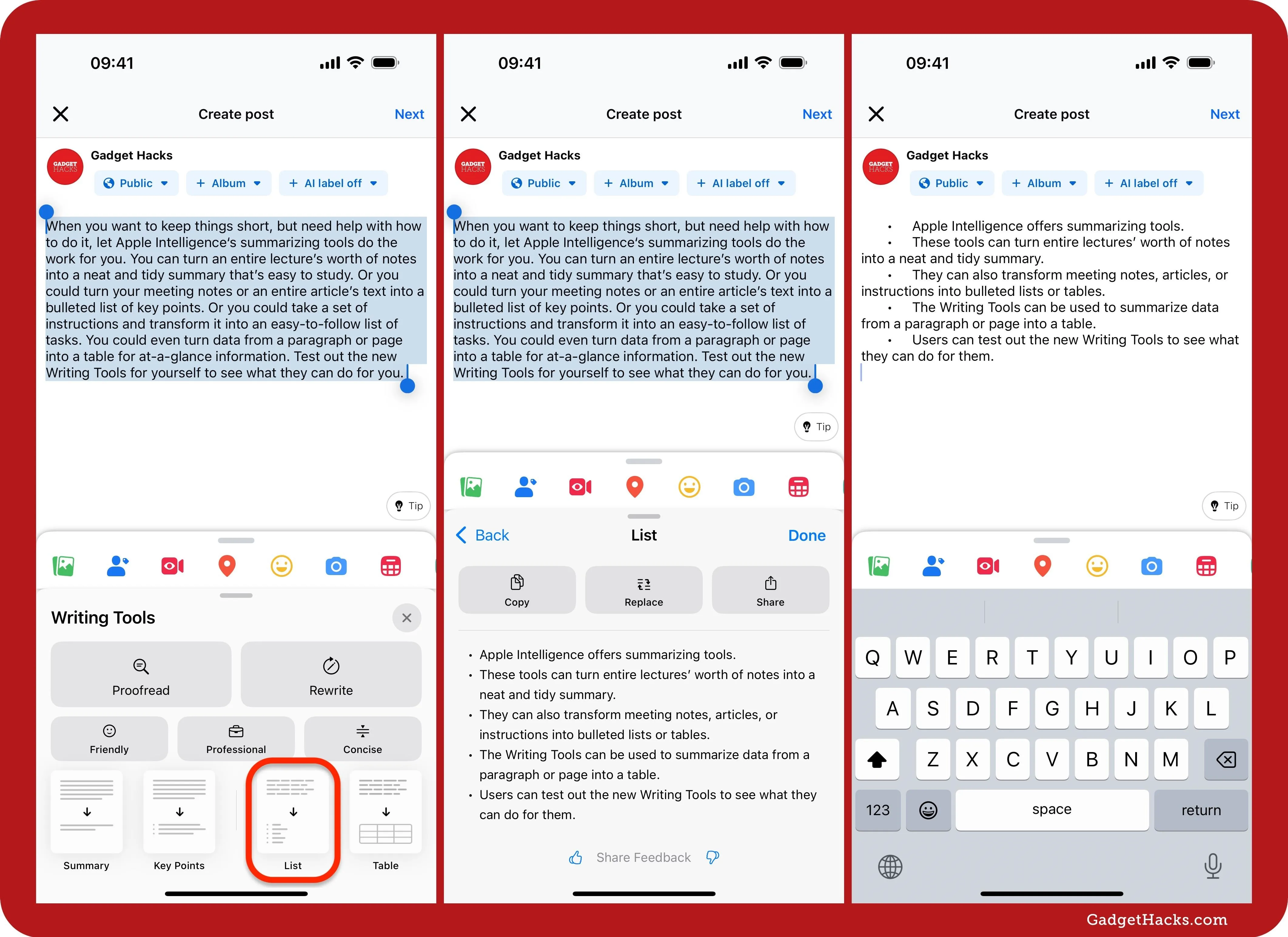

Die Schreibwerkzeuge sind wohl die revolutionärste Funktion für professionelle Anwender. Es handelt sich nicht nur um eine Rechtschreibprüfung, sondern um einen kontextsensitiven Editor, der in die Betriebssystemebene integriert ist und in Mail, Notizen, Pages sowie in Apps von Drittanbietern verfügbar ist.

Hauptmerkmale im Überblick

- Kontextuelle Umschreibung: Ändern Sie den Ton Ihrer Texte im Handumdrehen. Verwandeln Sie einen hastig verfassten, verärgerten Entwurf in eine professionelle E-Mail oder Fachjargon in ein freundliches Update für Ihre Kunden. Das 2026 eingeführte Update zum empathischen Ton ist besonders nützlich für die Kommunikation mit der Personalabteilung und dem Kundenservice.

- Intelligentes Korrekturlesen: Neben der Grammatik werden auch logischer Ablauf und kulturelle Nuancen geprüft – entscheidend für die globale Geschäftskommunikation.

- Zusammenfassung & Kernpunkte: Wählen Sie einen Bericht mit 2.000 Wörtern aus und klicken Sie auf „Zusammenfassen“. Sie können zwischen einer Absatzzusammenfassung, einer Stichpunktliste der wichtigsten Entscheidungen oder einer Tabelle mit Maßnahmen wählen.

- Smart Reply 2.0: In Mail und Messages analysiert die KI die eingehenden Inhalte und Ihre Kalenderverfügbarkeit, um vollständige und kontextbezogene Antworten vorzuschlagen (z. B. „Ja, ich habe am Dienstag um 14 Uhr Zeit, ich sende die Einladung jetzt.“).

ChatGPT-Integration: Bei Schreibblockaden ermöglicht Apple über die Schaltfläche „Mit ChatGPT verfassen“ einen nahtlosen Übergang zu den Modellen von OpenAI. Dies ist ideal, um völlig neue kreative Inhalte zu generieren, anstatt nur bestehenden Text zu bearbeiten.

Kreativität entfesseln: Bildspielplatz & Genmoji

Die generativen visuellen Fähigkeiten von Apple Intelligence haben sich deutlich weiterentwickelt. Ab 2026 setzt Apple auf „Ethische Bildgenerierung“ und bettet C2PA-Metadaten in alle Bilder ein, um deren KI-Generierung zu belegen. So werden Deepfakes bekämpft und gleichzeitig Kreativität gefördert.

Bildspielplatz: Der On-Device-Künstler

Dieses Tool, das über Nachrichten oder als eigenständige App zugänglich ist, ermöglicht es Nutzern, Grafiken in verschiedenen Stilen (Animation, Illustration, Skizze) zu erstellen. Im Gegensatz zu cloudbasierten Konkurrenten wie Midjourney läuft Image Playground lokal, sodass Ihre Eingaben privat bleiben.

Anwendungsfall: Ein Marketingmanager kann ein Storyboard für eine Präsentation erstellen, indem er „Büroumgebung, Teamfeier, futuristischer Stil“ eingibt und das Ergebnis direkt in Keynote zieht.

Genmoji: Hyperpersonalisierter Ausdruck

Warum sich mit einem Standard-Emoji zufriedengeben? Mit Genmoji können Sie Gefühle beschreiben – zum Beispiel „Ein T-Rex, der in einem Smoking auf einem Pizzastück surft“ – und sofort ein passendes Emoji erstellen. Das Update von 2026 ermöglicht kontaktbasierte Genmojis, mit denen Karikaturen von Freunden anhand ihrer Kontaktfotos erstellt werden (selbstverständlich unter Berücksichtigung der Privatsphäre).

Visuelle Intelligenz: Die Welt ist Ihre Frage

Mithilfe der speziellen Kamera-Steuerungstaste auf neueren iPhones, Visuelle Intelligenz Verwandelt die Kamera in eine Echtzeit-Suchmaschine. Diese Funktion konkurriert direkt mit Google Lens, bietet aber eine tiefere Betriebssystemintegration.

- Sofortige Aktion: Zeigen Sie auf ein Konzertplakat, und die KI extrahiert Datum und Künstler, um gleichzeitig einen Kalendereintrag und eine Apple Music-Playlist zu erstellen.

- Restaurant-Einblicke: Scannen Sie ein Schaufenster, um eine Bewertungsanzeige, die Öffnungszeiten und eine Zusammenfassung beliebter Gerichte basierend auf Kartendaten zu sehen.

- Technische Unterstützung: Zeigen Sie auf eine komplexe Routerkonfiguration oder eine Warnleuchte im Armaturenbrett eines Autos, und die KI identifiziert das Modell und erklärt das Problem oder die Einstellung.

Visual Intelligence überlagert Daten mit der realen Welt und überbrückt so die Kluft zwischen physischem Kontext und digitalen Informationen.

Visual Intelligence überlagert Daten mit der realen Welt und überbrückt so die Kluft zwischen physischem Kontext und digitalen Informationen. Siri 2.0: Die Agenten-Zukunft

Die Ära der „dummen Assistenten“ ist vorbei. Siri wird im Jahr 2026 auf großen Sprachmodellen basieren und über folgende Fähigkeiten verfügen: BildschirmbewusstseinEs kann erkennen, was Sie gerade ansehen, und entsprechend reagieren.

Dies ist der „Heilige Gral“ der KI-Agenten. Sie können nun komplexe Befehle geben wie:

„Siri, nimm die Fotos, die ich gerade in Lightroom bearbeitet habe, erstelle ein gemeinsames Album für die Familiengruppe und verfasse eine E-Mail an Mama, dass die Bilder fertig sind.“

Siri führt diese Befehlskette in drei verschiedenen Apps aus, ohne dass Sie einen Finger rühren müssen.

Geben Sie Folgendes in Siri ein: Eine neue Doppeltipp-Geste in der unteren Leiste ermöglicht die lautlose, textbasierte Interaktion mit Siri – perfekt für Besprechungen oder ruhige Umgebungen.

Die neue, leuchtende Benutzeroberfläche am Rand signalisiert, dass Siri aktiv zuhört und den Kontext erkennt.

Die neue, leuchtende Benutzeroberfläche am Rand signalisiert, dass Siri aktiv zuhört und den Kontext erkennt. Fazit: Die Nutzung des intelligenten Ökosystems

Apple Intelligence im Jahr 2026 steht für einen ausgereiften und verfeinerten Ansatz im Bereich KI. Durch den Fokus auf Nützlichkeit, Datenschutz und tiefe Integration vermeidet Apple die „Uncanny Valley“ reiner Chatbots. Der Einstieg ist einfach: Nutzen Sie zunächst die Schreibwerkzeuge in Ihren täglichen E-Mails, experimentieren Sie auf Ihrer nächsten Reise mit der visuellen Intelligenz und vertrauen Sie Siri nach und nach auch komplexen Arbeitsabläufen an.

Mit Blick auf die Zukunft, in der Gerüchte über Apples Heimroboter und AR-Brillen kursieren, ist die Beherrschung dieser grundlegenden Intelligenzfunktionen heute die Basis für das räumliche Computerzeitalter von morgen.

Häufig gestellte Fragen

Obwohl KI-Aufgaben rechenintensiv sind, ist die dedizierte Neural Engine (NPU) in Apple Silicon auf Effizienz ausgelegt. Eine intensive Nutzung der Bildgenerierung kann jedoch den Akku schneller belasten als die normale Nutzung.

Nein. Apple gibt ausdrücklich an, dass die Daten der Private Cloud Compute nicht gespeichert werden und die Daten auf dem Gerät lokal verbleiben. Ihr persönlicher Kontext wird nicht zum Trainieren der Basismodelle verwendet.

Ja. Kernfunktionen wie Schreibwerkzeuge (Überarbeiten/Korrekturlesen), Siri-Anfragen (App-Steuerung) und grundlegende Objekterkennungsfunktionen sind auf kompatiblen Geräten vollständig offline verfügbar.

Einloggen

Einloggen