const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'deepseek/deepseek-non-reasoner-v3.1-terminus',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="deepseek/deepseek-non-reasoner-v3.1-terminus",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Produktdetails

✨ DeepSeek V3.1 Chat ist ein spezialisiertes hybrides dialogorientiertes KI-Modell, das sich auf schnelle, direkte Antworten ohne komplexe Schlussfolgerungen zu ziehen. Aufbauend auf der DeepSeek V3.1-Architektur, diese Variante lässt den Denkmodus aus Es priorisiert Ausgaben mit geringer Latenz bei gleichzeitig hoher multimodaler Funktionalität. Es ist optimiert für Anwendungen, die effiziente und unkomplizierte Interaktionen in Chat, Codegenerierung und Agenten-Workflows erfordern und eignet sich für Entwickler und Unternehmen, die Wert auf schnelle Reaktionszeiten und eine optimierte Aufgabenausführung legen.

Technische Spezifikationen

- Kontextfenster bis zu 128.000 Token zur Unterstützung längerer, mehrstufiger Gespräche und Codierungssitzungen.

- Ausgabetoken-Limit bis zu 8.000 Token Optimiert für prägnante und verständliche Antworten.

- Hybrid-Transformatorarchitektur mit Mischung von Experten (MoE)-Schichten für eine effiziente Rechenzuweisung.

- Unterstützt strukturierte Toolaufrufe, Code-Agent-Funktionalität und Suchagenten zur Verbesserung der Aufgabenflexibilität.

- Erweitertes Training auf Long-Context-Datensätzen unter Verwendung von FP8-Mikroskalierung zur Steigerung der Inferenzeffizienz.

- Mehrsprachige Unterstützung über Mehr als 100 Sprachen mit hoher Kontextgenauigkeit.

Hauptmerkmale

🚀 DeepSeek V3.1 Chat funktioniert ausschließlich in einem Nicht-Denkmodus das liefert schnelle, direkte Antworten ohne mehrstufiges Denken. Diese Konfiguration ermöglicht extrem Interaktionen mit niedriger Latenz Das Modell eignet sich hervorragend für einfache Abfragen und Aufgabenausführungen. Es bietet erweiterte Funktionen zum Aufrufen von Tools und Agenten und ermöglicht so die nahtlose Integration mit Code- und Suchagenten für vielseitige Arbeitsabläufe. Basierend auf einer optimierten MoE-Transformer-Architektur erzielt es eine effiziente Ressourcennutzung und unterstützt gleichzeitig strukturierte Funktionsaufrufe für die präzise Tool-Ansteuerung. Obwohl es keine tiefgreifenden Schlussfolgerungen zieht, ist es ideal für multimodale Chats, die schnelle Codegenerierung und optimierte Agenten-Workflows, die eine schnelle und zuverlässige Ausgabe erfordern.

Leistung und Fähigkeiten

- ⚡ Schnelle Reaktionszeiten mit optimierter Werkzeugnutzung und minimalem Rechenaufwand.

- Hohe Genauigkeit bei der direkten Codegenerierung und Aufgabenausführung bei niedrigen Fehlerraten.

- Effektive Verarbeitung multimodaler Eingaben, einschließlich Text und Bildern, mit Fokus auf nicht-logische Aufgaben.

- Skalierbar über Softwareentwicklungs-, Forschungsunterstützungs- und agentenbasierte Anwendungsumgebungen hinweg.

Anwendungsfälle

- Schnelle Unterstützung bei der Softwareentwicklung, einschließlich Code-Synthese und Debugging.

- Multimodale Chatbots mit Fokus auf Bild- und Textverständnis und schnellen Antworten.

- Routinemäßige Recherche und Dokumentenanalyse mit moderaten Kontextanforderungen.

- Effizienter, mehrstufiger Dialog, geeignet für einfache, aufgabenorientierte Lernwerkzeuge.

- Business-Intelligence-Prozesse mit Schwerpunkt auf schneller visueller Dateninterpretation.

- Agentische Anwendungen, die intelligente Tool-Aufrufe ohne tiefgreifenden Analyseaufwand erfordern.

API-Preise

• 1 Million Eingabe-Tokens: 0,294 $

• 1 Million Ausgabetoken: 0,441 USD

Codebeispiel

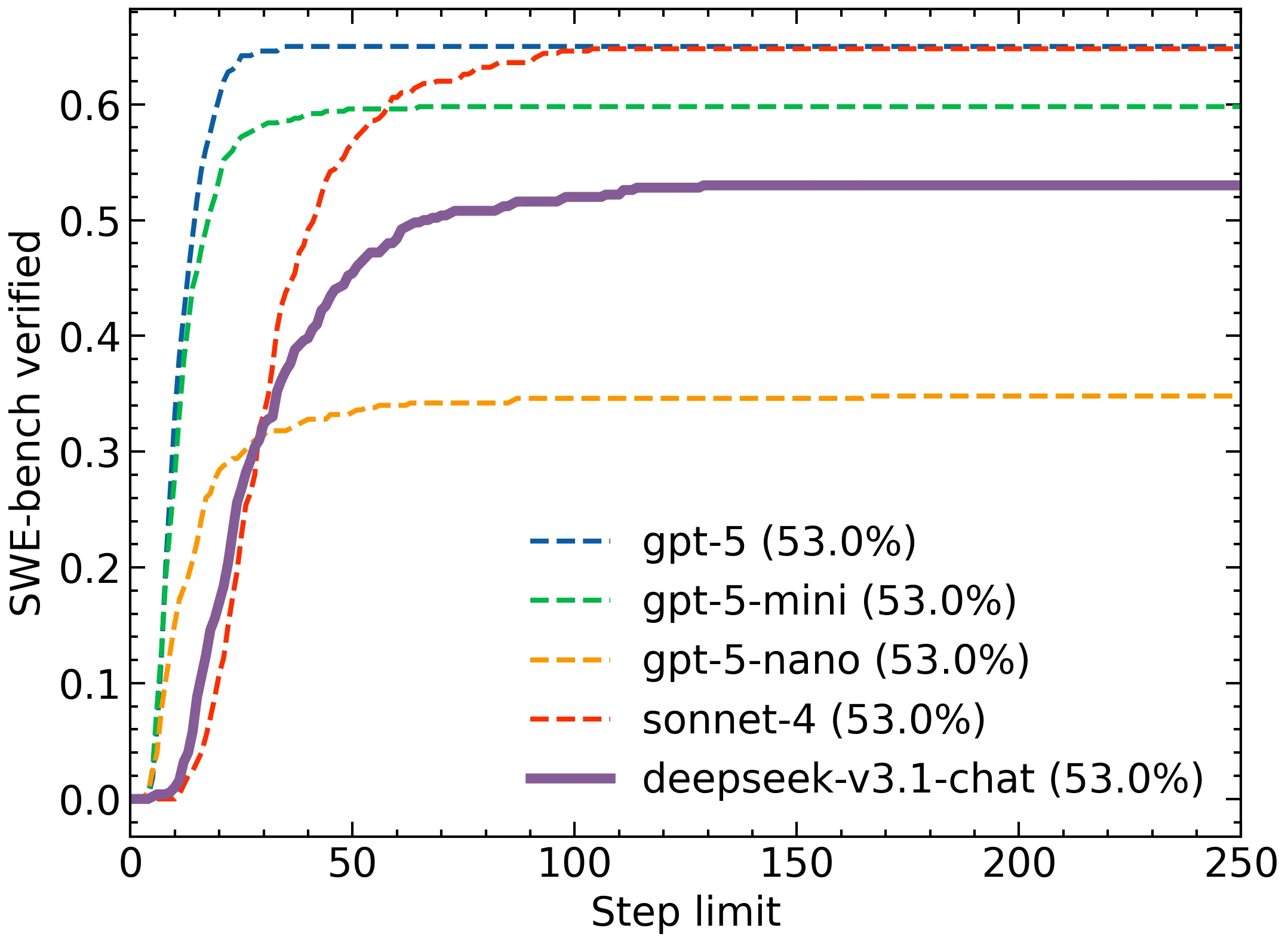

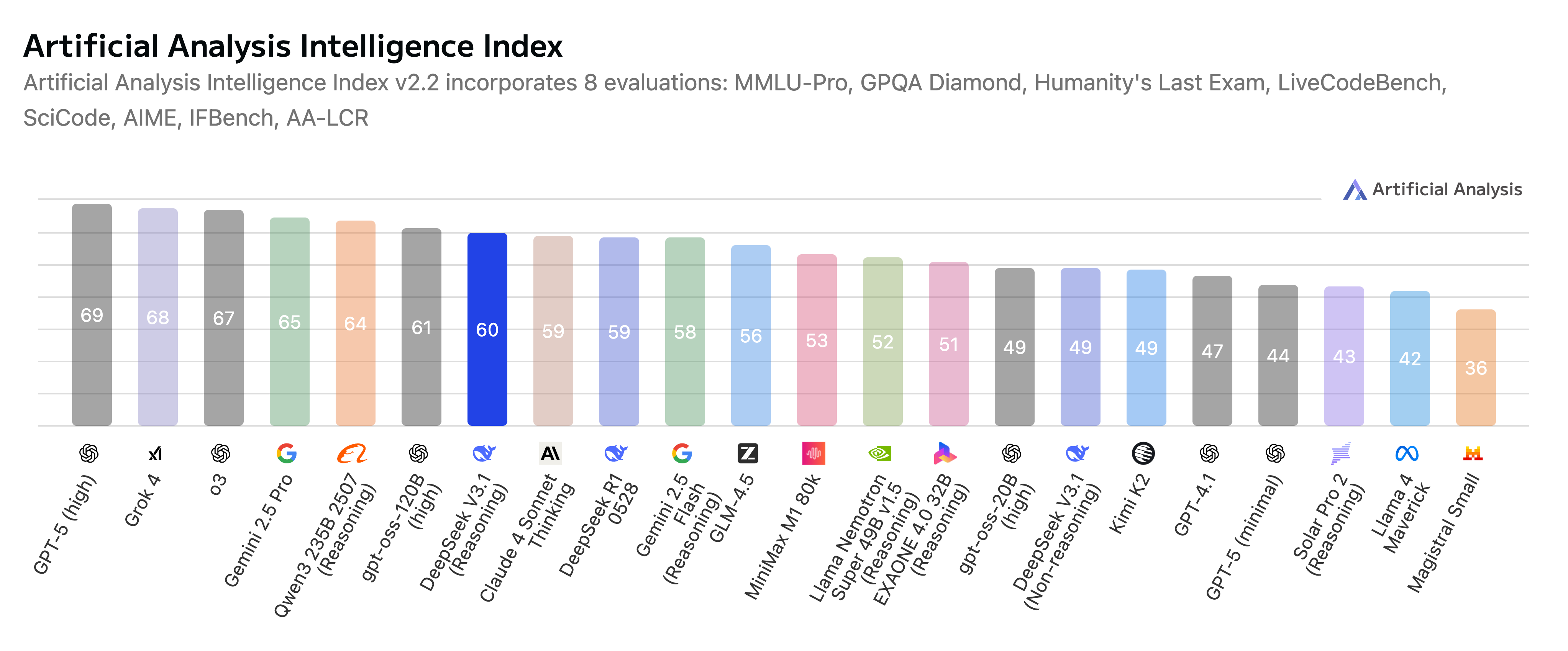

Vergleich mit anderen Modellen

DeepSeek V3.1 Chat bietet ein optimales Gleichgewicht zwischen hoher Inferenzgeschwindigkeit, starker multimodaler Integration und Kosteneffizienz für Anwendungsfälle, in denen tiefgreifendes logisches Denken nicht erforderlich ist. Es wurde für Entwickler und Unternehmen konzipiert, die Wert auf Geschwindigkeit und eine optimierte Aufgabenausführung in multimodalen Konversations-KI- und Agenten-Workflows legen.

💡 vs GPT-5: Während GPT-5 mit einem deutlich größeren Kontextfenster von 400.000 Token aufwarten und neben Text- und Bildfunktionen auch neue Audio-/Videomodalitäten integriert, zeichnet sich DeepSeek V3.1 Chat durch eine tiefere Integration der visuellen Kontextmanipulation, dynamische Expertenmodularität für effiziente Berechnungen und fortschrittliche Domänenanpassungswerkzeuge aus. DeepSeek bietet einen leistungsstarken Ansatz mit offenen Gewichtungen und Kostenvorteilen und ist auf komplexe Bildverarbeitung und multimodale Fusion spezialisiert, wohingegen GPT-5 hinsichtlich des Umfangs des Kontextes und der multimodalen Breite mit Integration in Unternehmensökosysteme führend ist.

💡 vs DeepSeek V3: Die neue Version verbessert die Inferenzgeschwindigkeit um ca. 30 %, erweitert das Kontextfenster von 128.000 auf eine flexiblere, für Chataufgaben optimierte Skala und erhöht die Genauigkeit der multimodalen Ausrichtung deutlich. Diese Verbesserungen ermöglichen ein besseres Schließen, insbesondere bei ressourcenarmen Sprachen und komplexen visuellen Szenarien, und machen die Software dadurch leistungsfähiger für fortgeschrittene dialogbasierte KI und das Verständnis umfangreicher Codes.

💡 vs OpenAI GPT-4.1: Im Vergleich zur codeoptimierten und textzentrierten Architektur von GPT-4.1 kombiniert DeepSeek V3.1 umfangreiche multimodale Eingaben mit einem ausgefeilten Mixture-of-Experts-Trainingsverfahren. Diese Ausgewogenheit führt zu einer überlegenen visuell-textuellen Kohärenz und einer schnelleren Anpassung an verschiedene multimodale Aufgaben. Dadurch eignet sich DeepSeek besonders für Arbeitsabläufe, die eine nahtlose Integration von Text und Bildern mit fortgeschrittenen Schlussfolgerungen erfordern.

Häufig gestellte Fragen (FAQ)

Was ist der Hauptzweck von DeepSeek V3.1 Chat?

DeepSeek V3.1 Chat ist konzipiert für schnelle, direkte Konversations-KIDabei werden schnelle Antworten für einfache Anfragen und die Ausführung von Aufgaben priorisiert, anstatt komplexe, mehrstufige Schlussfolgerungen zu ziehen.

Wie erreicht DeepSeek V3.1 Chat schnelle Reaktionszeiten?

Das Modell funktioniert ausschließlich in einem "Nicht-Denkmodus"Dadurch werden mehrstufige Schlussfolgerungen vermieden und sofortige Ergebnisse geliefert. Die optimierte Mixture-of-Experts-Transformerarchitektur (MoE) trägt ebenfalls zu effizienter Ressourcennutzung und hoher Geschwindigkeit bei.

Welche multimodalen Funktionen bietet DeepSeek V3.1 Chat?

Es verfügt über ausgeprägte multimodale Fähigkeiten und unterstützt effiziente Interaktionen über verschiedene Bereiche hinweg. Text und Bilder für Aufgaben wie multimodale Chats und die schnelle Codegenerierung, selbst ohne tiefgreifende Logik.

In welchen Szenarien ist DeepSeek V3.1 Chat am effektivsten?

Es ist für Anwendungen optimiert, die Folgendes erfordern effiziente, unkomplizierte Interaktionen Im Chat, bei der Codegenerierung und in Agenten-Workflows ist es ideal für Entwickler und Unternehmen, die Wert auf schnelle Reaktionszeiten und eine optimierte Aufgabenabwicklung legen.

KI-Spielplatz

Einloggen

Einloggen