const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'zhipu/glm-4.5-air',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="zhipu/glm-4.5-air",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Produktdetails

✨ GLM-4.5-Air von Zhipu AI zeichnet sich als ein sehr effizient Und kostengünstig Großes Sprachmodell. Entwickelt mit einem fortschrittlichen Mixture-of-Experts-Ansatz (MoE), verfügt es über insgesamt 106 Milliarden Parameter (davon 12 Milliarden aktive). Es eignet sich hervorragend für eine Vielzahl von Text-zu-Text-Anwendungen und spiegelt die beeindruckende Leistung des vollständigen GLM-4.5 wider. Kontextfenster mit 128.000 TokenDiese Fähigkeit ermöglicht es dem System, außergewöhnlich lange Texte zu verstehen und zu generieren, und das bei gleichzeitig drastisch reduziertem Rechenaufwand.

Technische Spezifikation

🚀 Leistungsbenchmarks

- Kontextfenster: 128.000 Token

- Rangliste 6. Platz insgesamt bei 12 Branchen-Benchmarks und einem Durchschnittsergebnis von 59,8.

- Logisches Denkvermögen: Beeindruckende Ergebnisse bei MMLU-Pro (81,4 %), AIME24 (89,4 %) und Mathematik (98,1 %), gepaart mit soliden Programmierkenntnissen.

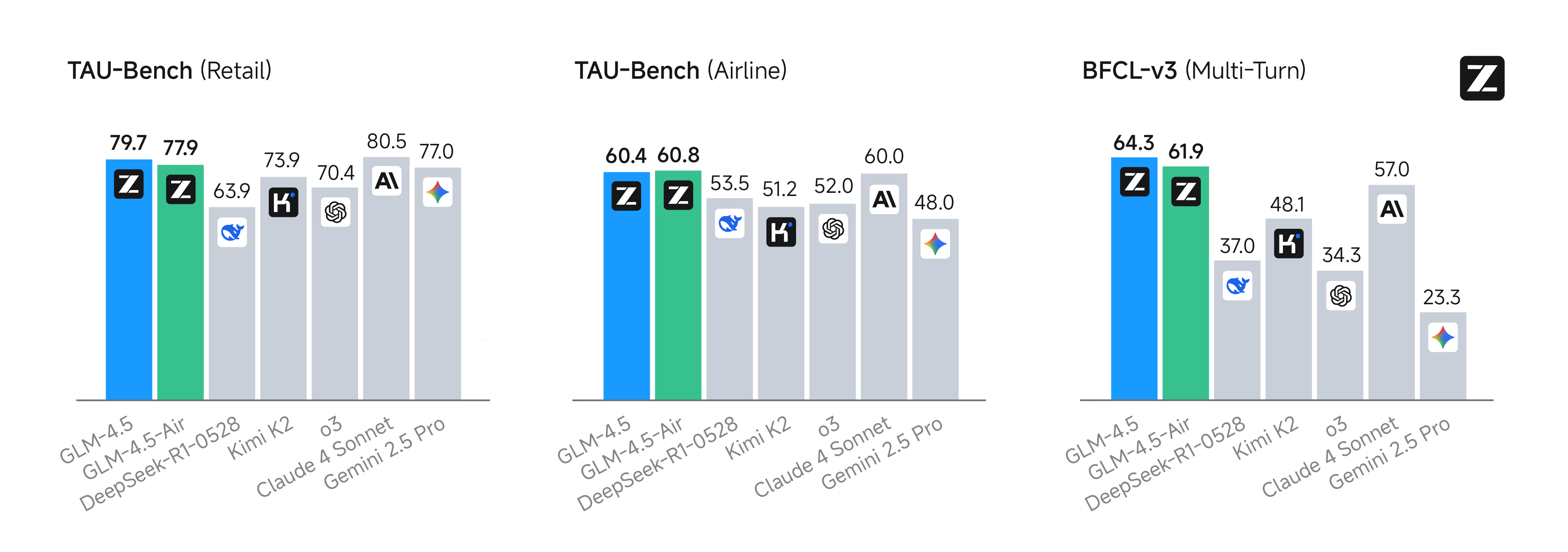

📊 Leistungskennzahlen für agentenbasierte Anwendungen

GLM-4.5-Air wurde speziell für agentenbasierte Anwendungen entwickelt und zeichnet sich durch sein robustes Kontextfenster mit 128.000 Token sowie integrierte Funktionsausführungsfunktionen aus. Auf führenden agentenbasierten Benchmarks wie τ-bench und BFCL-v3 erzielt es nahezu gleichwertige Ergebnisse wie Claude 4 SonettInsbesondere in spezialisierten Web-Browsing-Tests (BrowseComp), die komplexes mehrstufiges Denken und die Nutzung von Tools bewerten, zeigt GLM-4.5-Air eine 26,4% GenauigkeitsrateDies übertrifft Claude-4-Opus (18,8 %) und nähert sich dem Spitzenreiter o4-mini-high mit 28,3 % an. Diese Zahlen unterstreichen die ausgewogene und starke Leistung von GLM-4.5-Air in realen, toolgestützten Aufgaben und agentenbasierten Szenarien.

💡 Wichtigste Fähigkeiten

- Erweiterte Textgenerierung: Erzeugt flüssige, kontextgenaue Ausgaben, die sich für längere Inhalte und komplexe, mehrteilige Dialoge eignen.

- Effizientes agentenbasiertes Schließen: Verfügt über solide Programmier-, Denk- und Werkzeugnutzungsfähigkeiten sowohl im „Denkmodus“ (komplexe Problemlösung) als auch im „Nicht-Denkmodus“ (sofortige Reaktion).

- Ressourceneffizienz: Benötigt deutlich weniger GPU-Speicher (einsetzbar auf 16-GB-GPUs) und ist daher eine ausgezeichnete Wahl für reale, hardwarebeschränkte Umgebungen.

- Hochkompetitiv für praktische Entwicklungs- und Agentenaufgaben, bietet schnelle Codevorschläge und detaillierte Dokumentenanalyse.

💲 API-Preise

- Eingang: 0,21 $

- Ausgabe: 1,155 USD

Optimale Anwendungsfälle

- Kosteneffiziente Konversations-KI: Ideal für Chatbots und virtuelle Assistenten mit hohem Datenaufkommen und geringer Latenz.

- Leichtgewichtige Programmierhilfe: Bietet Echtzeit-Codevervollständigung, Debugging und effiziente Dokumentationsgenerierung.

- Komplexe Dokumentenanalyse: Fähig zur Analyse von juristischen, wissenschaftlichen und wirtschaftlichen Texten in großem Umfang.

- Mobile- und Edge-Bereitstellungen: Eignet sich hervorragend für Umgebungen mit begrenzten Hardware-Ressourcen.

- Agentische Werkzeuge: Unterstützt die Nutzung von Tools durch Agenten, bietet Funktionen zum Surfen im Web und ermöglicht die Stapelverarbeitung von Inhalten.

Codebeispiel

Vergleich mit anderen Modellen

Vs. Claude 4 Sonett: GLM-4.5-Air bietet ein ausgewogenes Verhältnis von Effizienz und Leistung, liegt aber bei bestimmten Kodierungs- und agentenbasierten Schlussfolgerungsaufgaben leicht hinter Claude 4 Sonnet zurück. Während Claude 4 Sonnet ein größeres Kontextfenster (200.000 Tokens gegenüber 128.000) unterstützt und Bildeingabefunktionen bietet (wodurch es sich besser für multimodale Anwendungen eignet), zeichnet sich GLM-4.5-Air durch Folgendes aus: Open Source, kostengünstiger und mit hoher Zuverlässigkeit bei Funktionsaufrufen und mehrstufiger Argumentation.Die

Im Vergleich zu GLM-4.5: GLM-4.5-Air erreicht etwa 80–98 % der Leistung des Flaggschiffs GLM-4.5, benötigt aber deutlich weniger aktive Parameter (12 Mrd. statt 32 Mrd.) und geringere Ressourcen. Obwohl es bei der reinen Aufgabenpräzision möglicherweise etwas hinterherhinkt, behält es seine soliden Fähigkeiten in den Bereichen logisches Denken, Codierung und Agentenverhalten bei und ist daher… besser geeignet für den Einsatz in hardwarebeschränkten UmgebungenDie

Vs. Qwen3-Coder: GLM-4.5-Air konkurriert effektiv mit Qwen3-Coder in Bezug auf Codierung und Werkzeugnutzung und liefert eine schnelle und präzise Codegenerierung für komplexe Programmieraufgaben. GLM-4.5-Air demonstriert dominante Erfolgsraten und zuverlässige Werkzeugrufmechanismen über Qwen3-Coder.

Vs. Gemini 2.5 Pro: Der GLM-4.5-Air kann in praktischen Logik- und Programmiertests mit dem Gemini 2.5 Pro mithalten. Obwohl der Gemini in einigen spezifischen Programmier- und Logiktests leicht besser abschneidet, bietet der GLM-4.5-Air eine günstiges Gleichgewicht zwischen großem Kontextfenster und agentenbasierten Werkzeugen, optimiert für effiziente Einsätze in der realen Welt.Die

Einschränkungen

- Die Gesamtleistung und die Anzahl der aktiven Parameter sind im Vergleich zum Flaggschiffmodell GLM-4.5 leicht reduziert.

- Bei einigen komplexen Aufgaben kann es zu leichten Leistungseinbußen kommen, die grundlegenden Text- und Codefunktionen bleiben jedoch robust.

- Nicht ideal für Organisationen, die absolute, hochmoderne Genauigkeit über alle anderen Erwägungen stellen.

- Eine optimale Nutzung des gesamten Kontextes und der Werkzeugunterstützungsfunktionen könnte eine neue Infrastruktur erfordern, um die beste Effizienz zu erzielen.

Häufig gestellte Fragen (FAQ)

❓ Was ist der Hauptvorteil der GLM-4.5-Air von Zhipu AI?

✔️ Der Hauptvorteil der GLM-4.5-Air liegt in ihrer außergewöhnlichen Effizienz und KosteneffektivitätDies wird durch ein Mixture-of-Experts (MoE)-Design mit 12 Milliarden aktiven Parametern erreicht, wodurch es äußerst ressourcenschonend ist.

❓ Welche Kontextfenstergröße hat GLM-4.5-Air?

✔️ Es zeichnet sich durch eine beträchtliche Kontextfenster mit 128.000 Tokenwodurch das Verstehen und Erstellen sehr langer und komplexer Texte ermöglicht wird.

❓ In welchen Bereichen zeigt GLM-4.5-Air eine starke Wettbewerbsleistung?

✔️ Es zeichnet sich aus durch Agentenbasierte Anwendungen, Web-Browsing (übertrifft Claude-4-Opus)und bietet eine starke Leistung beim Codieren, logischen Denken und der Werkzeugnutzung, insbesondere in hardwarebeschränkten Umgebungen.

❓ Was sind die optimalen Anwendungsfälle für GLM-4.5-Air?

✔️ Ideale Anwendungsfälle umfassen Kostengünstige dialogbasierte KI, einfache Unterstützung bei der Codierung, komplexe Dokumentenanalyse und Bereitstellung auf mobilen Geräten und Edge-GerätenDie

❓ Was sind die Hauptbeschränkungen von GLM-4.5-Air?

✔️ Zu den Hauptbeschränkungen gehört die im Vergleich zum Flaggschiff GLM-4.5 etwas geringere Gesamtleistung, wodurch es für anspruchsvolle Szenarien weniger geeignet ist. Absolute, hochmoderne Genauigkeit steht an erster StelleDie

KI-Spielplatz

Einloggen

Einloggen