const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'zhipu/glm-4.6',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="zhipu/glm-4.6",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Produktdetails

✨ GLM-4.6 API-Übersicht

GLM-4.6 ist ein fortschrittliches großes Sprachmodell, das von Zhipu AI (jetzt Z.ai)Es verfügt über einen hochmodernen 355-Milliarden-Parameter Mischung von Experten (MoE)-ArchitekturGLM-4.6 ist für ein breites Aufgabenspektrum optimiert, darunter komplexes Denken, Codierung, Schreiben und mehrstufige Dialoge, und bietet eine erweiterte Kontextfenster von 200.000 TokensDieses Modell bietet branchenführende Leistung, insbesondere bei Programmier- und agentenbasierten Aufgaben, und ist damit die erste Wahl für Entwickler und Unternehmen, die Effizienz und Vielseitigkeit suchen.

⚙️ Technische Spezifikationen

- Modellarchitektur: 355B-Parameter Mischung von Experten (MoE)

- Eingabemodalität: Text

- Ausgabemodalität: Text

- Kontextfenstergröße: 200.000 Token (erweitert von 128.000 in GLM-4.5)

- Maximale Ausgabetoken: 128.000 Token

- Effizienz: Etwa 30 % effizienterer Tokenverbrauch als frühere Versionen

- Unterstützte Programmiersprachen: Python, JavaScript, Java (für Programmieraufgaben)

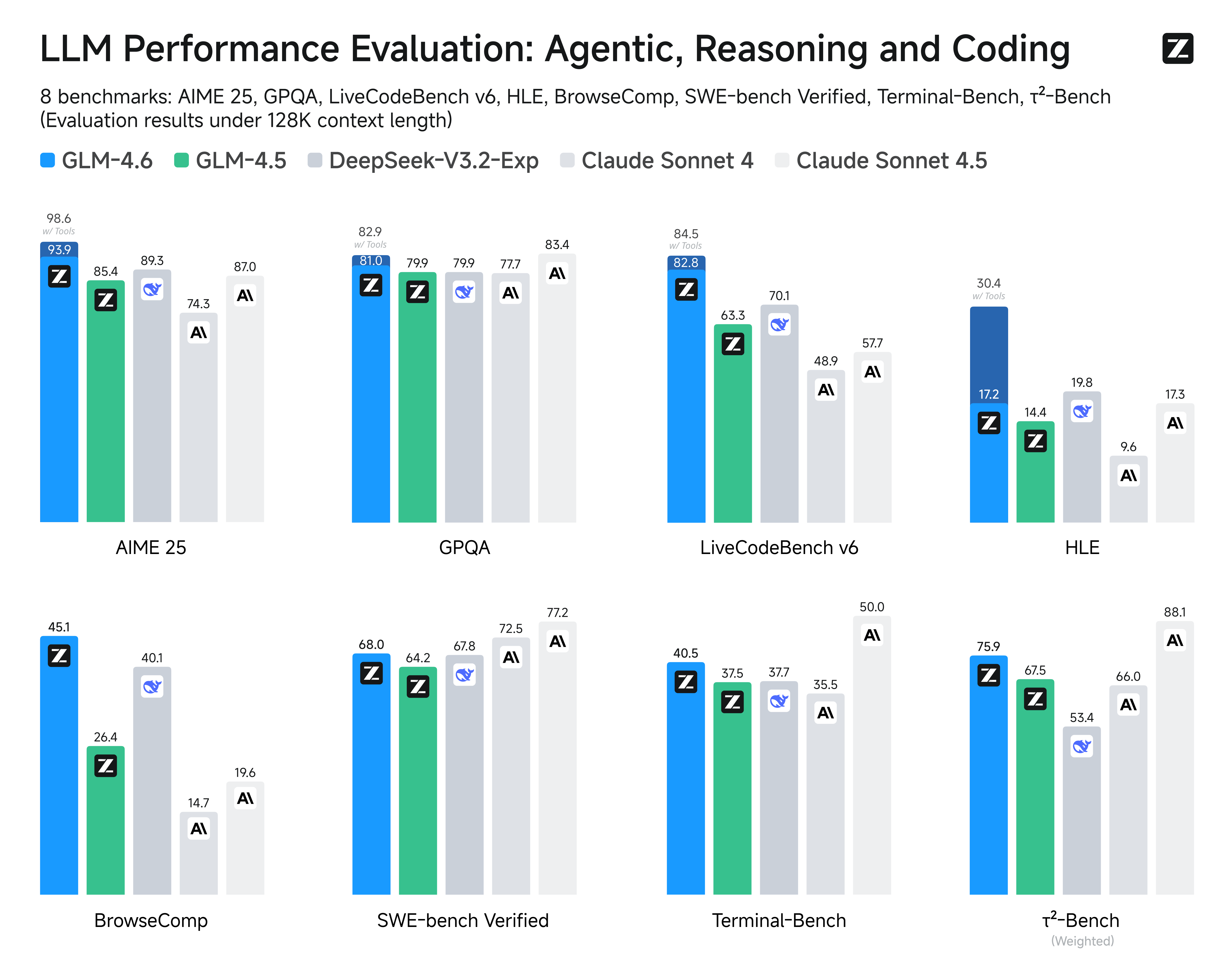

📈 Leistungsbenchmarks

GLM-4.6 wurde anhand maßgeblicher Benchmarks eingehend evaluiert und erzielte dabei konkurrenzfähige oder überlegene Ergebnisse im Vergleich zu führenden Modellen:

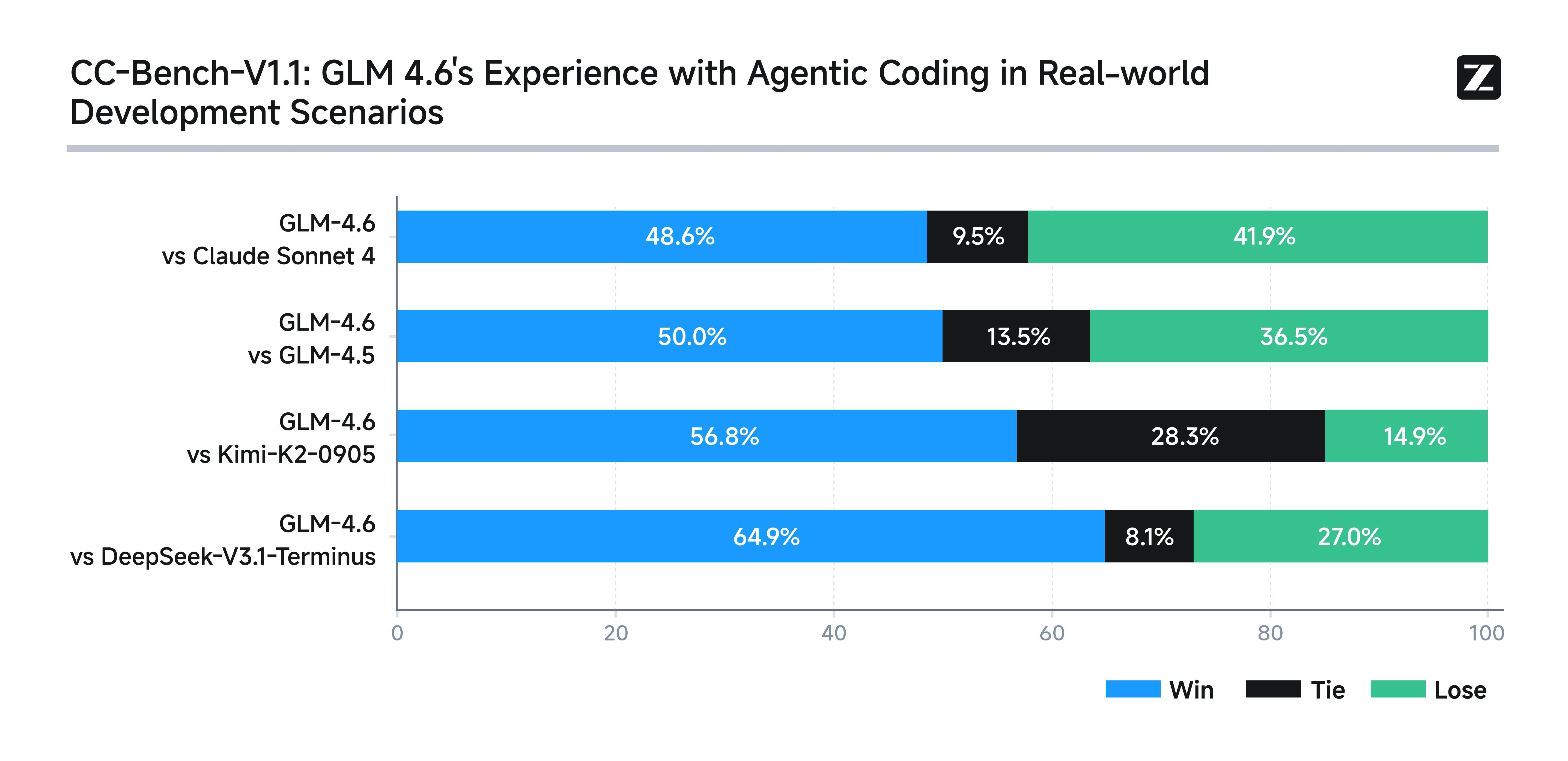

- Praxisnahe Programmiertests: Übertrifft vergleichbare inländische Modelle in 74 Codierungsszenarien und zeigt eine bessere Codekorrektheit und Leistung.

- Vergleich der Effizienz: Verbraucht etwa 30 % weniger Token für die gleiche Leistung, wodurch Kosten und Ressourcenbedarf reduziert werden.

- Benchmark-Ergebnisse: Vergleichbar mit Claude Sonnet 4 und 4.6 auf Multi-Domain-NLP-Benchmarks wie AIME, GPQA, LCB v6 und SWE-Bench Verified.

- Schlussfolgerungs- und Agentenaufgaben: Starke Leistungen bei Entscheidungsfindungs- und toolgestützten Aufgaben, die in Vergleichstests oft mit denen der Konkurrenz mithalten oder diese sogar übertreffen.

- Kontextuelles Verständnis: Der erweiterte Kontext ermöglicht eine überlegene Leistung bei Aufgaben, die eine tiefgehende Dokumentenanalyse und komplexe Anweisungen erfordern.

Abbildung: GLM-4.6 Leistungsbenchmarks

💡 Hauptmerkmale und Funktionen

- Erweiterte Kontextverarbeitung: Mit einem massiven 200K-Token-FensterGLM-4.6 ist in der Lage, detaillierte, längere Texte zu verstehen, mehrstufige Problemlösungen durchzuführen und kohärente, längere Dialoge aufrechtzuerhalten.

- Überragende Codierungsleistung: In 74 praktischen Programmiertests innerhalb der Claude Code-Umgebung übertrifft es GLM-4.5 und viele inländische Wettbewerber. Es zeichnet sich durch hervorragende Leistungen in der Frontend-Entwicklung, der Codeorganisation und der autonomen Planung aus.

- Fortgeschrittenes logisches Denken und Entscheidungsfindung: Erweiterte Möglichkeiten zur Werkzeugnutzung während der Inferenz ermöglichen bessere autonome Agenten-Frameworks und eine suchbasierte Aufgabenausführung.

- Generierung natürlicher Sprache: Erzeugt Texte mit verbesserter Ausrichtung an menschlichen Stilpräferenzen und eignet sich hervorragend für Rollenspiele, die Erstellung von Inhalten (Romane, Drehbücher, Werbung) und mehrstufige Dialoge.

Abbildung: GLM-4.6 – Hauptmerkmale und Funktionen

💰 GLM-4.6 API-Preisgestaltung

- Eingang: 0,63 $

- Ausgabe: 2,31 $

- Zwischengespeichert: 0,1155 USD

🚀 Anwendungsfälle für GLM-4.6

- Langkontext-Dokumentanalyse und Zusammenfassung

- Komplexe mehrstufige Argumentation und Problemlösung

- Programmierung in der Praxis und Codegenerierung in mehreren Sprachen

- Erstellung von Inhalten in natürlicher Sprache einschließlich kreativem Schreiben und Drehbüchern

- Chatbots mit anhaltenden, kohärenten, mehrstufigen Konversationen

- Agentische Systeme mit Werkzeugnutzung und autonomer Entscheidungsfindung

- Anwendungen im industriellen Maßstab mit hohem Durchsatz Token-effiziente Modelle erfordern

💻 Codebeispiel

Dieser Abschnitt würde typischerweise einen interaktiven Codeausschnitt zur API-Integration enthalten, z. B.:

import openai from openai import OpenAI # Für Zhipu AI (Z.ai) GLM-4.6 client = OpenAI( api_key= "YOUR_API_KEY" , base_url= "https://api.z.ai/v1" , # Beispiel-Basis-URL ) completion = client.chat.completions.create( model= "zhipu/glm-4.6" , messages=[ { "role" : "system" , "content" : "Du bist ein hilfreicher Assistent." }, { "role" : "user" , "content" : "Erkläre große Sprachmodelle in einfachen Worten." } ] ) print (completion.choices[0].message.content)⚖️ Vergleich mit anderen Modellen

Vs. GLM-4.5: GLM-4.6 bietet spürbare Verbesserungen bei der Genauigkeit der Codegenerierung und behält einen durchgängigen Vorsprung bei der Verarbeitung extrem langer Kontexteingaben bei, während die starke Leistung bei agentischen Aufgaben nahe an GLM-4.5 liegt.

Vs. OpenAI GPT-4.5: GLM-4.6 verringert die Lücke in der Genauigkeit beim logischen Denken und bei mehrstufigen Aufgaben, indem es sein viel größeres Kontextfenster nutzt; GPT-4.5 ist jedoch bei einigen standardisierten Benchmarks in Bezug auf die reine Aufgabenpräzision immer noch führend.

Vs. Claude 4 Sonett: Während Claude 4 Sonnet sich durch hervorragende Codierung und Multiagenten-Effizienz auszeichnet, erreicht oder übertrifft GLM-4.6 dies beim agentenbasierten Schließen und beim Verständnis langer Dokumente, wodurch es sich besser für Anwendungen mit erweitertem Kontext eignet.

Vs. Gemini 2.5 Pro: GLM-4.6 vereint fortgeschrittene Schlussfolgerungs- und Kodierungsfähigkeiten mit einem verbesserten Verständnis längerer Dokumente, während Gemini 2.5 Pro sich stärker auf die Optimierung einzelner Kodierungs- und Schlussfolgerungs-Benchmarks konzentriert.

🔗 API-Integration

Zugriff über eine KI/ML-API. Ausführliche Dokumentation finden Sie hier: GLM-4.6 API-DokumentationDie

❓ Häufig gestellte Fragen (FAQ)

Frage 1: Was ist GLM-4.6 und welche wesentlichen Verbesserungen bietet es?

GLM-4.6 ist die neueste Version der General Language Model-Reihe von Zhipu AI und zeichnet sich durch deutliche Verbesserungen in den Bereichen Schlussfolgerungsfähigkeit, Mehrsprachigkeit und spezialisiertes Domänenwissen aus. Zu den wichtigsten Verbesserungen gehören fortgeschrittene mathematische und logische Schlussfolgerungen, eine optimierte Codegenerierung und -analyse, eine verbesserte Mehrsprachigkeitsunterstützung mit herausragenden Fähigkeiten für die chinesische Sprache sowie eine höhere Effizienz bei der Verarbeitung komplexer, mehrstufiger Aufgaben.

Frage 2: Wie schneidet GLM-4.6 im Vergleich zu anderen führenden Sprachmodellen wie GPT-4 und Claude ab?

GLM-4.6 erzielt vergleichbare Ergebnisse wie führende Modelle und zeichnet sich insbesondere bei Aufgaben zur chinesischen Sprache, mathematischem Denken und Programmieranwendungen aus. Obwohl es im Bereich kreatives Schreiben andere Stärken als GPT-4 oder im Bereich Sicherheitsalignment andere als Claude aufweisen mag, erreicht oder übertrifft es vergleichbare Modelle in technischen Bereichen und beim Verständnis asiatischer Sprachen häufig. Seine effiziente Architektur bietet zudem Kostenvorteile für viele Unternehmensanwendungen.

Q3: Was sind die wichtigsten technischen Neuerungen in der Architektur von GLM-4.6?

GLM-4.6 führt mehrere architektonische Neuerungen ein: verbesserte Aufmerksamkeitsmechanismen für eine optimierte Verarbeitung langer Kontexte, optimierte Trainingsmethoden für mathematisches und logisches Schließen, optimierte Tokenisierung für mehrsprachige Effizienz, fortschrittliche Feinabstimmungsverfahren für spezialisierte Domänen sowie eine höhere Parametereffizienz, die eine starke Leistung ohne extremen Skalierungsbedarf ermöglicht. Diese Innovationen tragen zu seiner ausgewogenen Leistung bei unterschiedlichsten Aufgaben bei.

Q4: Für welche praktischen Anwendungen eignet sich GLM-4.6 besonders gut?

GLM-4.6 zeichnet sich durch seine Stärken in folgenden Bereichen aus: Unternehmensanwendungen in asiatischen Märkten mit hohem Bedarf an chinesischer Sprachunterstützung, technische Dokumentation und Codegenerierung, mathematische und wissenschaftliche Analysen, Lernwerkzeuge für MINT-Fächer, Business Intelligence und Datenanalyse sowie mehrsprachige Kundenservice-Automatisierung. Seine ausgewogene Leistungsfähigkeit macht es vielseitig einsetzbar für kreative und analytische Aufgaben in verschiedenen Branchen.

Frage 5: Wie geht GLM-4.6 mit mehrsprachigen und interkulturellen Anwendungen um?

GLM-4.6 zeichnet sich durch ausgefeilte mehrsprachige Funktionen aus, insbesondere im Chinesischen und anderen asiatischen Sprachen. Dazu gehören das Verständnis kultureller Kontexte, Redewendungen und regionaler Variationen. Das Modell demonstriert ein starkes Transferlernen über verschiedene Sprachen hinweg und erzielt so auch bei ungleichmäßiger Verteilung der Trainingsdaten auf die verschiedenen Sprachen hinweg eine hohe Leistungsfähigkeit. Dies macht es besonders wertvoll für global agierende Unternehmen, die in asiatischen Märkten tätig sind oder eine umfassende mehrsprachige Unterstützung benötigen.

KI-Spielplatz

Einloggen

Einloggen