const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-max-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-max-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Produktdetails

Entdecken Qwen3-Max AnleitungAlibabas bahnbrechendes großes Sprachmodell (LLM) wurde Anfang 2025 offiziell vorgestellt. Dieses Vorzeigemodell der KI verfügt über mehr als 1 Billion ParameterDies stellt einen bedeutenden Fortschritt im Bereich der groß angelegten künstlichen Intelligenz dar. Qwen3-Max Instruct wurde anhand massiver Datensätze mit einer fortschrittlichen Architektur trainiert und demonstriert außergewöhnliche Fähigkeiten, insbesondere in technische, Programmier- und mathematische AufgabenDiese auf Anweisungen abgestimmte Variante ist speziell optimiert für schnelle, direkte Anweisung folgenDadurch entfällt die Notwendigkeit schrittweiser Überlegungen und es werden schnelle, präzise Antworten geliefert.

✨ Technische Daten: Unübertroffene Leistung

- 🚀 Parameterskala: Über 1 Billion Parameter (Billionen-Skala)

- 💾 Trainingsdaten: 36 Billionen Token an Vortrainingsdaten

- 🧠 Modellarchitektur: Mischung von Experten (MoE)-Transformator mit globalem Batch-Lastausgleich für Effizienz

- 📚 Kontextlänge: Bis zu 262.144 Token (Unterstützung von über 258.000 Eingabe- und 65.000 Ausgabetoken)

- ⚡ Trainingseffizienz: 30 % MFU-Verbesserung gegenüber den Qwen 2.5 Max-Modellen der vorherigen Generation

- 🗣️ Unterstützte Sprachen: Mehr als 100 Sprachen, mit speziellen Verbesserungen für gemischte chinesisch-englische Kontexte.

- 💡 Inferenzmodus: Nicht-Denkmodus, Priorität auf schnelle, direkte Anweisungen (Denkversion in Entwicklung)

- 🔄 Kontext-Caching: Ermöglicht die Wiederverwendung von Kontextschlüsseln, um die Leistung in mehrstufigen Gesprächen deutlich zu verbessern.

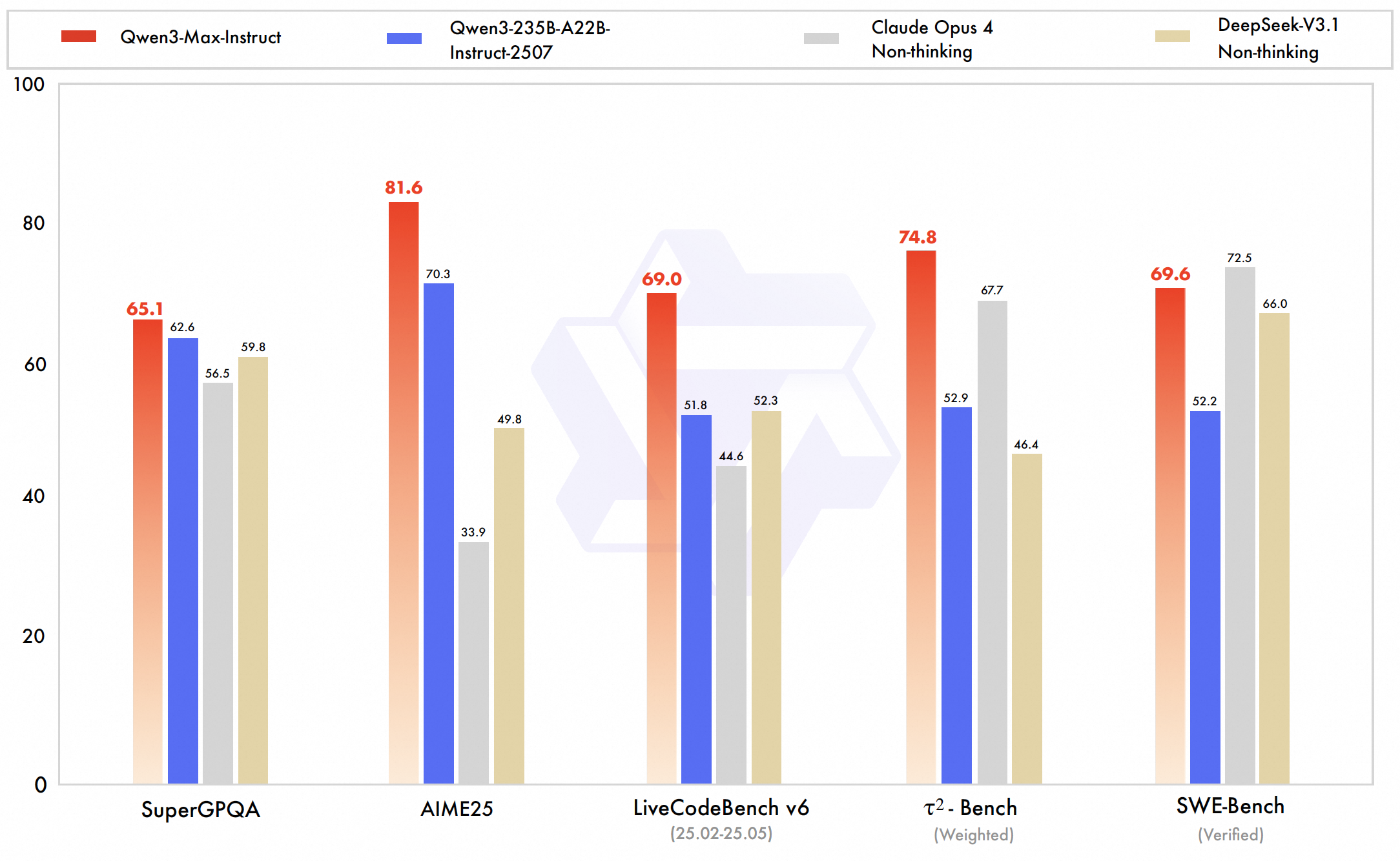

📊 Leistungsbenchmarks und Highlights: Neue Maßstäbe setzen

Qwen3-Max erzielt Weltklasse-Leistung und zeichnet sich insbesondere durch folgende Merkmale aus: Programmierung, mathematisches Denken und technische BereicheDie internen Tests und Ranglistenergebnisse von Alibaba bestätigen die Überlegenheit bzw. Gleichwertigkeit von Alibaba gegenüber erstklassigen KI-Modellen wie GPT-5-Chat, Claude Opus 4 und DeepSeek V3.1 in mehreren Benchmarks.

- 💻 SWE-Bench-verifiziert: 69,6 (zeigt ausgeprägte Fähigkeiten im Lösen realer Programmierherausforderungen)

- 🔬 Tau2-Bench: 74,8 (übertrifft Claude Opus 4 und DeepSeek V3.1)

- ❓ SuperGPQA: 81,4 (Leistung bei der Beantwortung suggestiver Fragen)

- ✍️ LiveCodeBench: Hervorragende Ergebnisse bei der Realcode-Herausforderung

- 🧮 AIME25 (Mathematisches Denken): 80,6 (übertrifft viele Konkurrenten)

- 🏆 Arena-Schwer v2: 86.1 (starke Leistung bei schwierigen Aufgaben)

- 🏅 LM Arena-Rangliste: Insgesamt Platz 6, wobei viele hochmoderne Modelle mit Ausnahme führender Konversationsmodelle wie GPT-4o übertroffen wurden.

💰 API-Preisgestaltung: Kosteneffiziente KI im großen Maßstab

- Eingangspreis: 1,26 $ pro Million Token

- Ausgabepreis: 6,30 € pro Million Token

💡 Wichtigste Anwendungsfälle: Förderung von Unternehmensinnovationen

- 🏢 Unternehmensanwendungen: Ideal für technische Bereiche, die eine umfangreiche Kontextverarbeitung erfordern, wie zum Beispiel Codegenerierung, mathematische Modellierung und ForschungsunterstützungDie

- 🌍 Mehrsprachige Unterstützung: Robuste zweisprachige und internationale Anwendungen mit starke chinesisch-englische MischsprachenkompetenzDie

- 📜 Riesige Kontextfenster: Ermöglicht das Verständnis extrem langer Dokumente und mehrstufige Dialoge mit Persistenz.

- 🛠️ Werkzeug einsatzbereit: Optimiert für die abfragegestützte Generierung und Integration mit externen Tools.

- 🚀 Schnelle Reaktionen: Priorisiert die schnelle Ausführung von Anweisungen ohne unnötigen Denkprozess.

- 🔗 Ökosystemintegration: Teil der Qwen3-Familie von Alibaba, einschließlich Varianten für Bildverarbeitung und logisches Denken (Qwen-VL-Max und Qwen3-Max-Thinking).

💻 Codebeispiel: Erste Schritte

OpenAI importieren

client = openai. OpenAI (

base_url= "https://api.ai.cc/v1" ,

api_key= "IHR_API-SCHLÜSSEL" ,

)

chat_completion = client.chat.completions.create (

model= "alibaba/qwen3-max-instruct" ,

Nachrichten=[

{

"Rolle" : "System" ,

"content" : "Du bist ein hilfreicher KI-Assistent." ,

},

{

"Rolle" : "Benutzer" ,

"content" : "Erklären Sie das Konzept der Quantenverschränkung in einfachen Worten." ,

},

],

max_tokens=500,

Temperatur=0,7

)

print(chat_completion.choices[0].message.content) 🆚 Vergleich mit anderen führenden Modellen

vs GPT-5-Chat: Qwen3-Max Instruct übernimmt die Führung in Codierungsbenchmarks und AgentenfähigkeitenGPT-5-Chat zeigt starke Leistungen bei komplexen Softwareentwicklungsaufgaben. Allerdings profitiert es von einem ausgereifteren Ökosystem mit umfassenderen multimodalen Funktionen und breiteren kommerziellen Integrationen. Insbesondere bietet Qwen ein deutlich größeres Kontextfenster (~262.000 Token) im Vergleich zu den ~100.000 Token von GPT-5.

vs Claude Opus 4: Qwen3-Max übertrifft Claude Opus 4 sowohl in Bezug auf die Agenten- als auch auf die Codierungsleistung und unterstützt zudem deutlich größere Kontextgrößen. Claude zeichnet sich durch seine Stärken bei lang andauernden Agenten-Workflows und sicherheitsorientiertem Verhalten aus und ist daher in bestimmten Bereichen ein starker Konkurrent. Beide Modelle weisen eine vergleichbare Gesamtleistung auf, wobei Claude bei konservativen Codebearbeitungsaufgaben weiterhin die Nase vorn hat.

vs DeepSeek V3.1: Qwen3-Max übertrifft DeepSeek V3.1 in wichtigen Agenten-Benchmarks wie Tau2-Bench und verschiedenen Programmieraufgaben und demonstriert damit stärkere Fähigkeiten im logischen Denken und im Umgang mit Werkzeugen. Obwohl DeepSeek multimodale Eingaben unterstützt, bleibt es bei der Verarbeitung erweiterter Kontexte hinter Qwen zurück. Die fortschrittlichen Trainings- und Skalierungsinnovationen von Qwen bestätigen seine Führungsrolle bei umfangreichen und komplexen Aufgaben.

🔌 API-Integration: Nahtloser Zugriff

Qwen3-Max Instruct ist über die KI/ML-API leicht zugänglich. Eine umfassende Dokumentation ist verfügbar. Hier verfügbar für Entwickler, die eine nahtlose Integration anstreben.

❓ Häufig gestellte Fragen (FAQ)

F: Welche architektonischen Fortschritte zeichnen die Befehlsausführungsfähigkeiten von Qwen3-Max Instruct aus?

A: Qwen3-Max Instruct nutzt ein revolutionäres Framework zur Befehlsoptimierung, das überwachtes Feintuning mit bestärkendem Lernen durch menschliches Feedback in einem bisher unerreichten Umfang kombiniert. Die Architektur zeichnet sich durch ein mehrstufiges Befehlsverständnis aus und analysiert komplexe Anweisungen mit differenzierten Einschränkungen und bedingter Logik. Fortschrittliche Aufmerksamkeitsmechanismen gewichten Befehlskomponenten dynamisch, während spezialisierte Denkprozesse je nach Befehlstyp aktiviert werden, um die präzise Umsetzung der Benutzerabsicht zu gewährleisten.

F: Wie erzielt Qwen3-Max Instruct seine bahnbrechende Leistung bei komplexen, multimodalen Anweisungen?

A: Das Modell integriert die modalitätsübergreifende Befehlsverarbeitung und das Verstehen und Ausführen von Anweisungen in Texten, Code, mathematischer Notation und konzeptionellen Diagrammen durch einheitliches Repräsentationslernen. Es verwendet hierarchische Befehlszerlegung, um komplexe Anfragen in ausführbare Teilaufgaben mit Abhängigkeitsverfolgung zu zerlegen. Fortschrittliche Constraint-Satisfaction-Algorithmen gewährleisten die Erfüllung aller Anforderungen, während die dynamische Stilanpassung den gewünschten Tonfall und das Format berücksichtigt.

F: Welche speziellen Funktionen zur Befehlsausführung machen dieses Modell besonders geeignet für Unternehmensanwendungen?

A: Qwen3-Max Instruct bietet Funktionen für die Befehlsverarbeitung auf Unternehmensebene, darunter die präzise Einhaltung von Formatierungsstandards, die konsistente Anwendung von Markenrichtlinien, die akkurate Ausführung technischer Spezifikationen und die zuverlässige Erfüllung regulatorischer Anforderungen. Es zeichnet sich durch die Verarbeitung branchenspezifischer Befehle mit domänenspezifischer Interpretation aus, gewährleistet Kontextbewusstsein über längere Sequenzen hinweg und liefert transparente Ausführungsprotokolle zur Verifizierung.

F: Wie geht das Modell mit mehrdeutigen oder widersprüchlichen Anweisungen um und behält dabei seine Nützlichkeit bei?

A: Die Architektur beinhaltet ausgefeilte Mechanismen zur Befehlsauflösung, die Mehrdeutigkeiten, potenzielle Konflikte und ungenau spezifizierte Elemente durch probabilistisches Schließen und Kontextanalyse identifizieren. Bei mehrdeutigen Befehlen verwendet das Modell Klärungsprotokolle, die Interpretationen vorschlagen und gleichzeitig Flexibilität gewährleisten. Bei widersprüchlichen Anweisungen implementiert es eine prioritätsbasierte Auflösung mithilfe erlernter Hierarchien der Benutzerabsicht, wodurch sowohl die Befehlsgenauigkeit als auch die praktische Anwendbarkeit sichergestellt werden.

F: Welche Sicherheits- und Ausrichtungsmerkmale gewährleisten eine verantwortungsvolle Ausführung der Anweisungen?

A: Qwen3-Max Instruct integriert eine mehrstufige Sicherheitsprüfung, die Anweisungen vor ihrer Ausführung anhand ethischer Richtlinien und potenzieller Risiken bewertet. Das Modell beinhaltet die Bereinigung von Anweisungen, um schädliche Uminterpretationen zu neutralisieren, eine werterhaltende Ausführung unter Einhaltung ethischer Vorgaben sowie eine transparente Begründung sicherheitsrelevanter Entscheidungen. Diese Schutzmechanismen gewährleisten, dass das Modell auch bei der Ausführung komplexer, ergebnisoffener Anweisungen hilfreich, unschädlich und integer bleibt.

KI-Spielplatz

Einloggen

Einloggen