const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'deepseek/deepseek-non-reasoner-v3.1-terminus',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="deepseek/deepseek-non-reasoner-v3.1-terminus",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

产品详情

✨ DeepSeek V3.1 聊天 是一种专注于以下方面的专业混合对话式人工智能模型: 快速、直接的回应 无需进行复杂的推理。该变体基于 DeepSeek V3.1 架构构建。 省略了思考模式 它优先考虑低延迟输出,同时保持强大的多模态功能。它针对需要在聊天、代码生成和代理工作流程中进行高效、直接交互的应用进行了优化,适合重视快速响应时间和精简任务执行的开发人员和企业。

技术规格

- 上下文窗口向上 128K Tokens 支持长时间的多轮对话和代码编写。

- 输出令牌限制最高为 8,000 个Tokens 旨在提供简洁、连贯的答案。

- 混合变压器架构 专家混合(MoE)层 为了实现高效的计算资源分配。

- 支持结构化工具调用、代码代理功能和搜索代理,以增强任务灵活性。

- 使用 FP8 微扩展技术对长上下文数据集进行扩展训练,以提高推理效率。

- 支持多语言 100多种语言 具有很高的上下文准确性。

主要特点

🚀 DeepSeek V3.1 聊天功能仅在以下环境中运行 非思考模式 能够实现 快速、直接的回答 无需进行多步骤推理。这种配置允许极其 低延迟交互 该模型非常适合简单的查询和任务执行。它保留了增强的工具和代理调用功能,能够与代码代理和搜索代理无缝集成,从而实现多样化的工作流程。该模型基于优化的 MoE Transformer 架构构建,在支持结构化函数调用以实现精确工具调用的同时,实现了高效的资源利用。虽然它不具备深度推理能力,但它非常适合多模态聊天、快速代码生成以及需要快速可靠输出的精简代理工作流程。

性能和能力

- ⚡ 快速响应时间 优化工具利用率,最大限度地减少计算开销。

- 直接代码生成和任务执行准确率高,错误率低。

- 有效处理包括文本和图像在内的多模态输入,专注于非推理任务。

- 可扩展应用于软件工程、研究辅助和代理应用环境。

用例

- 快速软件工程协助,包括代码合成和调试。

- 专注于图像和文本理解并能快速响应的多模态聊天机器人。

- 对背景信息要求不高,需要进行常规的研究和文件分析。

- 高效的多轮对话,适用于基础任务导向型教育工具。

- 强调快速可视化数据解读的商业智能流程。

- 需要调用智能工具但不需要深度推理开销的代理应用程序。

API定价

• 100万个输入令牌: 0.294美元

• 100万个输出Tokens: 0.441美元

代码示例

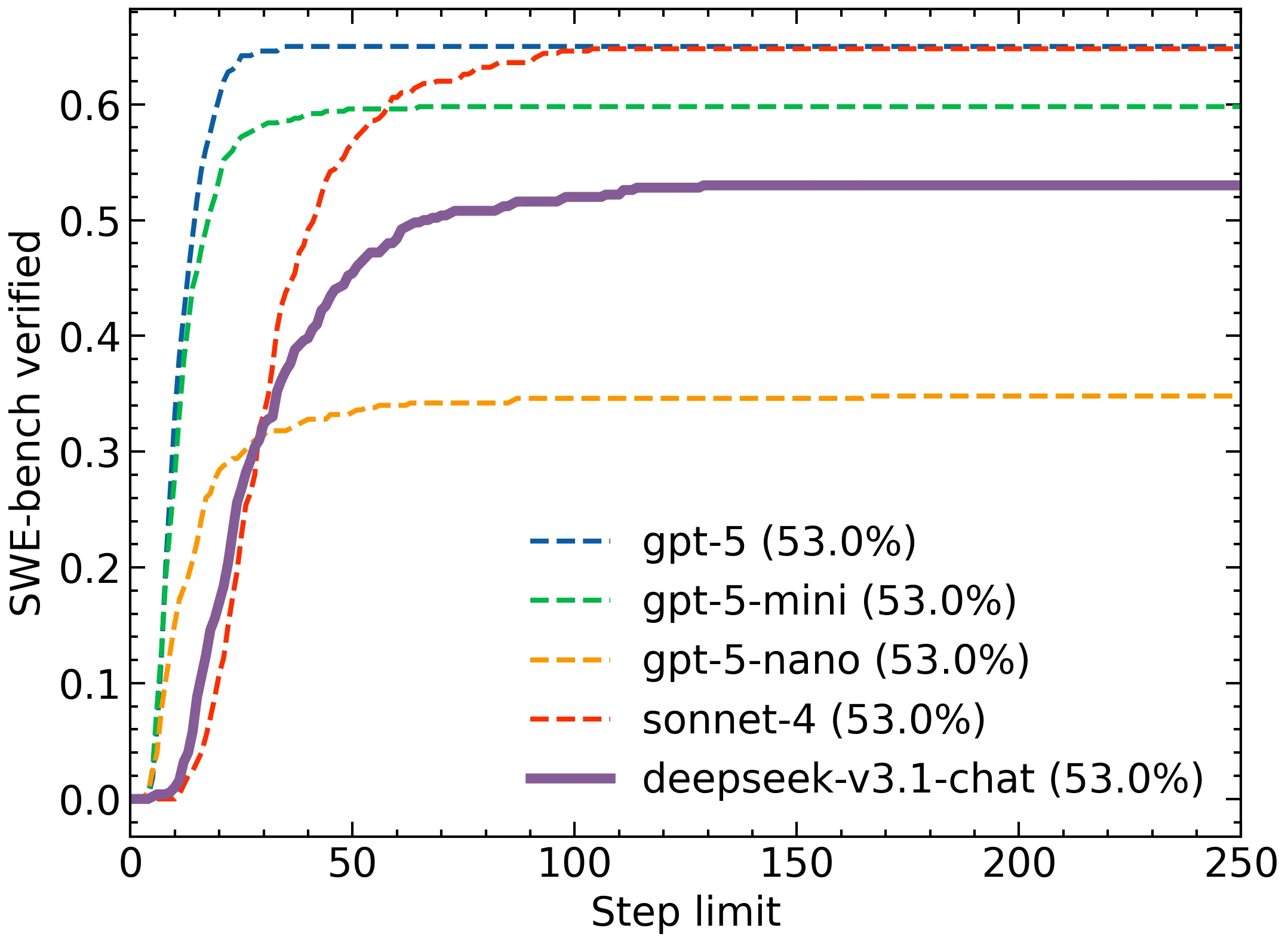

与其他型号的比较

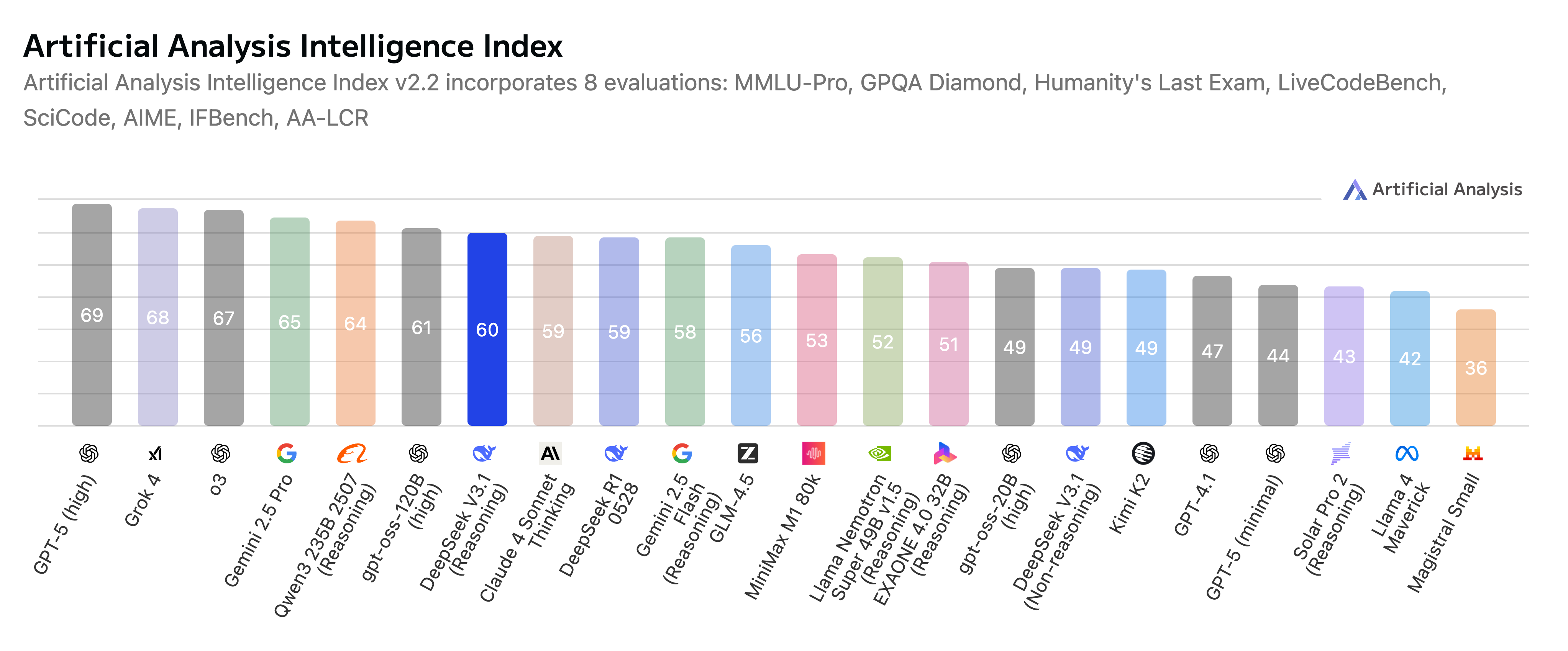

DeepSeek V3.1 Chat 在高速推理、强大的多模态集成和成本效益之间实现了最佳平衡,尤其适用于无需深度推理的应用场景。它专为注重速度和简化多模态对话式 AI 和代理工作流程任务执行的开发者和企业而设计。

💡 对比 GPT-5: 尽管 GPT-5 拥有更大的 40 万个词元上下文窗口,并涵盖了新兴的音频/视频模态以及文本和图像功能,但 DeepSeek V3.1 Chat 的优势在于更深入地集成了视觉上下文操作、用于高效计算的动态专家模块化以及先进的领域自适应工具。DeepSeek 提供了一种强大的开放权重模型方法,具有成本优势,并专注于复杂的图像推理和多模态融合;而 GPT-5 则在上下文规模和多模态广度方面领先,并集成了企业生态系统。

💡 对比 DeepSeek V3: 新版本将推理速度提升了约 30%,将上下文窗口从 128K 扩展到更灵活、更适合聊天任务的规模,并显著提高了多模态对齐的准确率。这些改进使其推理能力更强,尤其是在低资源语言和复杂视觉场景下,从而更适用于高级对话式 AI 和大规模代码理解。

💡 对比 OpenAI GPT-4.1: 与 GPT-4.1 以代码优化和文本为中心的架构相比,DeepSeek V3.1 通过复杂的专家混合模型训练机制,平衡了大规模多模态输入。这种平衡带来了更优异的视觉-文本一致性,并能更快地适应各种多模态任务,使得 DeepSeek 特别适用于需要将文本和图像无缝集成并进行高级推理的工作流程。

常见问题解答 (FAQ)

DeepSeek V3.1聊天功能的核心目的是什么?

DeepSeek V3.1 聊天功能专为……而设计 快速、直接的对话式人工智能优先考虑对简单查询和任务执行提供低延迟响应,而不是复杂的多步骤推理。

DeepSeek V3.1聊天功能是如何实现快速响应的?

该模型仅在一种情况下运行 “非思考”模式它省略了多步骤推理,可立即输出结果。其优化的混合专家(MoE)Transformer架构也有助于提高资源利用效率和速度。

DeepSeek V3.1 Chat 提供哪些多模态功能?

它具备强大的多模态能力,支持跨模态的高效交互。 文字和图片 即使没有深度推理功能,也能胜任多模态聊天和快速代码生成等任务。

DeepSeek V3.1 Chat 在哪些场景下最为有效?

它针对需要以下功能的应用程序进行了优化: 高效、直接的互动 在聊天、代码生成和代理工作流程中,对于重视快速响应时间和简化任务执行的开发人员和企业来说,这是一个理想的选择。

登录

登录