const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-max-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-max-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

产品详情

发现 Qwen3-Max 指导阿里巴巴突破性的大型语言模型(LLM)将于2025年初正式发布。这款旗舰级AI模型拥有超过 1万亿个参数这标志着大规模人工智能领域的一次重大飞跃。Qwen3-Max Instruct 采用先进的架构,在海量数据集上进行训练,展现出卓越的性能,尤其是在以下方面: 技术、代码和数学任务这种经过指令优化的变体专门针对以下情况进行了优化: 快速、直接的指令遵循无需逐步推理,即可提供快速、准确的响应。

✨ 技术规格:无与伦比的动力

- 🚀 参数比例: 超过1万亿个参数(万亿级规模)

- 💾 训练数据: 36万亿个预训练数据标记

- 🧠 模型架构: 专家混合模型(MoE)变压器采用全局批量负载均衡以提高效率

- 📚 上下文长度: 最多可容纳 262,144 个Tokens(支持超过 258k 个输入Tokens + 65k 个输出Tokens)

- ⚡ 训练效率: 与上一代 Qwen 2.5 Max 型号相比,MFU 性能提升 30%。

- 🗣️ 支持的语言: 支持100多种语言,并针对中英混合环境进行了专门优化。

- 💡推理模式: 非思考模式,优先考虑快速、直接的指令式回答(思考模式正在开发中)

- 🔄 上下文缓存: 支持重用上下文键,从而显著提升多轮对话性能

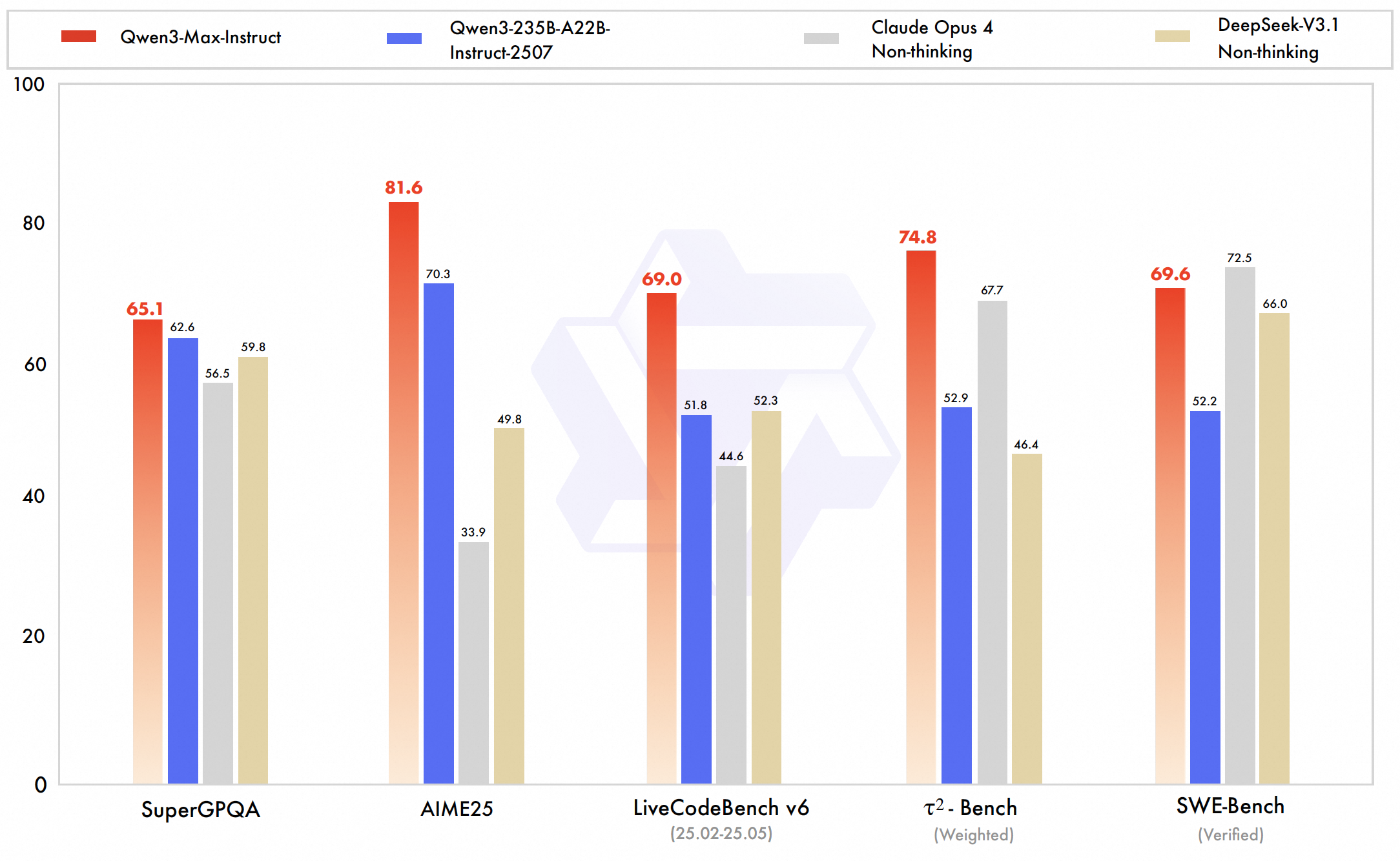

📊 性能基准和亮点:树立新标准

Qwen3-Max 达到了世界一流水平,尤其在以下方面表现卓越: 代码、数学推理和技术领域阿里巴巴的内部测试和排行榜结果证实,在多个基准测试中,其性能优于或等同于 GPT-5-Chat、Claude Opus 4 和 DeepSeek V3.1 等顶级 AI 模型。

- 💻 SWE-Bench 认证: 69.6 (展现出强大的实际编程挑战解决能力)

- 🔬 Tau2-Bench: 74.8 (优于 Claude Opus 4 和 DeepSeek V3.1)

- ❓ SuperGPQA: 81.4 (领先的问答表现)

- ✍️ LiveCodeBench: 出色的实战挑战成绩

- 🧮 AIME25(数学推理): 80.6 (表现优于许多竞争对手)

- 🏆 Arena-Hard v2: 86.1 (在困难任务中表现出色)

- 🏅 LM 竞技场排名: 总体排名第六,击败了许多最先进的模型,但略逊于 GPT-4o 等顶级对话模型。

💰 API 定价:经济高效的大规模人工智能

- 投入价格: 1.26美元 每百万Tokens

- 产出价格: 6.30美元 每百万Tokens

💡 主要应用案例:助力企业创新

- 🏢 企业应用: 非常适合需要大量上下文处理的技术领域,例如 代码生成、数学建模和研究协助。

- 🌍 多语言支持: 功能强大的双语和国际化应用程序 中英混合语言处理能力强。

- 📜 超大上下文窗口: 支持超长文档理解和多轮对话,并具有持久性。

- 🛠️ 工具使用准备就绪: 针对检索增强生成和与外部工具集成进行了优化。

- 🚀快速回复: 优先执行快速指令,避免逻辑推理的开销。

- 🔗 生态系统整合: 阿里巴巴 Qwen3 系列产品的一部分,包括视觉和推理变体(Qwen-VL-Max 和 Qwen3-Max-Thinking)。

💻 代码示例:入门指南

导入openai

客户端 = openai.OpenAI (

base_url= "https://api.ai.cc/v1" ,

api_key= "您的API密钥" ,

)

chat_completion = client.chat.completions.create (

model= “alibaba/qwen3-max-instruct” ,

messages=[

{

"角色" : "系统" ,

内容: “你是一个有用的AI助手。”

},

{

"角色" : "用户" ,

内容: “用简单的语言解释量子纠缠的概念。”

},

],

max_tokens=500,

温度=0.7,

)

print(chat_completion.choices[0].message.content) 🆚 与其他领先型号的比较

对比 GPT-5-聊天: Qwen3-Max Instruct 在 编码基准和代理能力GPT-5-Chat 在复杂的软件工程任务中表现出色。然而,它受益于更成熟的生态系统,拥有更广泛的多模态功能和更广泛的商业集成。值得注意的是,Qwen 提供的上下文窗口(约 26.2 万个词元)远大于 GPT-5 的约 10 万个词元。

对比 Claude作品4: Qwen3-Max 在代理和编码性能基准测试中均超越了 Claude Opus 4,同时还支持更大的上下文规模。Claude 在长时间代理工作流程和注重安全性的行为方面表现出色,使其成为特定领域的有力竞争者。尽管两款模型在整体性能上不相上下,但 Claude 在保守的代码编辑任务中略胜一筹。

对比 DeepSeek V3.1: Qwen3-Max 在 Tau2-Bench 等关键智能体基准测试和各种编程挑战中均优于 DeepSeek V3.1,展现出更强的推理能力和工具使用能力。尽管 DeepSeek 支持多模态输入,但在扩展上下文处理方面仍落后于 Qwen。Qwen 先进的训练和扩展创新进一步巩固了其在大规模复杂任务中的领先地位。

🔌 API 集成:无缝访问

Qwen3-Max Instruct 可通过 AI/ML API 轻松访问。完整的文档如下: 此处提供 面向寻求无缝集成的开发者。

❓ 常见问题解答 (FAQ)

问:Qwen3-Max Instruct 的指令跟随功能有哪些独特的架构优势?

答:Qwen3-Max Instruct 采用了一种革命性的指令调优框架,以前所未有的规模将监督式微调与基于人类反馈的强化学习相结合。其架构具有多粒度指令理解能力,能够解析包含细微约束和条件逻辑的复杂指令。先进的注意力机制动态地为指令组件赋予权重,同时根据指令类型激活专门的推理路径,从而确保精准地遵循用户意图。

问:Qwen3-Max Instruct 是如何在处理复杂的多模态指令时取得突破性性能的?

答:该模型整合了跨模态指令处理,通过统一的表征学习,能够理解并执行文本、代码、数学符号和概念图中的指令。它采用分层指令分解方法,将复杂的请求分解为可执行的子任务,并跟踪依赖关系。先进的约束满足算法确保满足所有要求,而动态风格自适应则能匹配请求的语气和格式。

问:该模型有哪些专门的指令执行功能使其在企业应用中脱颖而出?

答:Qwen3-Max Instruct 提供企业级指令处理能力,包括严格遵循业务格式标准、一致应用品牌语音指南、准确执行技术规范以及可靠地符合监管要求。它擅长处理行业特定指令,并能进行领域感知解释,在扩展序列中保持上下文感知,并提供透明的执行跟踪以供验证。

问:该模型如何处理含糊不清或相互矛盾的指令,同时保持其有效性?

答:该架构融合了复杂的指令解析机制,通过概率推理和上下文分析识别歧义、潜在冲突和未明确说明的元素。当遇到歧义指令时,模型会采用澄清协议,在保持灵活性的同时提供解释建议。对于冲突指令,它会利用学习到的用户意图层级结构,实现基于优先级的解析,从而确保指令的准确性和实用性。

问:哪些安全和对齐功能可确保指令的正确执行?

答:Qwen3-Max Instruct 包含多层安全验证,在执行指令前,会根据伦理准则和潜在危害对其进行评估。该模型具有指令净化功能,可消除有害的指令重解释;其执行过程能够保持价值,从而维护伦理约束;此外,该模型还具有透明的安全决策推理机制。这些保障措施确保模型在执行复杂、开放式指令时,始终保持有效、无害且诚实可靠。

登录

登录