const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-next-80b-a3b-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-next-80b-a3b-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

产品详情

Qwen3-Next-80B-A3B 指令 是一个高度先进的、指令优化的大型语言模型,专为实现卓越的速度、稳定性和超长上下文处理能力以及高吞吐量而设计。它仅激活其 800 亿个参数中的一小部分,即可显著提升速度和成本效益,同时又不影响复杂推理和代码生成等关键领域的性能。

⚙️ 技术规格

Qwen3-Next-80B-A3B 指令通过以下方式优化其操作 推理过程中仅激活了 800 亿个参数中的约 30 亿个。这种稀疏激活机制具有显著优势:

- 速度与成本效益: 与之前的 Qwen3-32B 型号相比,运行速度快约 10 倍,成本效益更高。

- 吞吐量: 处理 32K 个令牌或更多的长上下文时,吞吐量可提高 10 倍以上。

- 灵活部署: 提供多种部署选项,包括无服务器、按需专用和按月预留托管。

- 部署兼容性: 兼容 SGLang 和 vLLM,可实现高效、可扩展的使用,并具有先进的多标记预测功能。

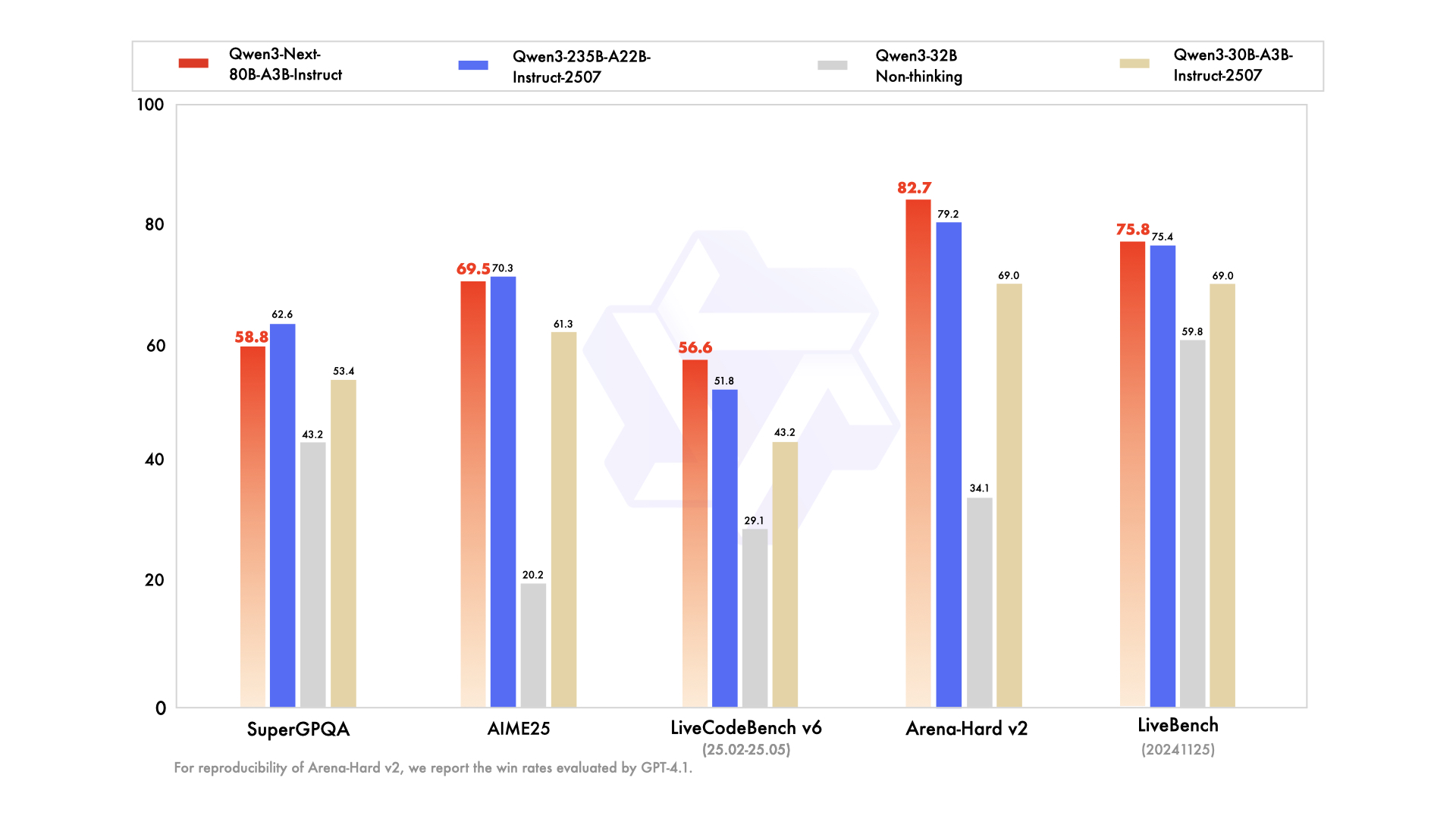

📊 性能基准

- ✅ 顶级性能: 在各种推理、代码补全和指令执行任务中,性能与 Qwen3-235B 旗舰型号的性能相当或非常接近。

- ✅ 始终如一的长上下文处理: 能够持续提供稳定且确定的答案,尤其擅长需要广泛理解上下文的任务。

- ✅ 资源高效: 在效率方面超越了早期的中等规模指令调整模型,以更少的计算资源实现了高性能。

- ✅ 多功能集成: 非常适合工具集成、检索增强生成 (RAG) 以及需要一致的思维链输出的复杂代理工作流程。

💰 API定价

输入: 0.1575美元

输出: 1.6美元

✨ 主要能力

- 🚀 超高效推理: 采用稀疏混合专家(MoE)架构,动态激活 800 亿个参数中的 30 亿个,从而实现更快、更经济高效的推理。

- 🧠 出色的任务表现: 擅长处理各种复杂任务,包括高级推理、强大的代码生成、精确的知识问答以及多功能的多语言应用程序。

- ⚡️稳定快速的响应: 针对教学模式进行了优化,确保快速、一致的响应,无需中间“思考”步骤。

- 📖 超长上下文处理: 原生上下文长度为 262K 个Tokens,使用先进的扩展技术可扩展至惊人的 100 万个Tokens。

- 📈高吞吐量: 与之前的型号相比,处理大量长上下文的吞吐量提高了 10 倍。

- 💬 持续对话与解答: 非常适合多轮对话和需要确定性、一致最终答案的任务。

- 🛠️ 高级代理工作流: 强大的工具调用能力、多步骤任务执行能力以及与工具无缝集成的复杂代理工作流能力。

💡 用例

- 代码生成: 通过智能代码建议和完整的代码块生成来加速软件开发。

- 内容创作与编辑: 根据详细说明,创作各种内容,包括文章和营销文案,并进行复杂的编辑工作。

- 数据分析: 便于进行复杂数据解读、统计分析和综合报告生成。

- 客户服务自动化: 通过精准的指令处理和自动回复,提高客户支持效率。

- 技术文档: 简化技术文档、手册和特定格式输出的创建流程。

- 流程自动化: 执行多步骤任务并集成工具调用,以实现各种工作流程的自动化和简化。

- 长时间对话和文档处理: 高效管理长篇对话,总结大型文档,并从大量文本中提取关键信息。

💻 代码示例

import openai client = openai.OpenAI( base_url="https://api.perplexity.ai", # 示例基本 URL,请替换为实际端点 api_key="YOUR_API_KEY", # 请替换为您的实际 API 密钥 ) messages = [ { "role": "system", "content": "您是 Qwen3-Next-80B-A3B Instruct,一位乐于助人的 AI 助手。" }, { "role": "user", "content": "用简单易懂的语言向高中生解释量子纠缠的概念。" }, ] response = client.chat.completions.create( model="alibaba/qwen3-next-80b-a3b-instruct", messages=messages, max_tokens=500, temperature=0.7, top_p=0.9, frequency_penalty=0, presence_penalty=0, ) print(response.choices[0].message.content) 注意:上述示例中的 `base_url` 和 `api_key` 仅为占位符。具体的集成细节请参考官方 API 文档。

🆚 与其他型号的比较

80B A3B 型号在推理和编码任务方面提供的性能与旗舰级 235B 相当或非常接近,同时通过激活更少的参数实现更快、更经济高效的推理,从而显著提高效率。

Qwen3-Next 提供类似的指令跟踪和长上下文功能,其特点是吞吐量更高、标记窗口更大,因此特别适合处理大量文档理解任务。

Qwen3-Next 在多轮对话和代理工作流程中表现出优异的性能,与 Claude 的对话优势相比,在非常长的上下文中提供了更确定的输出。

Qwen3-Next 在超长上下文处理方面表现出更好的可扩展性,并且具有卓越的多标记预测效率,使其在处理复杂的多步骤推理任务方面具有明显的优势。

❓ 常见问题解答

Q1:是什么让 Qwen3-Next-80B-A3B Instruct 如此高效?

该模型采用稀疏混合专家(MoE)架构,在推理过程中仅激活其800亿个参数中的约30亿个。这种创新方法显著提高了处理速度并降低了运行成本,效率比以往模型提高了10倍。

Q2:它在处理超长上下文时表现如何?

Qwen3-Next-80B-A3B Instruct 原生支持 262K 个词元的上下文长度,借助先进的扩展技术,这一数字可扩展至惊人的 100 万个词元。这一特性使其成为需要深入理解大量文档和冗长对话任务的理想之选。

Q3:与其他领先的语言模型相比,它的性能如何?

Qwen3-Next-80B-A3B Instruct 在高效运行的同时,在复杂的推理和代码生成任务中,其性能可与 Qwen3-235B 等旗舰级模型相媲美,甚至非常接近。此外,与 GPT-4.1、Claude 4.1 Opus 和 Gemini 2.5 Flash 等模型相比,它在吞吐量、长上下文处理和确定性输出方面也具备相当甚至更优的性能。

Q4:Qwen3-Next-80B-A3B Instruct 的主要使用场景是什么?

该模型尤其适用于需要高吞吐量、精确指令执行和广泛上下文处理的应用。主要用例包括高级代码生成、复杂内容创建、详细数据分析、自动化客户服务、技术文档编写和复杂的代理工作流程。

Q5:Qwen3-Next-80B-A3B Instruct 是否与现有部署基础架构兼容?

是的,该模型旨在与现有部署工具(例如 SGLang 和 vLLM)无缝集成,并支持高级多令牌预测功能。它还提供灵活的部署选项,包括无服务器、按需专用和包月托管,以满足各种运维需求。

登录

登录-p-130x130q80-p-130x130q80.png)