const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'deepseek/deepseek-v3.2-speciale',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="deepseek/deepseek-v3.2-speciale",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Détails du produit

DeepSeek V3.2 Spécial est un modèle de langage étendu (LLM) avancé, axé sur le raisonnement et conçu pour exceller dans la résolution de problèmes logiques en plusieurs étapes et le traitement de contextes étendus. Avec une fenêtre de contexte impressionnante pouvant atteindre 128 000 jetonsIl est conçu pour les tâches analytiques complexes. Une fonctionnalité révolutionnaire, mode « réflexion seule »Cette approche permet au modèle d'effectuer un raisonnement interne silencieux avant de générer toute sortie. Elle améliore considérablement la précision, la cohérence factuelle et la déduction par étapes, notamment pour les requêtes complexes.

Ce modèle est conforme aux spécifications de complétion Chat Prefix/FIM de DeepSeek et offre des fonctionnalités robustes d'appel d'outils. Accessible via un point de terminaison Speciale pour des durées limitées, il comble le fossé entre la recherche de pointe et les applications pratiques de raisonnement en IA, garantissant la cohérence analytique dans divers domaines tels que la génération de code, les calculs mathématiques et l'exploration scientifique.

✨ Spécifications techniques ✨

- ✅ Architecture : LLM en raisonnement textuel

- ✅ Longueur du contexte : 128 000 jetons

- ✅ Capacités : Discussion, raisonnement avancé, utilisation d'outils, achèvement du FIM

- ✅ Données d'entraînement : Ensembles de données optimisés pour le raisonnement, alignement des retours humains

🧠 Indicateurs de performance 🧠

- 📈 Raisonnement complexe : Démontre une stabilité améliorée sur les chaînes à plusieurs étapes, y compris les tâches mathématiques et symboliques.

- 💻 Synthèse de code / Débogage : Offre une meilleure interprétabilité des traces, facilitant les processus de développement et de débogage.

💡 Qualité de la sortie et performances de raisonnement 💡

🌟 Améliorations de la qualité

- ✔️ Raisonnement cohérent : Des raisonnements cohérents assurent la cohérence de plus de 100 000 jetons.

- ✔️ Récupération d'erreurs améliorée : Amélioration de la récupération des erreurs lors de longues chaînes grâce à un contrôle d'attention adaptatif.

- ✔️ Précision symbolique supérieure : Surpasse les modèles DeepSeek précédents en matière de logique multivariable et d'inférence de code.

- ✔️ Ton analytique équilibré : Fournit des explications précises tout en réduisant les surapprentissages ou les dérives sémantiques.

⚠️ Limitations

- Ton formel : Cela peut paraître excessivement formel ou rigide dans des tâches informelles.

- Latence accrue : Le mode « réflexion seule » augmente légèrement la latence sur les chaînes très complexes.

- Variation créative limitée : Variation minimale du ton créatif par rapport aux LLM axés sur la narration.

🚀 Nouvelles fonctionnalités et améliorations techniques 🚀

DeepSeek-V3.2-Speciale introduit des cadres de raisonnement novateurs et des couches d'optimisation internes, conçus pour une stabilité, une interprétabilité et une précision à long terme supérieures.

Améliorations clés

- 🧠 Mode « Réflexion uniquement » : Ajoute une étape cognitive silencieuse avant la sortie visible par l'utilisateur, réduisant considérablement les taux de contradiction et d'hallucinations pour des réponses plus fiables.

- 📏 Fenêtre de contexte étendue (128 Ko) : Permet une synthèse complète de documents longs, une mémoire de dialogue soutenue et un raisonnement basé sur les données à partir de sources multiples.

- 🔍 Audit de la chaîne interne : Offre une visibilité améliorée des traces de raisonnement, un atout précieux pour les chercheurs validant les inférences en plusieurs étapes et garantissant la transparence.

- ✏️ FIM (Fill-in-the-Middle) Complétion : Facilite les insertions au niveau du contexte et la modification structurée du code sans nécessiter une nouvelle soumission complète de l'invite, ce qui améliore l'efficacité des développeurs.

Impact pratique

Ces améliorations significatives se traduisent par une plus grande profondeur d'interprétation en mathématiques, en logique scientifique et pour les tâches analytiques complexes. DeepSeek V3.2 Speciale est donc idéal pour les pipelines d'automatisation sophistiqués et les expériences de recherche cognitive avancées.

💰 Tarification de l'API 💰

- Saisir: 0,2977 $ par million de jetons

- Sortir: 0,4538 $ par million de jetons

💻 Exemple de code 💻

# Exemple de code Python pour l'appel à l'API DeepSeek V3.2 Speciale import openai client = openai.OpenAI( base_url="https://api.deepseek.com/v1", api_key="VOTRE_CLÉ_API" ) response = client.chat.completions.create( model="deepseek/deepseek-v3.2-speciale", messages=[ {"role": "user", "content": "Expliquez le concept d'intrication quantique de manière logique et progressive."}, {"role": "assistant", "content": "(Mode « réflexion seule » activé : déconstruction de la requête, identification des concepts clés, planification de la progression logique, rappel des principes physiques pertinents, structuration de l'explication en étapes discrètes.)"} ], # Le mode « réflexion seule » est un mécanisme interne. # L'appel à l'API lui-même reste standard, mais le traitement interne du modèle change. temperature=0.7, max_tokens=500 ) imprimer(response.choices[0].message.content) 🆚 Comparaison avec d'autres modèles 🆚

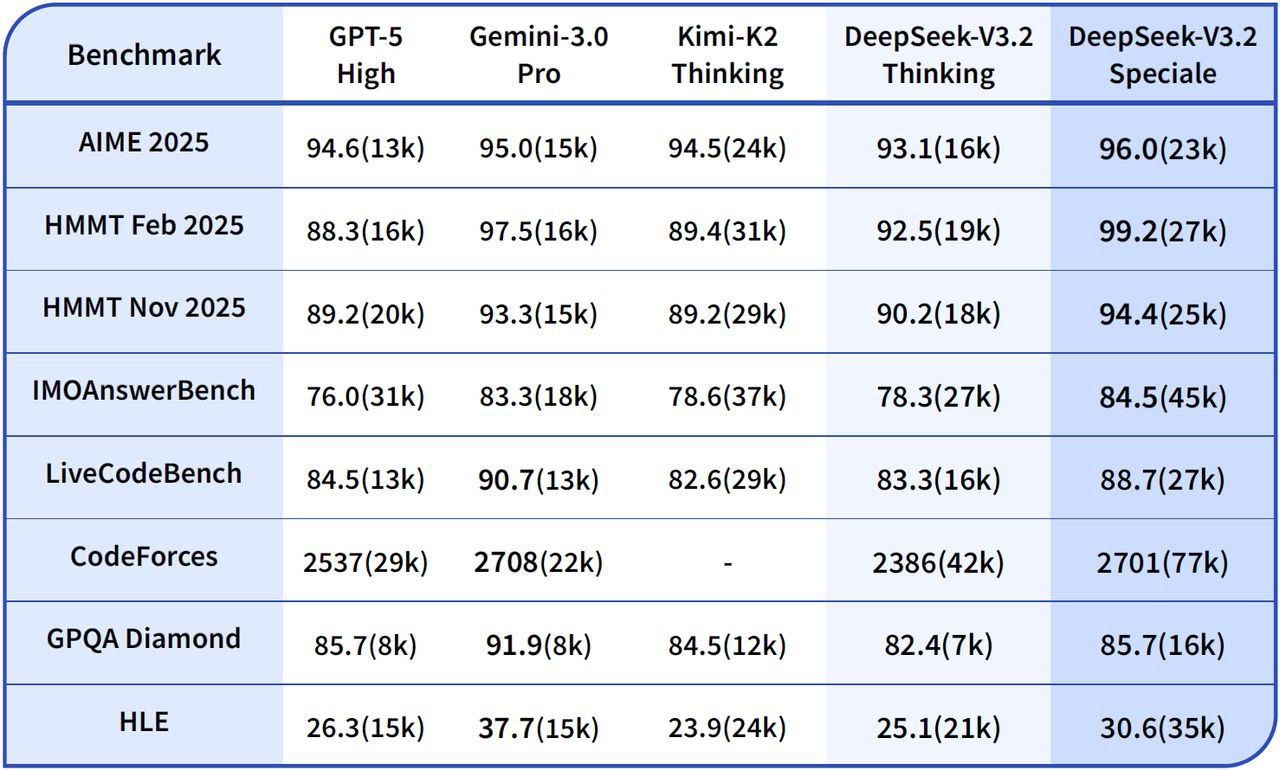

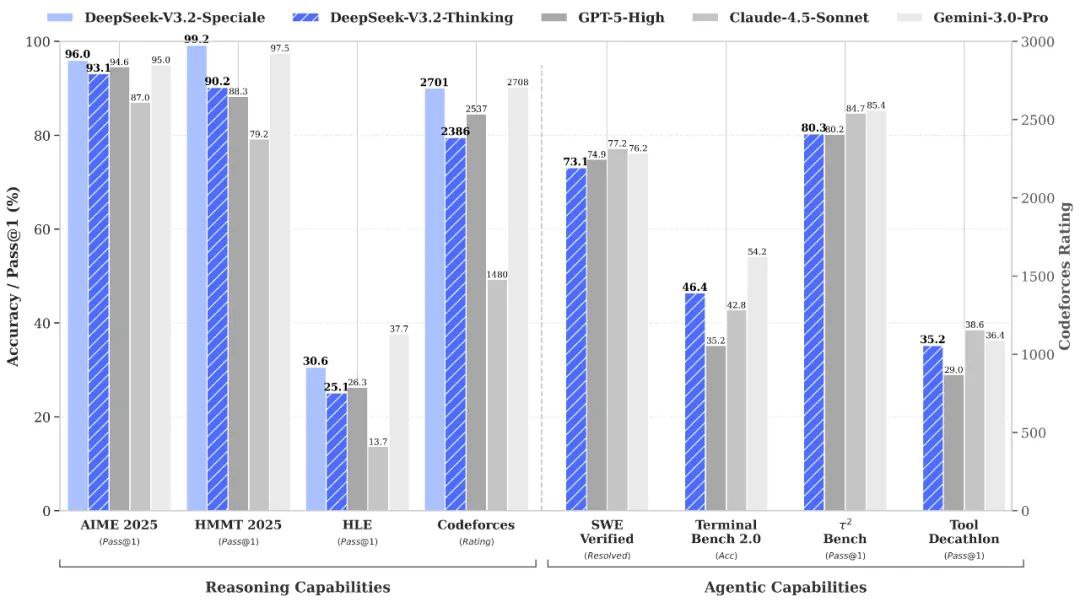

DeepSeek V3.2 Spécial contre. Gemini-3.0-Pro: Les tests comparatifs indiquent que DeepSeek-V3.2-Speciale atteint des performances globales comparables à celles de Gemini-3.0-Pro. Cependant, DeepSeek met davantage l'accent sur un raisonnement transparent et progressif, ce qui le rend particulièrement avantageux pour les applications d'IA agentielle.

DeepSeek V3.2 Spécial contre. GPT-5: Les évaluations publiées placent DeepSeek-V3.2-Speciale en tête par rapport à GPT-5 pour les charges de travail de raisonnement complexes, notamment dans les benchmarks exigeants en mathématiques et de type compétition. Il conserve également une grande compétitivité en termes de fiabilité du code et de l'utilisation des outils, offrant ainsi une alternative intéressante pour les tâches complexes.

DeepSeek V3.2 Spécial contre. DeepSeek-R1: Speciale est conçu pour des scénarios de raisonnement encore plus extrêmes, avec une fenêtre de contexte de 128 Ko et un « mode de réflexion » à haute puissance de calcul. Cela le rend exceptionnellement bien adapté aux frameworks d'agents avancés et aux expériences de référence, le distinguant de DeepSeek-R1 qui est conçu pour une utilisation interactive plus occasionnelle.

💬 Commentaires de la communauté 💬

Les commentaires des utilisateurs sur des plateformes comme Reddit DeepSeek V3.2 Speciale est régulièrement mis en avant comme une solution exceptionnelle pour les tâches de raisonnement complexes. Les développeurs apprécient particulièrement sa domination sur les benchmarks et son impressionnant rapport coût-efficacité, soulignant sa supériorité sur GPT-5 en mathématiques, en programmation et en logique, souvent à un prix plus élevé. 15 fois moins cherNombreux sont ceux qui le qualifient de « remarquable » pour les flux de travail automatisés et la résolution de problèmes complexes. Les utilisateurs apprécient également son impressionnante cohérence dans les longues chaînes de requêtes, la réduction significative des erreurs et sa profondeur d'analyse quasi humaine, notamment par rapport aux versions précédentes de DeepSeek.

❓ Foire aux questions (FAQ) ❓

Q1 : Quel est l'objectif principal de DeepSeek V3.2 Speciale ?

A1 : Il se concentre principalement sur le raisonnement avancé et la résolution de problèmes logiques en plusieurs étapes, conçu pour des tâches analytiques complexes dans les domaines du code, des mathématiques et des sciences.

Q2 : Comment fonctionne le mode « réflexion seule » ?

A2 : Ce mode permet au modèle d’effectuer un raisonnement interne silencieux avant de générer toute sortie visible. Cette étape cognitive interne améliore considérablement la précision, la cohérence factuelle et la logique des réponses, notamment pour les requêtes complexes.

Q3 : Quelle est la longueur de contexte maximale pour DeepSeek V3.2 Speciale ?

A3 : DeepSeek V3.2 Speciale prend en charge une fenêtre de contexte étendue jusqu'à 128 000 jetons, ce qui lui permet de gérer des documents très longs, de maintenir une mémoire de dialogue soutenue et d'effectuer un raisonnement basé sur les données à travers plusieurs sources.

Q4 : Comment son prix se compare-t-il à celui des autres modèles ?

A4 : Les retours de la communauté suggèrent que DeepSeek V3.2 Speciale offre des prix très compétitifs, les développeurs signalant qu'il peut coûter jusqu'à 15 fois moins cher que certains concurrents comme GPT-5 pour des tâches complexes similaires.

Q5 : DeepSeek V3.2 Speciale est-il adapté aux tâches d’écriture créative ?

A5 : Bien que très performant en matière de raisonnement analytique, son « limite » réside notamment dans une variation de ton créative minimale comparée aux LLM axés sur la narration. Il peut paraître trop formel ou rigide pour des tâches informelles ou hautement créatives.

Terrain de jeu de l'IA

Se connecter

Se connecter