const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'zhipu/glm-4.6',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="zhipu/glm-4.6",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Détails du produit

✨ Présentation de l'API GLM-4.6

GLM-4.6 est un modèle de langage avancé de grande taille développé par Zhipu AI (maintenant Z.ai)Il est doté d'un système de pointe de 355 milliards de paramètres Architecture de mélange d'experts (MoE)Optimisé pour un large éventail de tâches, notamment le raisonnement complexe, la programmation, l'écriture et les dialogues à plusieurs tours de parole, GLM-4.6 offre des fonctionnalités étendues. fenêtre de contexte de 200 000 jetonsCe modèle affiche des performances de pointe, notamment en matière de programmation et de tâches automatisées, ce qui en fait un choix privilégié pour les développeurs et les entreprises en quête d'efficacité et de polyvalence.

⚙️ Spécifications techniques

- Architecture du modèle : Paramètre 355B : Mélange d’experts (MoE)

- Modalité d'entrée : Texte

- Modalité de sortie : Texte

- Taille de la fenêtre contextuelle : 200 000 jetons (au lieu de 128 000 dans GLM-4.5)

- Nombre maximal de jetons de sortie : 128 000 jetons

- Efficacité: Environ Consommation de jetons 30 % plus efficace que les versions précédentes

- Langages de programmation pris en charge : Python, JavaScript, Java (pour les tâches de programmation)

📈 Indicateurs de performance

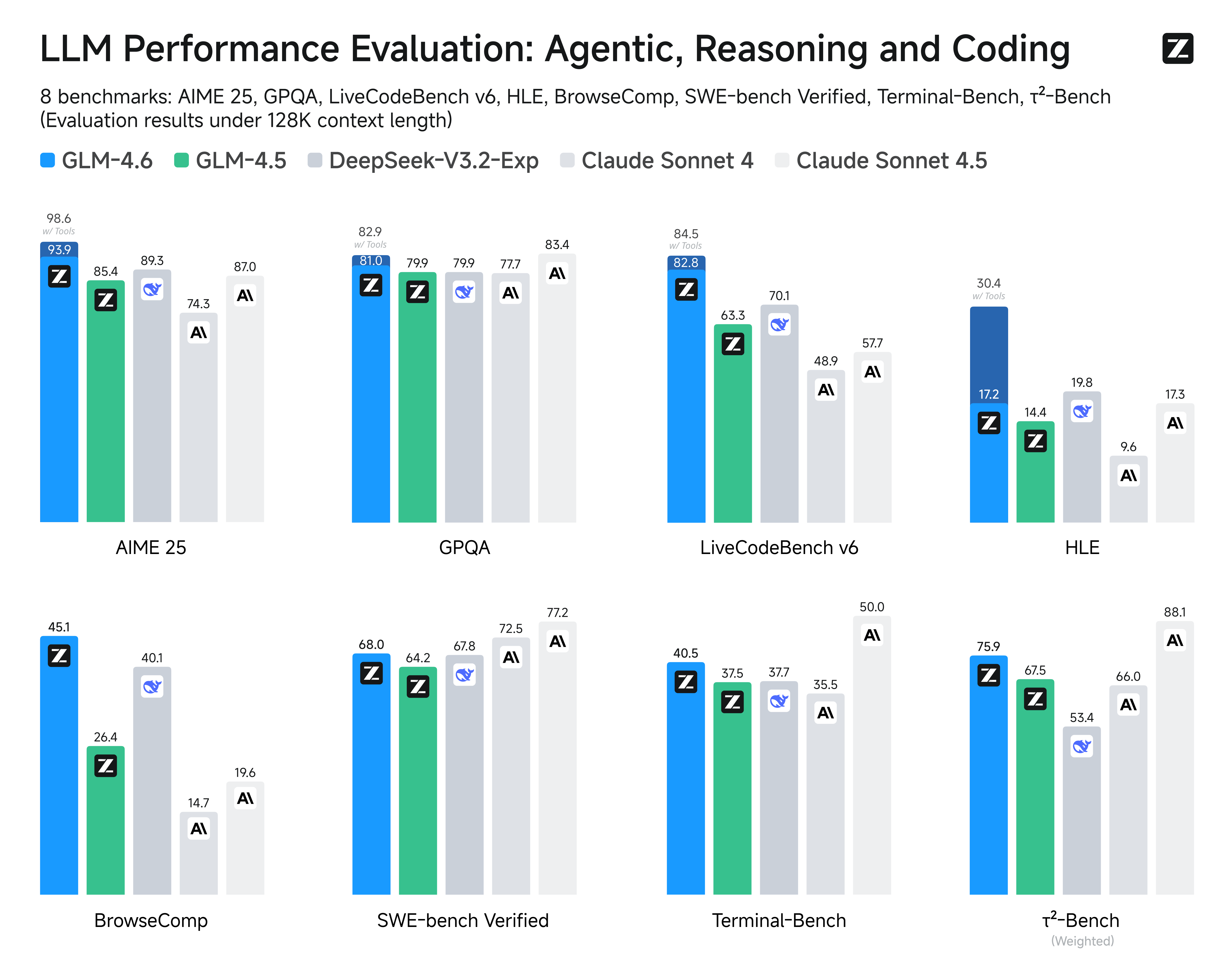

GLM-4.6 a été rigoureusement évalué à l'aide de benchmarks faisant autorité, démontrant des résultats compétitifs ou supérieurs aux principaux modèles :

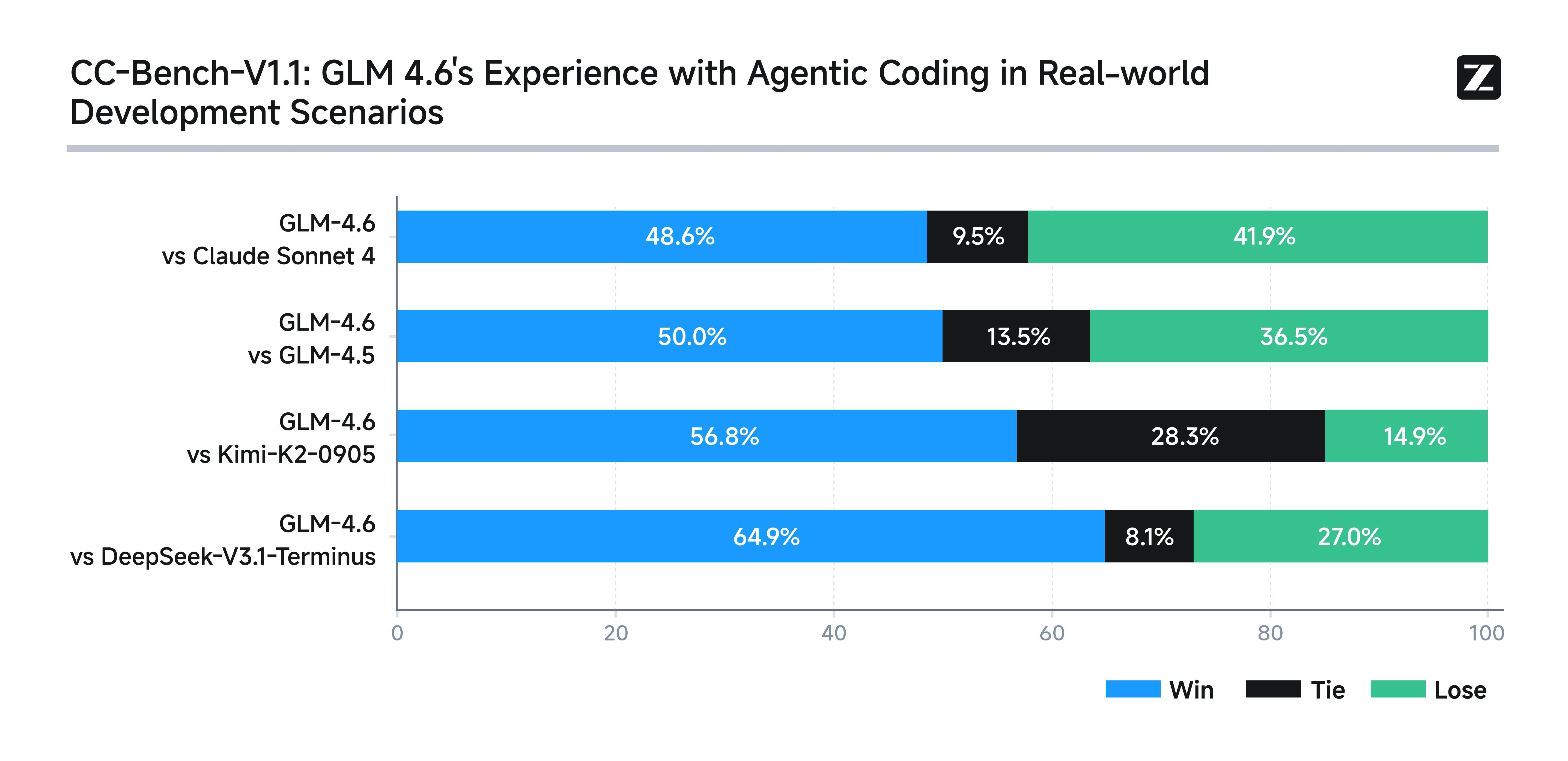

- Tests de codage en situation réelle : Surpasse les modèles nationaux similaires dans 74 scénarios de codage, démontrant une meilleure exactitude et de meilleures performances du code.

- Efficacité comparative : Consomme environ 30 % de jetons en moins pour un rendement équivalent, ce qui réduit les coûts et les besoins en ressources.

- Résultats de référence : Comparable à Claude Sonnet 4 et 4.6 sur des benchmarks NLP multi-domaines comme AIME, GPQA, LCB v6 et SWE-Bench Verified.

- Raisonnement et tâches des agents : Excellentes performances dans la prise de décision et les tâches assistées par ordinateur, égalant ou surpassant souvent les concurrents lors des tests de référence.

- Compréhension contextuelle : Un contexte élargi permet d'obtenir des performances supérieures pour les tâches nécessitant une analyse approfondie des documents et des instructions complexes.

Image : Benchmarks de performance GLM-4.6

💡 Principales caractéristiques et fonctionnalités

- Gestion étendue du contexte : Avec un énorme fenêtre de jetons de 200 000, GLM-4.6 peut effectuer une compréhension détaillée de textes longs, une résolution de problèmes en plusieurs étapes et maintenir des dialogues cohérents et prolongés.

- Performances de codage supérieures : Surpasse GLM-4.5 et de nombreux concurrents nationaux dans 74 tests de programmation pratiques réalisés dans l'environnement Claude Code. Excellente en développement front-end, en organisation du code et en planification autonome.

- Raisonnement et prise de décision avancés : L'amélioration des capacités d'utilisation des outils lors de l'inférence permet de meilleurs cadres d'agents autonomes et une exécution des tâches basée sur la recherche.

- Génération de langage naturel : Génère des textes mieux adaptés aux préférences stylistiques humaines, excellant dans les jeux de rôle, la création de contenu (romans, scénarios, publicités) et les conversations à plusieurs tours.

Image : GLM-4.6 Caractéristiques et fonctionnalités clés

💰 Tarification de l'API GLM-4.6

- Saisir: 0,63 $

- Sortir: 2,31 $

- En cache : 0,1155 $

🚀 Cas d'utilisation de GLM-4.6

- Analyse de documents à contexte long et résumé

- Raisonnement complexe en plusieurs étapes et la résolution de problèmes

- Programmation du monde réel et la génération de code dans plusieurs langues

- Création de contenu en langage naturel y compris l'écriture créative et les scénarios

- Chatbots avec des conversations à plusieurs tours de parole soutenues et cohérentes

- Systèmes d'agents avec l'utilisation d'outils et la prise de décision autonome

- Applications industrielles à grand volume nécessitant des modèles à jetons efficaces

💻 Exemple de code

Cette section comprendrait généralement un extrait de code interactif pour l'intégration d'API, par exemple :

import openai from openai import OpenAI # Pour Zhipu AI (Z.ai) GLM-4.6 client = OpenAI( api_key= "VOTRE_CLÉ_API" , base_url= "https://api.z.ai/v1" , # Exemple d'URL de base ) completion = client.chat.completions.create( model= "zhipu/glm-4.6" , messages=[ { "role" : "system" , "content" : "Vous êtes un assistant utile." }, { "role" : "user" , "content" : "Expliquez les grands modèles de langage en termes simples." } ] ) print (completion.choices[0].message.content)⚖️ Comparaison avec d'autres modèles

Contre. GLM-4.5: GLM-4.6 offre des améliorations notables dans la précision de la génération de code et conserve un avantage constant dans la gestion des entrées de contexte ultra-longues, tout en conservant de solides performances de tâches d'agent proches de GLM-4.5.

Contre. OpenAI GPT-4.5: GLM-4.6 réduit l'écart en matière de raisonnement et de précision des tâches à plusieurs étapes, en tirant parti de sa fenêtre de contexte beaucoup plus large ; cependant, GPT-4.5 reste en tête en termes de précision brute des tâches sur certains benchmarks standardisés.

Contre. Claude 4 Sonnet: Alors que Claude 4 Sonnet excelle en matière de codage et d'efficacité multi-agents, GLM-4.6 l'égale ou le surpasse en matière de raisonnement agentique et de compréhension de documents longs, ce qui le rend plus performant pour les applications à contexte étendu.

Contre. Gemini 2.5 Pro: GLM-4.6 équilibre les capacités avancées de raisonnement et de codage avec une meilleure compréhension des documents longs, tandis que Gemini 2.5 Pro est davantage axé sur l'optimisation des benchmarks individuels de codage et de raisonnement.

🔗 Intégration API

Accessible via une API d'IA/ML. Pour une documentation détaillée, veuillez consulter : Documentation de l'API GLM-4.6.

❓ Foire aux questions (FAQ)

Q1 : Qu’est-ce que GLM-4.6 et quelles améliorations significatives apporte-t-il ?

GLM-4.6 est la dernière version de la série General Language Model de Zhipu AI. Elle intègre des améliorations significatives au niveau du raisonnement, des performances multilingues et des connaissances spécialisées. Parmi les principales améliorations, citons un raisonnement mathématique et logique avancé, une meilleure génération et compréhension du code, une prise en charge multilingue renforcée avec des capacités supérieures pour le chinois, ainsi qu'une efficacité accrue dans le traitement des tâches complexes à plusieurs étapes.

Q2 : Comment GLM-4.6 se compare-t-il à d'autres modèles de langage de premier plan comme GPT-4 et Claude ?

GLM-4.6 affiche des performances compétitives face aux modèles de pointe, notamment en ce qui concerne les tâches de traitement du chinois, le raisonnement mathématique et la programmation. Bien que ses points forts diffèrent de ceux de GPT-4 en écriture créative ou de Claude en matière d'alignement de sécurité, il égale, voire surpasse, les modèles comparables dans les domaines techniques et la compréhension des langues asiatiques. Son architecture efficace offre également des avantages économiques pour de nombreuses applications d'entreprise.

Q3 : Quelles sont les principales innovations techniques de l'architecture de GLM-4.6 ?

GLM-4.6 introduit plusieurs innovations architecturales : des mécanismes d’attention améliorés pour une meilleure gestion des contextes longs, des techniques d’entraînement perfectionnées pour le raisonnement mathématique et logique, une tokenisation optimisée pour une efficacité multilingue accrue, des approches de réglage fin avancées pour des domaines spécialisés et une meilleure efficacité des paramètres permettant d’obtenir des performances élevées sans nécessiter une mise à l’échelle extrême. Ces innovations contribuent à ses performances équilibrées sur diverses tâches.

Q4 : À quelles applications pratiques GLM-4.6 est-il particulièrement adapté ?

GLM-4.6 excelle dans les applications d'entreprise destinées aux marchés asiatiques et nécessitant une prise en charge poussée du chinois, la documentation technique et la génération de code, l'analyse mathématique et scientifique, les outils pédagogiques pour les disciplines STEM, la veille stratégique et l'analyse de données, ainsi que l'automatisation du service client multilingue. Ses performances équilibrées le rendent polyvalent pour les tâches créatives et analytiques dans divers secteurs d'activité.

Q5 : Comment GLM-4.6 prend-il en charge les applications multilingues et interculturelles ?

GLM-4.6 offre des fonctionnalités multilingues sophistiquées, notamment pour le chinois et d'autres langues asiatiques, et comprend la compréhension du contexte culturel, des expressions idiomatiques et des variations régionales. Ce modèle démontre une excellente capacité d'apprentissage par transfert interlingue, garantissant des performances optimales même lorsque les données d'entraînement sont inégalement réparties entre les langues. Il s'avère ainsi particulièrement précieux pour les entreprises internationales opérant sur les marchés asiatiques ou nécessitant une prise en charge multilingue robuste.

Terrain de jeu de l'IA

Se connecter

Se connecter