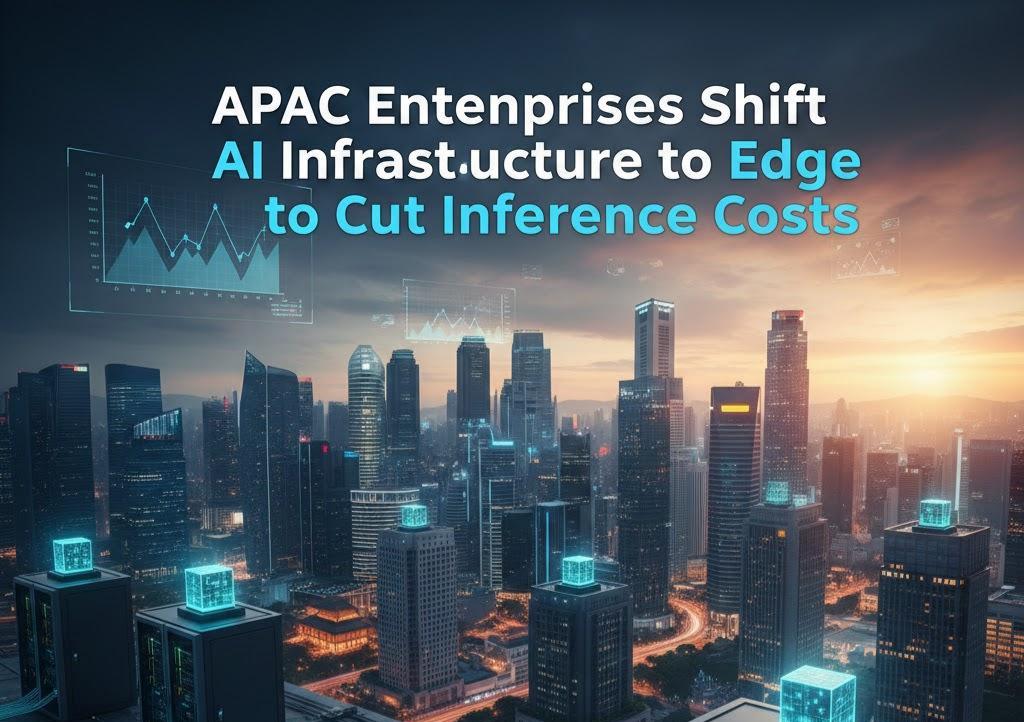

Les entreprises de la région Asie-Pacifique déplacent leur infrastructure d'IA vers la périphérie pour réduire les coûts d'inférence.

Les dépenses en IA dans le Asie-Pacifique (APAC) La région connaît une croissance fulgurante, pourtant de nombreuses entreprises peinent à obtenir un retour sur investissement tangible. Le principal obstacle réside dans l'infrastructure : les systèmes existants ne sont souvent pas conçus pour la vitesse ni l'échelle requises par l'inférence de l'IA moderne. Selon des études sectorielles, les investissements importants dans les outils d'IA générale n'atteignent souvent pas leurs objectifs en raison de ces limitations architecturales.

Cet écart de performance souligne le rôle crucial de Infrastructure d'IA en matière de gestion des coûts et de déploiement à grande échelle. Pour remédier à cela, Intelligent a introduit son Nuage d'inférence, alimenté par GPU NVIDIA Blackwell, dans le but de rapprocher la prise de décision de l'utilisateur afin d'éliminer la latence et de réduire les coûts supplémentaires.

Combler le fossé entre l'expérimentation et la production

Jay JenkinsDans une interview concernant la tendance « Les entreprises de la région Asie-Pacifique délocalisent leur infrastructure d'IA vers la périphérie face à la hausse des coûts d'inférence », le directeur technique du cloud computing chez Akamai a souligné que de nombreuses initiatives échouent car les organisations sous-estiment la transition du projet pilote à la production. Les coûts d'infrastructure élevés et la latence importante freinent souvent les progrès.

Bien que les clouds centralisés soient la norme, ils deviennent excessivement coûteux à mesure que l'utilisation augmente, notamment dans les régions éloignées des principaux centres de données. « L’IA n’est puissante que dans la mesure où l’infrastructure sur laquelle elle repose est performante. » Jenkins souligne que la complexité du multicloud et la conformité des données compliquent encore davantage le paysage.

Le passage de l'entraînement de l'IA à l'inférence en temps réel

À mesure que l'adoption de l'IA mûrit dans la région Asie-Pacifique, l'attention se déplace de l'entraînement ponctuel des modèles vers inférence continueCette demande opérationnelle quotidienne consomme la plus grande partie de la puissance de calcul, notamment avec le déploiement de modèles de langage, de vision et multimodaux sur divers marchés. Les systèmes centralisés, jamais conçus pour une telle réactivité, deviennent le principal goulot d'étranglement.

Infrastructure périphérique optimise cela en :

- Réduction de la distance entre les données : Raccourcir le trajet des données pour garantir des réponses plus rapides du modèle.

- Réduction des coûts : Éviter les frais de sortie élevés associés au routage des données entre des hubs cloud distants.

- Permettre l'action en temps réel : Soutien aux systèmes d'IA physiques tels que la robotique et les machines autonomes qui nécessitent une prise de décision en millisecondes.

Adoption par l'industrie : commerce de détail, finance et au-delà

Les secteurs sensibles aux retards sont à l'avant-garde de cette transition vers la marge :

- Commerce de détail et commerce électronique : L'inférence localisée permet des recommandations personnalisées et une recherche multimodale, évitant ainsi l'abandon par l'utilisateur en raison de la lenteur du processus.

- Finance: La détection des fraudes et l'approbation des paiements reposent sur des chaînes de décision rapides basées sur l'IA. Le traitement local des données permet aux entreprises de maintenir leur réactivité tout en garantissant le respect des réglementations en vigueur.

Construire l'avenir : IA agentielle et sécurité

La prochaine phase de l'IA implique Agent IA— des systèmes qui prennent des décisions de manière autonome. Cela nécessite un « Réseau de distribution d'IA » qui répartit l'inférence sur des milliers de points de présence. Cette approche distribuée améliore non seulement les performances, mais simplifie également… gouvernance des données pour les 50 % d'organisations de la région Asie-Pacifique qui sont actuellement confrontées à des réglementations régionales disparates.

À mesure que l'inférence se déplace vers la périphérie, sécurité Cela reste primordial. La mise en œuvre de contrôles Zero Trust et la protection des pipelines API sur chaque site garantissent que la résilience ne se fasse pas au détriment de la vulnérabilité. Pour les entreprises en 2025 et au-delà, le passage à l'edge computing n'est plus une option : c'est une condition sine qua non pour une IA évolutive et rentable.

Se connecter

Se connecter