const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'deepseek/deepseek-v3.2-speciale',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="deepseek/deepseek-v3.2-speciale",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalle del producto

DeepSeek V3.2 Especial es un modelo de lenguaje extenso (LLM) avanzado y centrado en el razonamiento, diseñado para sobresalir en la resolución de problemas lógicos de varios pasos y el procesamiento de contexto extenso. Con una impresionante ventana de contexto de hasta 128.000 tokensEstá diseñado para tareas analíticas complejas. Una característica innovadora, la modo de "solo pensar"Permite que el modelo realice un razonamiento interno silencioso antes de generar cualquier resultado. Este innovador enfoque mejora significativamente la precisión, la coherencia factual y la deducción gradual, especialmente para consultas complejas.

Este modelo cumple con las especificaciones de finalización de prefijo de chat/FIM de DeepSeek y ofrece sólidas capacidades de llamada a herramientas. Accesible a través de un endpoint Speciale por tiempo limitado, conecta la investigación de vanguardia con las aplicaciones prácticas de razonamiento de IA, garantizando la consistencia analítica en diversos dominios como la generación de código, los cálculos matemáticos y la exploración científica.

✨ Especificaciones técnicas ✨

- ✅ Arquitectura: LLM en razonamiento basado en texto

- ✅ Longitud del contexto: 128.000 tokens

- ✅ Capacidades: Chat, razonamiento avanzado, uso de herramientas, finalización de FIM

- ✅ Datos de entrenamiento: Conjuntos de datos optimizados para el razonamiento, alineación de la retroalimentación humana

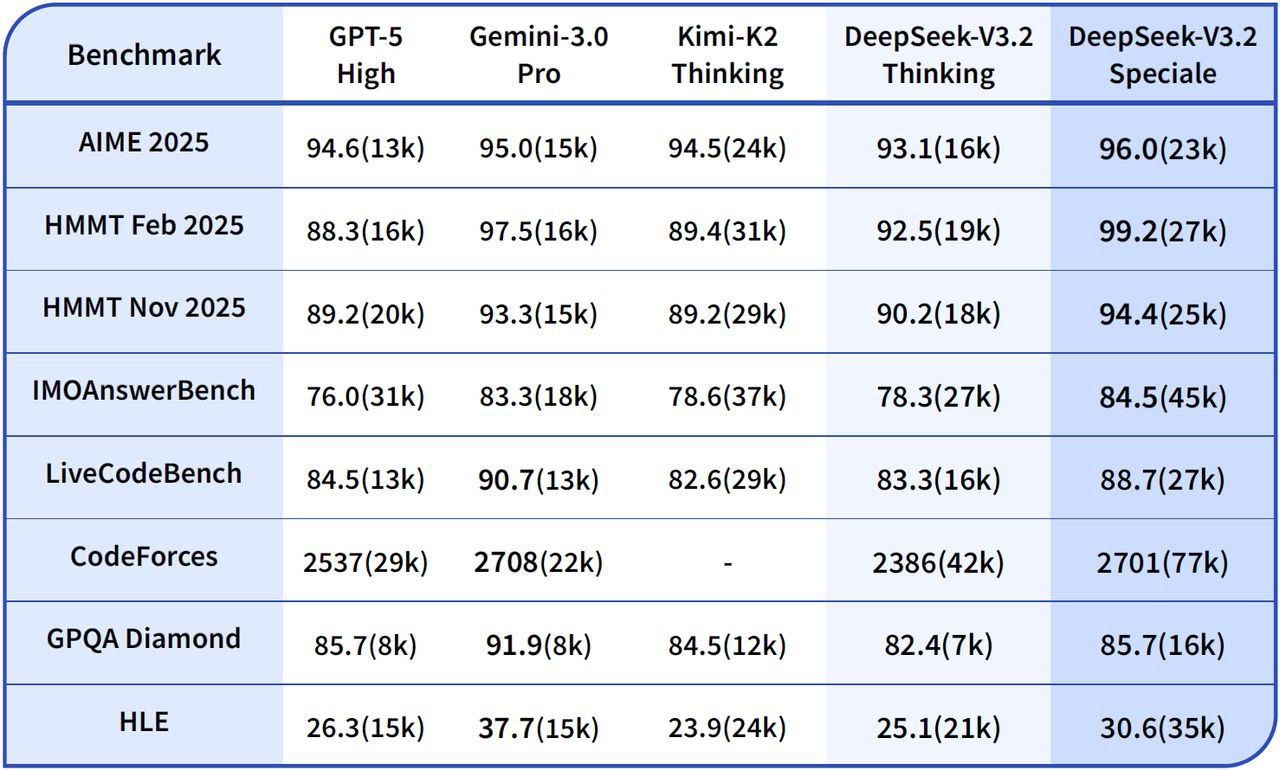

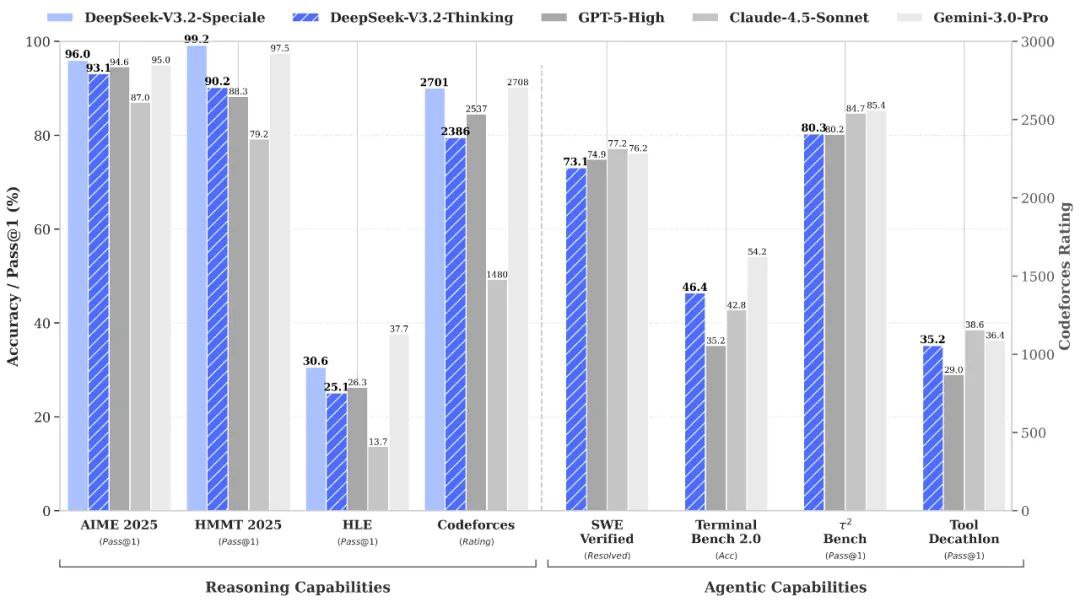

🧠 Puntos de referencia de rendimiento 🧠

- 📈 Razonamiento complejo: Demuestra una estabilidad mejorada en cadenas de varios pasos, incluidas tareas matemáticas y simbólicas.

- 💻 Síntesis de código / Depuración: Proporciona una mejor explicabilidad del seguimiento, lo que ayuda en los procesos de desarrollo y depuración.

💡 Calidad de salida y rendimiento del razonamiento 💡

🌟 Mejoras de calidad

- ✔️ Razonamiento coherente: Los hilos de razonamiento consistentes mantienen la coherencia en más de 100 000 tokens.

- ✔️ Recuperación de errores mejorada: Recuperación de errores mejorada durante cadenas largas mediante el control de atención adaptativo.

- ✔️ Precisión simbólica superior: Supera a los modelos DeepSeek anteriores en lógica multivariable e inferencia de código.

- ✔️ Tono analítico equilibrado: Proporciona una explicación precisa al tiempo que reduce los sobreajustes o la deriva semántica.

⚠️ Limitaciones

- Tono formal: Puede sonar demasiado formal o rígido en tareas informales.

- Mayor latencia: El modo "Solo pensar" aumenta ligeramente la latencia en cadenas altamente complejas.

- Variación creativa limitada: Variación mínima del tono creativo en comparación con los LLM orientados a la narración de historias.

🚀 Nuevas funciones y actualizaciones técnicas 🚀

DeepSeek-V3.2-Speciale presenta marcos de razonamiento pioneros y capas de optimización interna, diseñados para lograr estabilidad superior, interpretabilidad y precisión en contextos largos.

Actualizaciones clave

- 🧠 Modo de solo pensar: Agrega un pase cognitivo silencioso antes de la salida visible para el usuario, lo que reduce drásticamente las tasas de contradicción y alucinaciones para obtener respuestas más confiables.

- 📏 Ventana de contexto extendida (128K): Permite una síntesis integral de documentos largos, una memoria de diálogo sostenida y un razonamiento basado en datos en múltiples fuentes.

- 🔍Auditoría de Cadena Interna: Ofrece una visibilidad mejorada del seguimiento del razonamiento, algo invaluable para los investigadores que validan la inferencia de múltiples pasos y garantizan la transparencia.

- ✏️ Completar FIM (Rellenar el medio): Facilita las inserciones a nivel de contexto y la aplicación de parches de código estructurado sin necesidad de volver a enviar la solicitud completa, lo que aumenta la eficiencia para los desarrolladores.

Impacto práctico

Estas importantes mejoras se traducen en una mayor profundidad interpretativa en matemáticas, lógica científica y tareas analíticas extensas. Por lo tanto, DeepSeek V3.2 Speciale es ideal para procesos de automatización sofisticados y experimentos avanzados de investigación cognitiva.

💰 Precios de la API 💰

- Aporte: $0,2977 por 1 millón de tokens

- Producción: $0,4538 por 1 millón de tokens

Ejemplo de código

# Ejemplo de código Python para la llamada a la API de DeepSeek V3.2 Speciale: import openai client = openai.OpenAI( base_url="https://api.deepseek.com/v1", api_key="YOUR_API_KEY" ) response = client.chat.completions.create( model="deepseek/deepseek-v3.2-speciale", messages=[ {"role": "user", "content": "Explique el concepto de entrelazamiento cuántico de forma lógica, paso a paso."}, {"role": "assistant", "content": "(Modo de solo pensamiento activado: Deconstrucción de la consulta, identificación de conceptos clave, planificación de la progresión lógica, recordatorio de principios físicos relevantes, estructuración de la explicación en pasos discretos.)"} ], # El modo de solo pensamiento es un mecanismo interno. # La llamada a la API sigue siendo estándar, pero el procesamiento interno del modelo cambia. temperature=0.7, max_tokens=500 ) imprimir(respuesta.opciones[0].mensaje.contenido) 🆚 Comparación con otros modelos 🆚

DeepSeek V3.2 Especial vs. Géminis-3.0-Pro: Los puntos de referencia indican que DeepSeek-V3.2-Speciale alcanza una competencia general comparable a la de Gemini-3.0-Pro. Sin embargo, DeepSeek prioriza considerablemente el razonamiento transparente y gradual, lo que lo hace especialmente ventajoso para aplicaciones de IA con agentes.

DeepSeek V3.2 Especial vs. GPT-5: Las evaluaciones reportadas posicionan a DeepSeek-V3.2-Speciale por delante de GPT-5 en cargas de trabajo de razonamiento exigentes, especialmente en pruebas de rendimiento con alto contenido matemático y de tipo competitivo. Además, mantiene una alta competitividad en la codificación y la fiabilidad en el uso de herramientas, ofreciendo una alternativa atractiva para tareas complejas.

DeepSeek V3.2 Especial vs. Búsqueda profunda-R1: Speciale está diseñado para escenarios de razonamiento aún más extremos, con una ventana de contexto de 128K y un modo de pensamiento de alto rendimiento. Esto lo hace excepcionalmente adecuado para marcos de trabajo de agencia avanzados y experimentos de referencia, lo que lo distingue de DeepSeek-R1, diseñado para un uso interactivo más informal.

💬 Comentarios de la comunidad 💬

Comentarios de los usuarios sobre plataformas como Reddit Destacan constantemente DeepSeek V3.2 Speciale como una herramienta destacada para tareas de razonamiento de alto riesgo. Los desarrolladores elogian especialmente su dominio en las pruebas de referencia y su impresionante rentabilidad, destacando su superioridad sobre GPT-5 en pruebas de referencia matemáticas, de código y lógicas, a menudo a un precio muy competitivo. 15 veces menor costoMuchos lo describen como "extraordinario" para flujos de trabajo de agencia y resolución de problemas complejos. Los usuarios también elogian su impresionante coherencia en cadenas largas, la reducción significativa de errores y su profundidad "similar a la humana", especialmente en comparación con versiones anteriores de DeepSeek.

❓ Preguntas frecuentes (FAQ) ❓

P1: ¿Cuál es el enfoque principal de DeepSeek V3.2 Speciale?

A1: Se centra principalmente en el razonamiento avanzado y la resolución de problemas lógicos de múltiples pasos, diseñado para tareas analíticas complejas en los dominios de código, matemáticas y científicos.

P2: ¿Cómo funciona el modo “sólo pensar”?

A2: Este modo permite que el modelo realice un razonamiento interno silencioso antes de generar cualquier resultado visible. Este pase cognitivo interno mejora significativamente la precisión, la coherencia factual y el flujo lógico de las respuestas, especialmente en consultas complejas.

P3: ¿Cuál es la longitud máxima de contexto para DeepSeek V3.2 Speciale?

A3: DeepSeek V3.2 Speciale admite una ventana de contexto extendida de hasta 128 000 tokens, lo que le permite manejar documentos muy largos, mantener una memoria de diálogo sostenida y realizar razonamientos basados en datos en múltiples fuentes.

P4: ¿Cómo se compara su precio con el de otros modelos?

A4: Los comentarios de la comunidad sugieren que DeepSeek V3.2 Speciale ofrece precios altamente competitivos y los desarrolladores informan que puede ser hasta 15 veces más económico que algunos competidores como GPT-5 para tareas complejas similares.

Q5: ¿DeepSeek V3.2 Speciale es adecuado para tareas de escritura creativa?

A5: Si bien ofrece un alto nivel de razonamiento analítico, sus limitaciones incluyen una mínima variación en el tono creativo en comparación con los LLM orientados a la narración. Puede resultar excesivamente formal o rígido para tareas informales o altamente creativas.

Patio de juegos de IA

Acceso

Acceso