const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'zhipu/glm-4.6',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="zhipu/glm-4.6",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalle del producto

✨ Descripción general de la API de GLM-4.6

GLM-4.6 es un modelo de lenguaje grande avanzado desarrollado por Zhipu AI (ahora Z.ai)Cuenta con un parámetro de última generación de 355 mil millones. Arquitectura de mezcla de expertos (MoE)Optimizado para una amplia gama de tareas que incluyen razonamiento complejo, codificación, escritura y diálogo de múltiples turnos, GLM-4.6 ofrece una ventana de contexto de 200.000 tokensEste modelo demuestra un rendimiento líder en la industria, particularmente en programación y tareas de agente, lo que lo convierte en la mejor opción para desarrolladores y empresas que buscan eficiencia y versatilidad.

⚙️ Especificaciones técnicas

- Arquitectura del modelo: Parámetro 355B Mezcla de expertos (MoE)

- Modalidad de entrada: Texto

- Modalidad de salida: Texto

- Tamaño de la ventana de contexto: 200.000 tokens (ampliado desde 128.000 en GLM-4.5)

- Tokens de salida máxima: 128.000 tokens

- Eficiencia: Aproximadamente Consumo de tokens 30% más eficiente que las versiones anteriores

- Lenguajes de programación compatibles: Python, JavaScript, Java (para tareas de codificación)

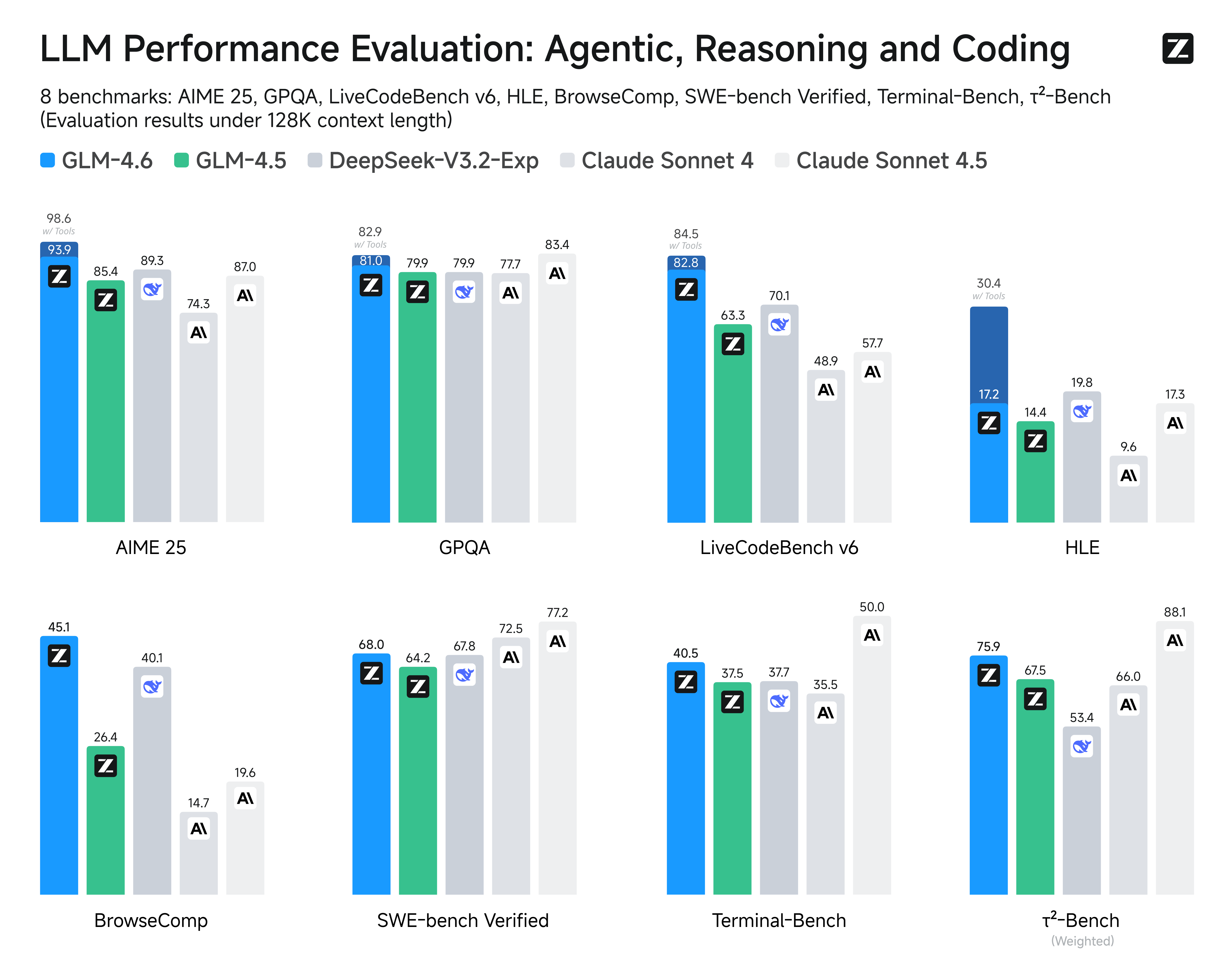

📈 Puntos de referencia de rendimiento

GLM-4.6 ha sido evaluado rigurosamente en puntos de referencia autorizados, demostrando resultados competitivos o superiores frente a los modelos líderes:

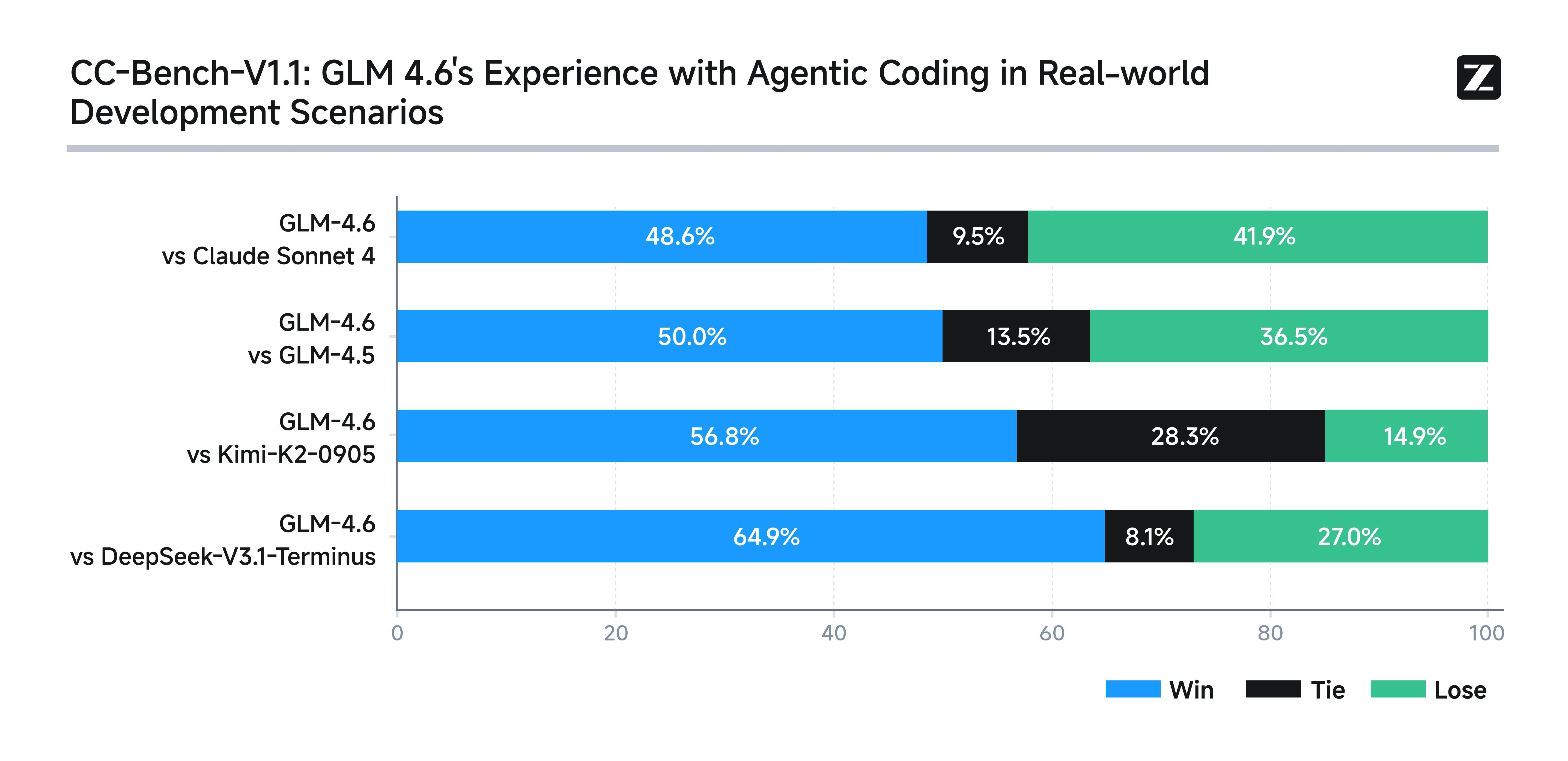

- Pruebas de codificación en el mundo real: Supera a modelos domésticos similares en 74 escenarios de codificación, mostrando mejor corrección y rendimiento del código.

- Eficiencia comparativa: Consume aproximadamente un 30% menos de tokens para una producción equivalente, lo que reduce los costos y las necesidades de recursos.

- Resultados de referencia: Comparable con Claude Sonnet 4 y 4.6 en puntos de referencia de PNL de múltiples dominios como AIME, GPQA, LCB v6 y SWE-Bench Verified.

- Tareas de razonamiento y agente: Buen desempeño en la toma de decisiones y en tareas asistidas por herramientas, a menudo igualando o superando a los competidores en pruebas comparativas.

- Comprensión contextual: El contexto ampliado permite un rendimiento superior en tareas que requieren un análisis profundo de documentos e instrucciones complejas.

Imagen: Puntos de referencia de rendimiento del GLM-4.6

💡 Características y capacidades clave

- Manejo de contexto extendido: Con una masiva Ventana de tokens de 200KGLM-4.6 puede realizar comprensión de textos largos y detallados, resolución de problemas de varios pasos y mantener diálogos coherentes y prolongados.

- Rendimiento de codificación superior: Supera a GLM-4.5 y a muchos competidores nacionales en 74 pruebas prácticas de programación en el entorno Claude Code. Destaca en desarrollo front-end, organización de código y planificación autónoma.

- Razonamiento avanzado y toma de decisiones: Las capacidades mejoradas de uso de herramientas durante la inferencia permiten mejores marcos de agentes autónomos y ejecución de tareas basadas en búsqueda.

- Generación de lenguaje natural: Produce texto con una alineación mejorada con las preferencias estilísticas humanas, destacándose en juegos de rol, creación de contenido (novelas, guiones, anuncios) y conversaciones de múltiples turnos.

Imagen: Características y capacidades clave de GLM-4.6

💰 Precios de la API GLM-4.6

- Aporte: $0.63

- Producción: $2.31

- En caché: $0.1155

🚀 Casos de uso para GLM-4.6

- Análisis de documentos de contexto largo y resumen

- Razonamiento complejo de varios pasos y resolución de problemas

- Programación del mundo real y generación de código en múltiples lenguajes

- Creación de contenido en lenguaje natural Incluyendo escritura creativa y guiones

- Chatbots con conversaciones sostenidas y coherentes de múltiples turnos

- Sistemas agentes con uso de herramientas y toma de decisiones autónoma

- Aplicaciones a escala industrial de gran volumen Requiere modelos eficientes en tokens

💻 Ejemplo de código

Esta sección normalmente presenta un fragmento de código interactivo para la integración de API, por ejemplo:

import openai from openai import OpenAI # Para Zhipu AI (Z.ai) GLM-4.6 client = OpenAI( api_key= "YOUR_API_KEY" , base_url= "https://api.z.ai/v1" , # URL base de ejemplo ) completion = client.chat.completions.create( model= "zhipu/glm-4.6" , messages=[ { "role" : "system" , "content" : "Eres un asistente útil." }, { "role" : "user" , "content" : "Explica modelos de lenguaje grandes en términos simples." } ] ) print (completion.choices[0].message.content)⚖️ Comparación con otros modelos

Contra. GLM-4.5: GLM-4.6 ofrece mejoras notables en la precisión de la generación de código y mantiene una ventaja constante en el manejo de entradas de contexto ultra largas, al tiempo que conserva un sólido desempeño de tareas agenticas cercano a GLM-4.5.

Contra. OpenAI GPT-4.5: GLM-4.6 reduce la brecha en el razonamiento y la precisión de tareas de múltiples pasos, aprovechando su ventana de contexto mucho más grande; sin embargo, GPT-4.5 todavía lidera en precisión de tareas brutas en algunos puntos de referencia estandarizados.

Contra. Soneto Claude 4: Si bien Claude 4 Sonnet se destaca en codificación y eficiencia de múltiples agentes, GLM-4.6 lo iguala o lo supera en razonamiento agente y comprensión de documentos largos, lo que lo hace más sólido para aplicaciones de contexto extendido.

Contra. Géminis 2.5 Pro: GLM-4.6 equilibra capacidades avanzadas de razonamiento y codificación con una mejor comprensión de documentos de formato largo, mientras que Gemini 2.5 Pro está más enfocado en optimizar los puntos de referencia de razonamiento y codificación individuales.

🔗 Integración de API

Accesible mediante la API de IA/ML. Para obtener documentación detallada, consulte: Documentación de la API GLM-4.6.

❓ Preguntas frecuentes (FAQ)

Pregunta 1: ¿Qué es GLM-4.6 y qué mejoras significativas ofrece?

GLM-4.6 es la última versión de la serie de Modelos Generales de Lenguaje de Zhipu AI, que incluye mejoras sustanciales en las capacidades de razonamiento, rendimiento multilingüe y conocimiento especializado. Las mejoras clave incluyen razonamiento matemático y lógico avanzado, mejor generación y comprensión de código, compatibilidad multilingüe mejorada con capacidades superiores en chino y mayor eficiencia en el procesamiento de tareas complejas de varios pasos.

Pregunta 2: ¿Cómo se compara GLM-4.6 con otros modelos de lenguaje líderes como GPT-4 y Claude?

GLM-4.6 demuestra un rendimiento competitivo con modelos de primer nivel, destacando especialmente en tareas de chino, razonamiento matemático y aplicaciones de codificación. Si bien puede tener diferentes fortalezas que GPT-4 en escritura creativa o Claude en alineación de seguridad, a menudo iguala o supera a modelos comparables en dominios técnicos y comprensión de idiomas asiáticos. Su eficiente arquitectura también ofrece ventajas de costo para muchas aplicaciones empresariales.

Pregunta 3: ¿Cuáles son las innovaciones técnicas clave en la arquitectura de GLM-4.6?

GLM-4.6 introduce varias innovaciones arquitectónicas: mecanismos de atención mejorados para un mejor manejo de contextos extensos, técnicas de entrenamiento optimizadas para razonamiento matemático y lógico, tokenización optimizada para eficiencia multilingüe, enfoques avanzados de ajuste fino para dominios especializados y una mayor eficiencia de parámetros que ofrece un rendimiento sólido sin requerir una escalabilidad extrema. Estas innovaciones contribuyen a su rendimiento equilibrado en diversas tareas.

Pregunta 4: ¿Para qué aplicaciones prácticas resulta especialmente adecuado el GLM-4.6?

GLM-4.6 destaca en: aplicaciones empresariales en mercados asiáticos que requieren un sólido soporte en chino, documentación técnica y generación de código, análisis matemático y científico, herramientas educativas para disciplinas STEM, inteligencia empresarial y análisis de datos, y automatización multilingüe de la atención al cliente. Su rendimiento equilibrado lo hace versátil para tareas creativas y analíticas en diversos sectores.

Pregunta 5: ¿Cómo aborda GLM-4.6 las aplicaciones multilingües y transculturales?

GLM-4.6 cuenta con sofisticadas capacidades multilingües, especialmente en chino y otros idiomas asiáticos, incluyendo la comprensión del contexto cultural, los modismos y las variaciones regionales. El modelo demuestra una sólida transferencia de aprendizaje interlingüístico, lo que permite un rendimiento eficaz incluso cuando los datos de entrenamiento se distribuyen de forma desigual entre los idiomas. Esto lo hace especialmente valioso para empresas globales que operan en mercados asiáticos o que requieren un sólido soporte multilingüe.

Patio de juegos de IA

Acceso

Acceso