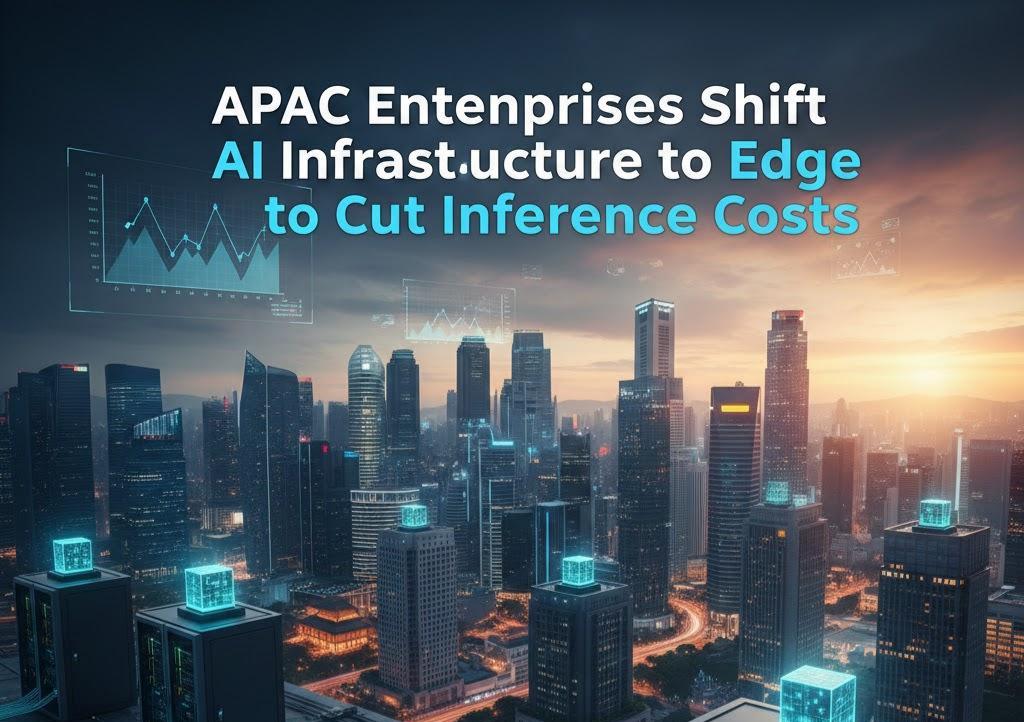

Las empresas de Asia-Pacífico trasladan su infraestructura de IA al edge para reducir los costes de inferencia

El gasto en IA en el Asia Pacífico (APAC) La región está en pleno auge, pero muchas empresas tienen dificultades para obtener un retorno tangible de la inversión (ROI). El principal obstáculo es la infraestructura: los sistemas existentes a menudo no están diseñados para la velocidad ni la escala requeridas para la inferencia de IA moderna. Según estudios del sector, las altas inversiones en herramientas GenAI a menudo no alcanzan los objetivos debido a estas limitaciones arquitectónicas.

Esta brecha de desempeño resalta el papel crítico de Infraestructura de IA en la gestión de costos y el escalamiento de las implementaciones. Para abordar esto, Elegante ha presentado su Nube de inferencia, impulsado por GPU NVIDIA Blackwell, con el objetivo de acercar la toma de decisiones al usuario para eliminar la latencia y reducir la sobrecarga.

Cerrando la brecha entre la experimentación y la producción

Jay Jenkins, director de tecnología de computación en la nube de Akamai, señaló en una entrevista sobre la tendencia «Las empresas de Asia-Pacífico trasladan su infraestructura de IA al edge ante el aumento de los costes de inferencia» que muchas iniciativas fracasan porque las organizaciones subestiman la transición del piloto a la producción. Los elevados costes de infraestructura y la alta latencia suelen frenar el progreso.

Si bien las nubes centralizadas son estándar, se vuelven prohibitivamente costosas a medida que crece su uso, particularmente en regiones alejadas de los principales centros de datos. "La IA es tan poderosa como la infraestructura en la que se ejecuta". Jenkins enfatiza y señala que la complejidad de múltiples nubes y el cumplimiento de los datos complican aún más el panorama.

La transición del entrenamiento de IA a la inferencia en tiempo real

A medida que la adopción de IA madura en APAC, el enfoque está cambiando del entrenamiento ocasional de modelos a inferencia continuaEsta demanda operativa diaria consume la mayor parte de la potencia de procesamiento, especialmente a medida que se implementan modelos de lenguaje, visión y multimodales en diversos mercados. Los sistemas centralizados, que nunca fueron diseñados para tal capacidad de respuesta, se están convirtiendo en el principal cuello de botella.

Infraestructura de borde optimiza esto mediante:

- Reducir la distancia de los datos: Acortar la ruta de viaje de los datos para garantizar respuestas más rápidas del modelo.

- Reducción de costos: Evitar altas tarifas de salida asociadas con el enrutamiento de datos entre centros de nube distantes.

- Habilitación de la acción en tiempo real: Apoyar sistemas de IA físicos como robótica y máquinas autónomas que requieren una toma de decisiones en milisegundos.

Adopción en la industria: comercio minorista, finanzas y más

Las industrias sensibles a los retrasos están liderando la transición hacia el borde:

- Comercio minorista y comercio electrónico: La inferencia localizada potencia las recomendaciones personalizadas y la búsqueda multimodal, evitando el abandono del usuario debido a velocidades lentas.

- Finanzas: La detección de fraudes y la aprobación de pagos se basan en cadenas de decisión rápidas de IA. El procesamiento local de datos ayuda a las empresas a mantener la velocidad y a la vez mantener los datos dentro de los límites regulatorios.

Construyendo el futuro: IA y seguridad agente

La siguiente fase de la IA implica Agente de IA—sistemas que toman secuencias autónomas de decisiones. Esto requiere un Red de distribución de IA que distribuye la inferencia entre miles de ubicaciones de borde. Este enfoque distribuido no solo mejora el rendimiento, sino que también simplifica gobernanza de datos para el 50% de las organizaciones de APAC que actualmente luchan con diversas regulaciones regionales.

A medida que la inferencia se mueve hacia el límite, seguridad Sigue siendo fundamental. Implementar controles de Confianza Cero y proteger las API en cada sitio garantiza que la resiliencia no se produzca a costa de la vulnerabilidad. Para las empresas a partir de 2025, la migración al edge ya no es opcional: es un requisito previo para una IA escalable y rentable.

Acceso

Acceso