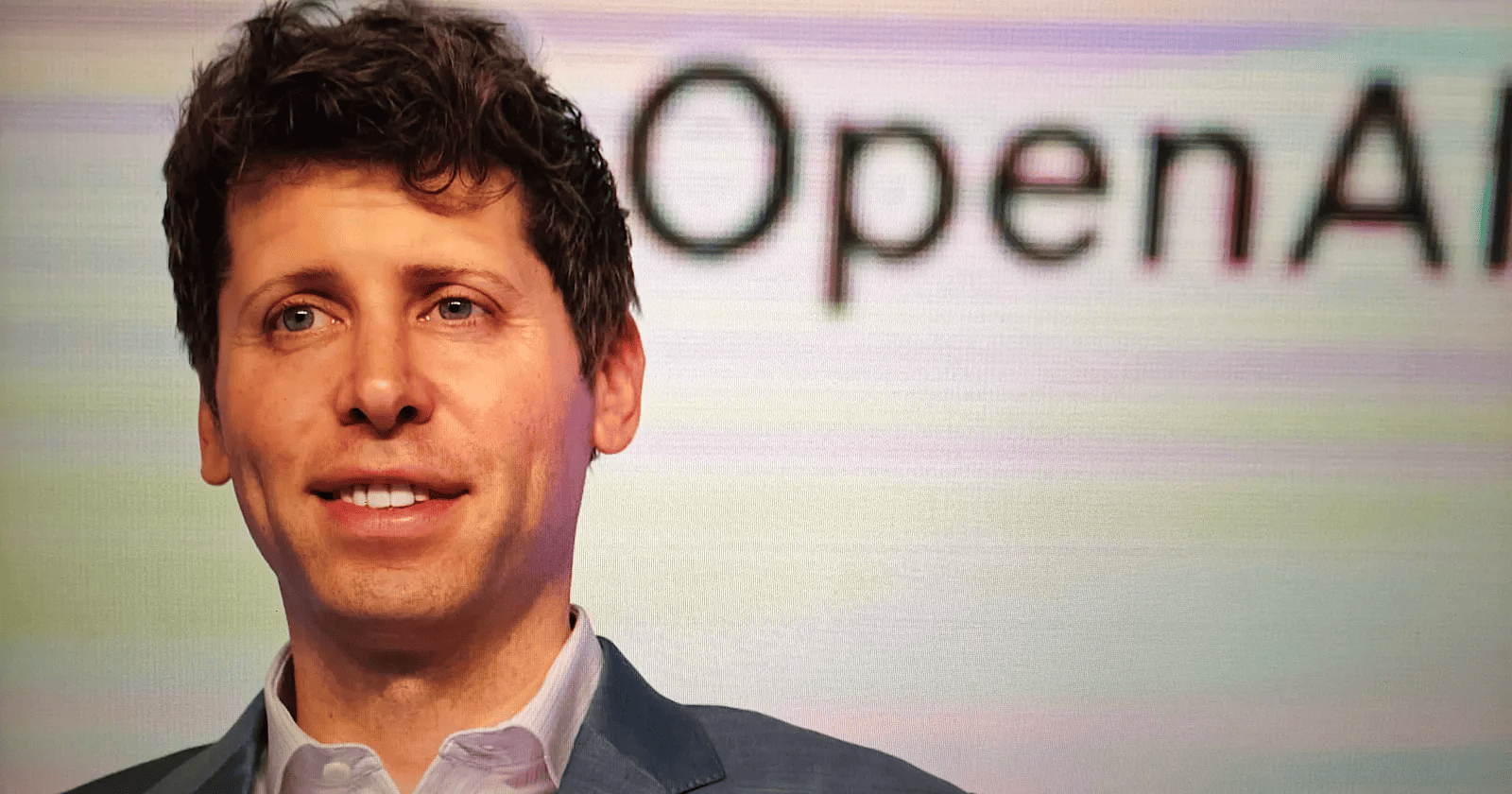

En una sincera admisión durante un reciente ayuntamiento para desarrolladores, el director ejecutivo de OpenAI, Sam Altman, afirmó que la empresa "arruinó" la calidad de escritura de su último modelo, GPT-5.2Este reconocimiento llega en medio de crecientes comentarios de usuarios que afirman que el resultado del modelo resulta "difícil de manejar" y "de leer" en comparación con su predecesor, GPT-4.5.

Altman fue directo en su respuesta, explicando que la disminución en la competencia escrita se debía a una compensación estratégica. OpenAI priorizó la mejora de las capacidades del modelo en inteligencia, razonamiento, codificación e ingeniería.

Un cambio de enfoque: de la interacción natural a la destreza técnica

El contraste entre las versiones de GPT-4.5 y GPT-5.2 destaca las prioridades cambiantes de OpenAI. Cuando se presentó GPT-4.5 en febrero de 2025, se priorizó la interacción natural y la utilidad de la escritura. Se comercializó como una herramienta que "se siente más natural" e ideal para mejorar el contenido escrito.

Sin embargo, el anuncio de GPT-5.2 tomó un rumbo diferente. Se posicionó como la serie de modelos más capaz para el trabajo profesional, destacando su capacidad para gestionar tareas complejas como la creación de hojas de cálculo, la creación de presentaciones y la escritura de código. Si bien la escritura técnica se mencionó como una mejora, la experiencia de escritura más amplia quedó claramente relegada a un segundo plano frente a estas capacidades funcionales.

Las implicaciones más amplias para la industria de la IA

Este incidente arroja luz sobre un desafío crítico que enfrenta la industria de la IA: la dificultad de mantener un alto rendimiento en todos los dominios simultáneamente. A medida que los modelos se vuelven más complejos, la optimización de la lógica y el razonamiento puede degradar inadvertidamente la fluidez lingüística. Este "olvido catastrófico" o compensación es un fenómeno conocido en el aprendizaje automático, pero escuchar a un CEO como Altman abordarlo tan abiertamente es poco común.

Para las empresas y profesionales que confían en ChatGPT para redactar correos electrónicos, crear contenido o pulir texto, esto es un recordatorio crucial. Las actualizaciones de modelos no siempre suponen mejoras lineales. Al igual que las dependencias de software, una nueva versión de un modelo puede introducir regresiones en áreas específicas mientras avanza en otras. Esto subraya la necesidad de realizar pruebas y validaciones continuas de los flujos de trabajo de IA.

Mirando hacia el futuro: el futuro de los modelos de propósito general

A pesar del revés actual, Altman se mantiene optimista sobre la trayectoria futura de los modelos de OpenAI. Expresó su convicción de que «el futuro se centrará principalmente en modelos de propósito general muy buenos» y que incluso los modelos centrados en la codificación deberían, con el tiempo, «escribir bien también».

Si bien no se especificó un cronograma para las actualizaciones de GPT-5.x que solucionarán estos problemas de escritura, el historial de versiones iterativas de OpenAI sugiere que las mejoras podrían implementarse gradualmente. Los usuarios pueden esperar ajustes continuos a medida que la empresa equilibra las exigencias del razonamiento técnico y la generación de lenguaje natural.

A medida que el panorama de la IA continúa evolucionando, el equilibrio entre la potencia computacional bruta y la comunicación similar a la humana sigue siendo una frontera clave. La transparencia de OpenAI en este asunto sienta un precedente sobre cómo los gigantes tecnológicos podrían gestionar las expectativas de los usuarios ante los complejos desafíos del desarrollo.

Acceso

Acceso