const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-max-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-max-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalle del producto

Descubrir Instrucción Qwen3-MaxEl innovador modelo de lenguaje grande (LLM) de Alibaba, presentado oficialmente a principios de 2025. Este modelo insignia de IA cuenta con más de 1 billón de parámetros, lo que marca un avance significativo en la inteligencia artificial a gran escala. Entrenado con conjuntos de datos masivos y una arquitectura avanzada, Qwen3-Max Instruct demuestra capacidades excepcionales, especialmente en Tareas técnicas, de código y matemáticasEsta variante adaptada a las instrucciones está específicamente optimizada para seguimiento rápido y directo de instrucciones, eliminando la necesidad de razonamiento paso a paso y ofreciendo respuestas rápidas y precisas.

✨ Especificaciones técnicas: Potencia inigualable

- 🚀 Escala de parámetros: Más de 1 billón de parámetros (escala de nivel billonario)

- 💾 Datos de entrenamiento: 36 billones de tokens de datos de preentrenamiento

- 🧠 Arquitectura del modelo: Transformador de mezcla de expertos (MoE) con balanceo de carga de lote global para mayor eficiencia

- 📚 Longitud del contexto: Hasta 262.144 tokens (admite más de 258.000 tokens de entrada y 65.000 de salida)

- ⚡ Eficiencia del entrenamiento: Mejora del 30 % de MFU con respecto a los modelos Qwen 2.5 Max de la generación anterior

- 🗣️ Idiomas compatibles: Más de 100 idiomas, con mejoras específicas para contextos mixtos chino-inglés

- 💡 Modo de inferencia: Modo sin pensamiento, priorizando respuestas de instrucciones rápidas y directas (versión de pensamiento en desarrollo)

- 🔄 Almacenamiento en caché de contexto: Permite la reutilización de claves de contexto para mejorar significativamente el rendimiento de las conversaciones de múltiples turnos

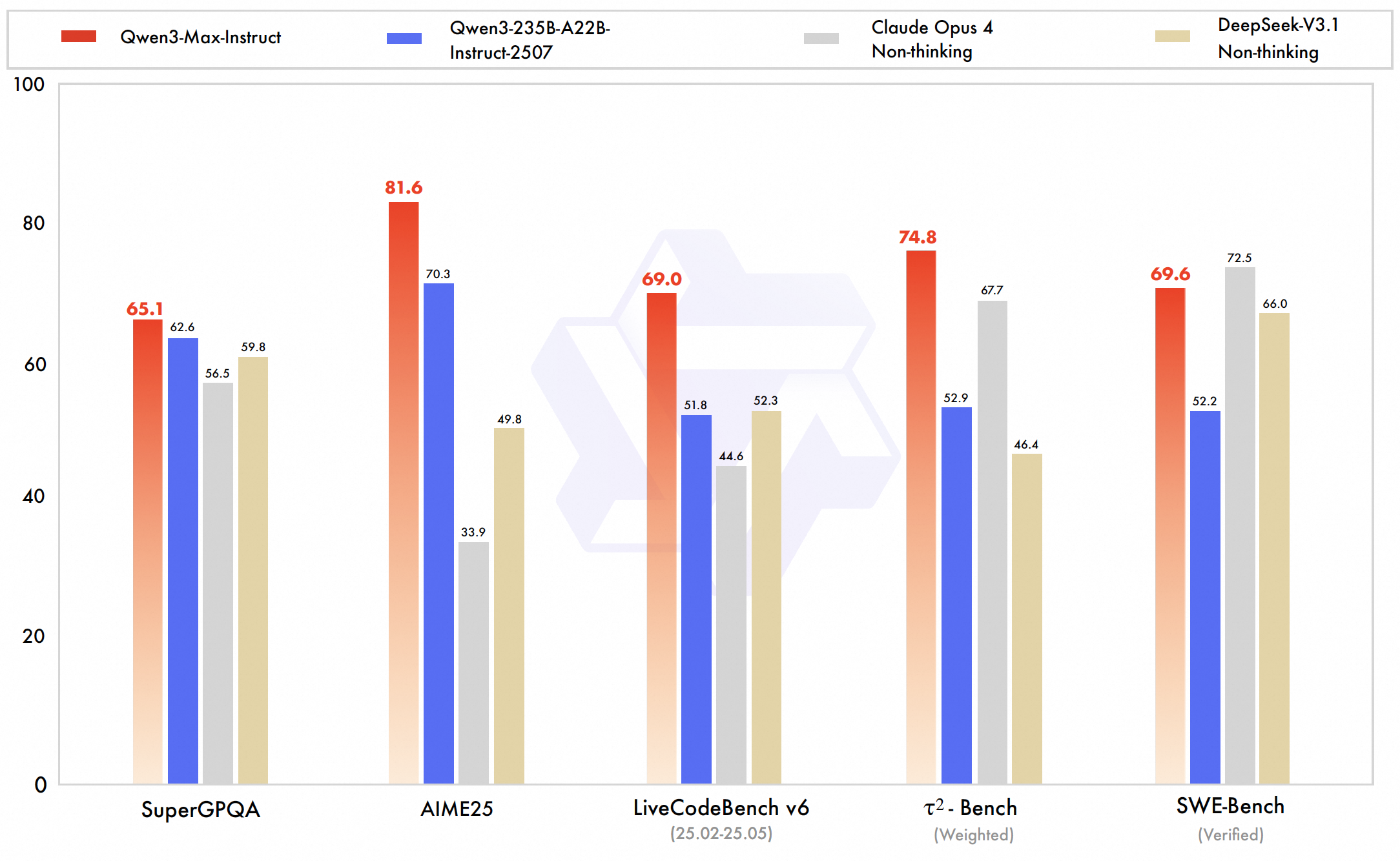

📊 Puntos de referencia y aspectos destacados del rendimiento: estableciendo nuevos estándares

Qwen3-Max logra un rendimiento de clase mundial, destacándose particularmente en código, razonamiento matemático y dominios técnicosLos resultados de las pruebas internas y la clasificación de Alibaba confirman su superioridad o equivalencia con respecto a los modelos de IA de primer nivel, como GPT-5-Chat, Claude Opus 4 y DeepSeek V3.1, en múltiples puntos de referencia.

- 💻 SWE-Bench verificado: 69.6 (demuestra una sólida capacidad para resolver desafíos de programación del mundo real)

- 🔬 Banco Tau2: 74.8 (supera a Claude Opus 4 y DeepSeek V3.1)

- ❓ SuperGPQA: 81.4 (rendimiento en la respuesta a preguntas clave)

- ✍️ LiveCodeBench: Excelentes resultados del desafío de código real

- 🧮 AIME25 (Razonamiento matemático): 80.6 (superando a muchos competidores)

- 🏆 Arena-Difícil v2: 86.1 (fuerte desempeño en tareas difíciles)

- 🏅 Clasificación LM Arena: #6 en general, superando a muchos modelos de última generación, excepto los mejores modelos conversacionales como GPT-4o

Precios de API: IA a gran escala y rentable

- Precio de entrada: $1.26 por millón de tokens

- Precio de salida: $6.30 por millón de tokens

💡 Casos de uso clave: Impulsando la innovación empresarial

- 🏢 Aplicaciones empresariales: Ideal para dominios técnicos que requieren un gran procesamiento de contexto, como Generación de código, modelado matemático y asistencia en investigación..

- 🌍 Soporte multilingüe: Aplicaciones robustas bilingües e internacionales con Fuerte manejo de idiomas mixtos chino-inglés.

- 📜 Enormes ventanas de contexto: Permite la comprensión de documentos extremadamente largos y un diálogo de múltiples turnos con persistencia.

- 🛠️ Herramienta lista para usar: Optimizado para generación aumentada de recuperación e integración con herramientas externas.

- 🚀 Respuestas rápidas: Prioriza la ejecución rápida de instrucciones sin sobrecarga en la cadena de pensamiento.

- 🔗 Integración de ecosistemas: Parte de la familia Qwen3 de Alibaba, incluidas las variantes de visión y razonamiento (Qwen-VL-Max y Qwen3-Max-Thinking).

Ejemplo de código: Primeros pasos

importar openai

cliente = openai.OpenAI (

base_url= "https://api.ai.cc/v1" ,

api_key= "SU_CLAVE_API" ,

)

chat_completion = cliente.chat.completements.create (

modelo= "alibaba/qwen3-max-instruct" ,

mensajes=[

{

"rol" : "sistema" ,

"contenido" : "Eres un asistente de IA útil".

},

{

"rol" : "usuario" ,

"contenido" : "Explique el concepto de entrelazamiento cuántico en términos simples".

},

],

máximo_tokens=500,

temperatura=0,7,

)

imprimir(chat_completion.choices[0].message.content) 🆚 Comparación con otros modelos líderes

contra GPT-5-Chat: Qwen3-Max Instruct toma la iniciativa en Puntos de referencia de codificación y capacidades del agente, mostrando un sólido rendimiento en tareas complejas de ingeniería de software. Sin embargo, GPT-5-Chat se beneficia de un ecosistema más maduro con funciones multimodales más amplias e integraciones comerciales más amplias. Cabe destacar que Qwen ofrece una ventana de contexto mucho más amplia (aproximadamente 262 000 tokens) en comparación con los aproximadamente 100 000 tokens de GPT-5.

contra Claude Opus 4: Qwen3-Max supera a Claude Opus 4 en las pruebas de rendimiento de agente y codificación, a la vez que admite un tamaño de contexto significativamente mayor. Claude destaca en flujos de trabajo de agente de larga duración y comportamientos centrados en la seguridad, lo que lo convierte en un sólido competidor en áreas específicas. Ambos modelos presentan un rendimiento general muy similar, aunque Claude mantiene una ventaja en tareas de edición de código conservadoras.

contra Búsqueda profunda V3.1: Qwen3-Max supera a DeepSeek V3.1 en pruebas de referencia clave para agentes como Tau2-Bench y diversos desafíos de codificación, demostrando un razonamiento más sólido y mayor capacidad para usar herramientas. Si bien DeepSeek admite entradas multimodales, se queda atrás de Qwen en el procesamiento de contexto extendido. Las innovaciones avanzadas de entrenamiento y escalado de Qwen confirman su liderazgo en tareas complejas y de gran escala.

🔌 Integración API: acceso sin inconvenientes

Qwen3-Max Instruct es fácilmente accesible a través de la API de IA/ML. La documentación completa está disponible. disponible aquí Para desarrolladores que buscan una integración perfecta.

❓ Preguntas frecuentes (FAQ)

P: ¿Qué avances arquitectónicos distinguen las capacidades de seguimiento de instrucciones de Qwen3-Max Instruct?

A: Qwen3-Max Instruct emplea un revolucionario marco de ajuste de instrucciones que combina el ajuste fino supervisado con el aprendizaje por refuerzo a partir de la retroalimentación humana a una escala sin precedentes. Su arquitectura ofrece comprensión de instrucciones multigranular, analizando directivas complejas con restricciones matizadas y lógica condicional. Mecanismos de atención avanzados ponderan dinámicamente los componentes de las instrucciones, mientras que las vías de razonamiento especializadas se activan según el tipo de instrucción, garantizando una adherencia precisa a la intención del usuario.

P: ¿Cómo logra Qwen3-Max Instruct su rendimiento innovador en instrucciones complejas y multimodales?

R: El modelo integra el procesamiento de instrucciones intermodales, la comprensión y la ejecución de directivas en texto, código, notación matemática y diagramas conceptuales mediante el aprendizaje de representación unificada. Emplea la descomposición jerárquica de instrucciones, descomponiendo solicitudes complejas en subtareas ejecutables con seguimiento de dependencias. Los algoritmos avanzados de satisfacción de restricciones garantizan el cumplimiento de todos los requisitos, mientras que la adaptación dinámica de estilos se ajusta a los tonos y formatos solicitados.

P: ¿Qué capacidades especializadas de seguimiento de instrucciones hacen que este modelo sea excepcional para aplicaciones empresariales?

R: Qwen3-Max Instruct ofrece capacidades de instrucción de nivel empresarial, incluyendo un cumplimiento preciso de los estándares de formato empresarial, la aplicación consistente de las directrices de imagen de marca, la ejecución precisa de las especificaciones técnicas y el cumplimiento fiable de los requisitos normativos. Se destaca en el procesamiento de instrucciones específicas de la industria con interpretación adaptada al dominio, manteniendo la comprensión del contexto en secuencias extendidas y proporcionando trazas de ejecución transparentes para su verificación.

P: ¿Cómo maneja el modelo instrucciones ambiguas o conflictivas manteniendo al mismo tiempo su utilidad?

R: La arquitectura incorpora sofisticados mecanismos de resolución de instrucciones que identifican ambigüedades, posibles conflictos y elementos subespecificados mediante razonamiento probabilístico y análisis de contexto. Ante instrucciones ambiguas, el modelo emplea protocolos de clarificación, sugiriendo interpretaciones y manteniendo la flexibilidad. Para directivas conflictivas, implementa una resolución basada en prioridades mediante jerarquías aprendidas de la intención del usuario, lo que garantiza tanto la fidelidad de la instrucción como su utilidad práctica.

P: ¿Qué características de seguridad y alineación garantizan la ejecución responsable de instrucciones?

R: Qwen3-Max Instruct incorpora una verificación de seguridad multicapa, que evalúa las instrucciones según las directrices éticas y los posibles daños antes de su ejecución. El modelo incluye la depuración de instrucciones para neutralizar reinterpretaciones perjudiciales, una ejecución que preserva el valor y mantiene las restricciones éticas, y un razonamiento transparente sobre las decisiones relacionadas con la seguridad. Estas medidas de seguridad garantizan que el modelo siga siendo útil, inocuo y honesto al ejecutar instrucciones complejas y abiertas.

Patio de juegos de IA

Acceso

Acceso