const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-next-80b-a3b-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-next-80b-a3b-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalle del producto

Instrucción Qwen3-Next-80B-A3B Es un modelo de lenguaje grande altamente avanzado, optimizado para instrucciones, diseñado para una velocidad excepcional, estabilidad y manejo de contextos ultralargos con alto rendimiento. Logra mejoras significativas en velocidad y rentabilidad al activar solo una pequeña parte de sus 80 mil millones de parámetros, sin comprometer el rendimiento en áreas críticas como el razonamiento complejo y la generación de código.

⚙️ Especificaciones técnicas

Qwen3-Next-80B-A3B Instruct optimiza sus operaciones mediante activando solo alrededor de 3 mil millones de parámetros de 80 mil millones durante la inferenciaEste mecanismo de activación dispersa ofrece ventajas sustanciales:

- Velocidad y rentabilidad: Funciona aproximadamente 10 veces más rápido y de forma más rentable en comparación con el modelo Qwen3-32B anterior.

- Rendimiento: Ofrece un rendimiento 10 veces mayor al procesar contextos largos de 32 000 tokens o más.

- Implementación flexible: Ofrece opciones de implementación versátiles, que incluyen alojamiento sin servidor, dedicado a pedido y reservado mensualmente.

- Compatibilidad de implementación: Compatible con SGLang y vLLM para un uso eficiente y escalable, con capacidades avanzadas de predicción de múltiples tokens.

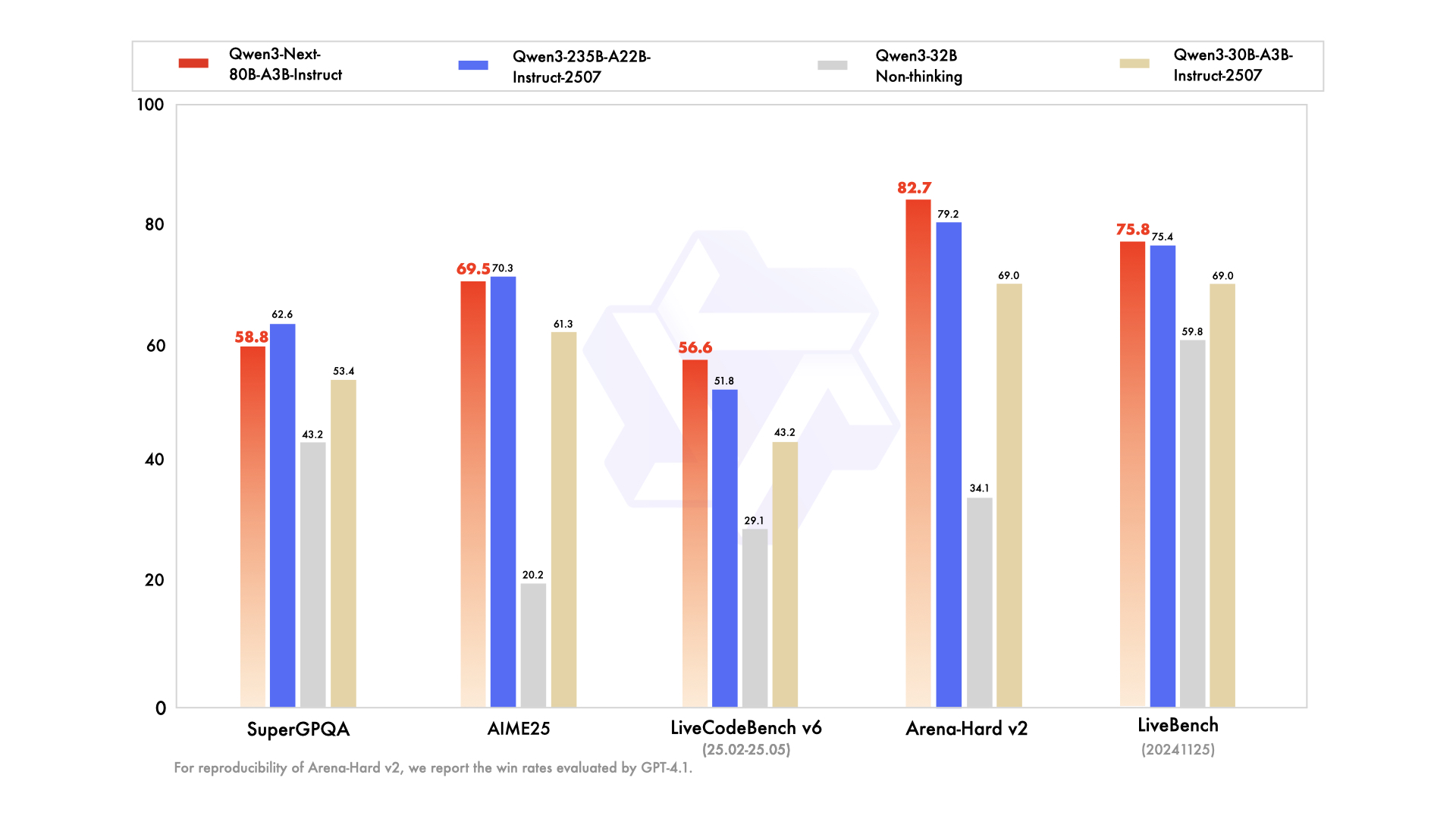

📊 Puntos de referencia de rendimiento

- ✅ Rendimiento de primer nivel: Coincide o se aproxima mucho al rendimiento del modelo insignia Qwen3-235B en diversas tareas de razonamiento, finalización de código y seguimiento de instrucciones.

- ✅ Manejo inquebrantable de contextos largos: Proporciona consistentemente respuestas estables y deterministas, destacándose particularmente en tareas que exigen una comprensión extensa del contexto.

- ✅ Eficiente en el uso de recursos: Supera en eficiencia a los modelos anteriores de tamaño mediano optimizados por instrucciones, logrando un alto rendimiento con menos recursos computacionales.

- ✅ Integración versátil: Muy adecuado para la integración de herramientas, recuperación-generación aumentada (RAG) y flujos de trabajo de agentes sofisticados que requieren resultados de cadena de pensamiento consistentes.

💰 Precios de la API

Aporte: $0.1575

Producción: $1.6

✨ Capacidades clave

- Inferencia ultra eficiente: Emplea una arquitectura dispersa de mezcla de expertos (MoE), activando dinámicamente solo 3 mil millones de parámetros de 80 mil millones para una inferencia significativamente más rápida y rentable.

- 🧠 Desempeño excepcional en tareas: Se destaca en una amplia gama de tareas complejas, incluido razonamiento avanzado, generación de código robusto, respuesta precisa a preguntas de conocimiento y aplicaciones multilingües versátiles.

- ⚡️ Respuestas estables y rápidas: Optimizado para el modo de instrucción, garantizando respuestas rápidas y consistentes sin pasos de "pensamiento" intermedios.

- Manejo de contextos ultra largos: Cuenta con una longitud de contexto nativa de 262 000 tokens, ampliable hasta un impresionante millón de tokens utilizando tecnología de escalamiento avanzada.

- 📈 Alto rendimiento: Logra una mejora de 10 veces en el rendimiento para procesar contextos extensos y largos en comparación con los modelos anteriores.

- 💬 Diálogo y respuestas consistentes: Ideal para diálogos de varios turnos y tareas que exigen respuestas finales deterministas y consistentes.

- 🛠️ Flujos de trabajo de agentes avanzados: Fuertes capacidades para llamada de herramientas, ejecución de tareas de múltiples pasos y flujos de trabajo de agentes sofisticados con herramientas perfectamente integradas.

💡 Casos de uso

- Generación de código: Acelere el desarrollo de software mediante sugerencias de código inteligentes y generación de bloques de código completos.

- Creación y edición de contenido: Genere contenido diverso, desde artículos hasta textos de marketing, y realice ediciones complejas siguiendo instrucciones detalladas.

- Análisis de datos: Facilitar la interpretación de datos complejos, el análisis estadístico y la generación de informes completos.

- Automatización del servicio al cliente: Mejore la eficiencia de la atención al cliente con un manejo preciso de instrucciones y respuestas automatizadas.

- Documentación técnica: Agilice la creación de documentos técnicos, manuales y resultados específicos del formato.

- Automatización de procesos: Ejecute tareas de varios pasos e integre llamadas de herramientas para automatizar y agilizar diversos flujos de trabajo.

- Conversaciones largas y manejo de documentos: Gestione de forma eficiente diálogos extensos, resuma documentos grandes y extraiga información clave de textos extensos.

💻 Ejemplo de código

import openai client = openai.OpenAI( base_url="https://api.perplexity.ai", # URL base de ejemplo, reemplazar con el punto final real api_key="YOUR_API_KEY", # Reemplazar con su clave API real ) messages = [ { "role": "system", "content": "Eres Qwen3-Next-80B-A3B Instruct, un útil asistente de IA." }, { "role": "user", "content": "Explica el concepto de entrelazamiento cuántico en términos sencillos para un estudiante de secundaria." }, ] response = client.chat.completions.create( model="alibaba/qwen3-next-80b-a3b-instruct", messages=messages, max_tokens=500, temperature=0.7, top_p=0.9, frequency_penalty=0, presence_penalty=0, ) print(response.choices[0].message.content) Nota: En el ejemplo anterior, `base_url` y `api_key` son marcadores de posición. Consulte la documentación oficial de la API para obtener detalles específicos sobre la integración.

🆚 Comparación con otros modelos

El modelo 80B A3B ofrece un rendimiento que iguala o se acerca mucho al modelo insignia 235B en tareas de razonamiento y codificación, al mismo tiempo que es significativamente más eficiente al activar menos parámetros para una inferencia más rápida y rentable.

Qwen3-Next ofrece capacidades comparables de seguimiento de instrucciones y de contexto largo, que se distinguen por una ventaja en el rendimiento y un tamaño de ventana de token más grande, lo que lo hace particularmente adecuado para tareas extensas de comprensión de documentos.

Qwen3-Next muestra un desempeño superior en diálogos de múltiples turnos y flujos de trabajo agentes, brindando resultados más deterministas en contextos muy largos en comparación con las fortalezas conversacionales de Claude.

Qwen3-Next muestra un mejor escalamiento en el manejo de contextos ultra largos y una eficiencia de predicción de múltiples tokens superior, lo que le otorga una clara ventaja en el procesamiento de tareas de razonamiento complejas de múltiples pasos.

❓ Preguntas frecuentes

P1: ¿Qué hace que Qwen3-Next-80B-A3B Instruct sea excepcionalmente eficiente?

El modelo aprovecha una arquitectura dispersa de mezcla de expertos (MoE), activando solo aproximadamente 3 mil millones de sus 80 mil millones de parámetros durante la inferencia. Este enfoque innovador permite un procesamiento significativamente más rápido y menores costos operativos, logrando una eficiencia hasta 10 veces mayor que los modelos anteriores.

P2: ¿Cómo funciona con contextos ultra largos?

La instrucción Qwen3-Next-80B-A3B admite una longitud de contexto nativa de 262 000 tokens y, gracias a la tecnología de escalado avanzada, puede ampliarse hasta un impresionante millón de tokens. Esta capacidad la hace ideal para tareas que requieren una comprensión profunda de documentos extensos y conversaciones largas.

P3: ¿Cómo se compara su rendimiento con el de otros modelos de lenguaje líderes?

Si bien es altamente eficiente, Qwen3-Next-80B-A3B Instruct iguala o se acerca al rendimiento de modelos emblemáticos como Qwen3-235B en tareas complejas de razonamiento y generación de código. Además, ofrece capacidades comparables o superiores en rendimiento, manejo de contextos extensos y resultados deterministas en comparación con modelos como GPT-4.1, Claude 4.1 Opus y Gemini 2.5 Flash.

P4: ¿Cuáles son los principales casos de uso de Qwen3-Next-80B-A3B Instruct?

Este modelo es ideal para aplicaciones que exigen alto rendimiento, seguimiento preciso de instrucciones y un amplio procesamiento de contexto. Entre sus principales casos de uso se incluyen la generación avanzada de código, la creación sofisticada de contenido, el análisis detallado de datos, la atención al cliente automatizada, la documentación técnica y los flujos de trabajo complejos de agentes.

Q5: ¿El Instruct Qwen3-Next-80B-A3B es compatible con las infraestructuras de implementación existentes?

Sí, el modelo está diseñado para una integración fluida con herramientas de implementación existentes, como SGLang y vLLM, y admite capacidades avanzadas de predicción multitoken. También ofrece opciones de implementación flexibles, como hosting sin servidor, dedicado bajo demanda y con reserva mensual, para adaptarse a diversas necesidades operativas.

Patio de juegos de IA

Acceso

Acceso-p-130x130q80-p-130x130q80.png)