const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'zhipu/glm-4.6',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="zhipu/glm-4.6",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalhes do produto

✨ Visão geral da API GLM-4.6

GLM-4.6 é um modelo de linguagem avançado e de grande porte desenvolvido por Zhipu AI (agora Z.ai)Ele apresenta um sistema de última geração com 355 bilhões de parâmetros. Arquitetura de Mistura de Especialistas (MoE)O GLM-4.6, otimizado para uma ampla gama de tarefas, incluindo raciocínio complexo, codificação, escrita e diálogos com múltiplas interações, oferece uma capacidade ampliada de processamento. janela de contexto de 200.000 tokensEste modelo demonstra desempenho líder no setor, particularmente em programação e tarefas de agentes, tornando-o uma das principais escolhas para desenvolvedores e empresas que buscam eficiência e versatilidade.

⚙️ Especificações técnicas

- Arquitetura do modelo: Parâmetro 355B Mistura de Especialistas (MoE)

- Modalidade de entrada: Texto

- Modalidade de saída: Texto

- Tamanho da janela de contexto: 200.000 tokens (expandido de 128.000 no GLM-4.5)

- Tokens de saída máximos: 128.000 tokens

- Eficiência: Aproximadamente Consumo de tokens 30% mais eficiente do que as versões anteriores

- Linguagens de programação suportadas: Python, JavaScript, Java (para tarefas de programação)

📈 Indicadores de desempenho

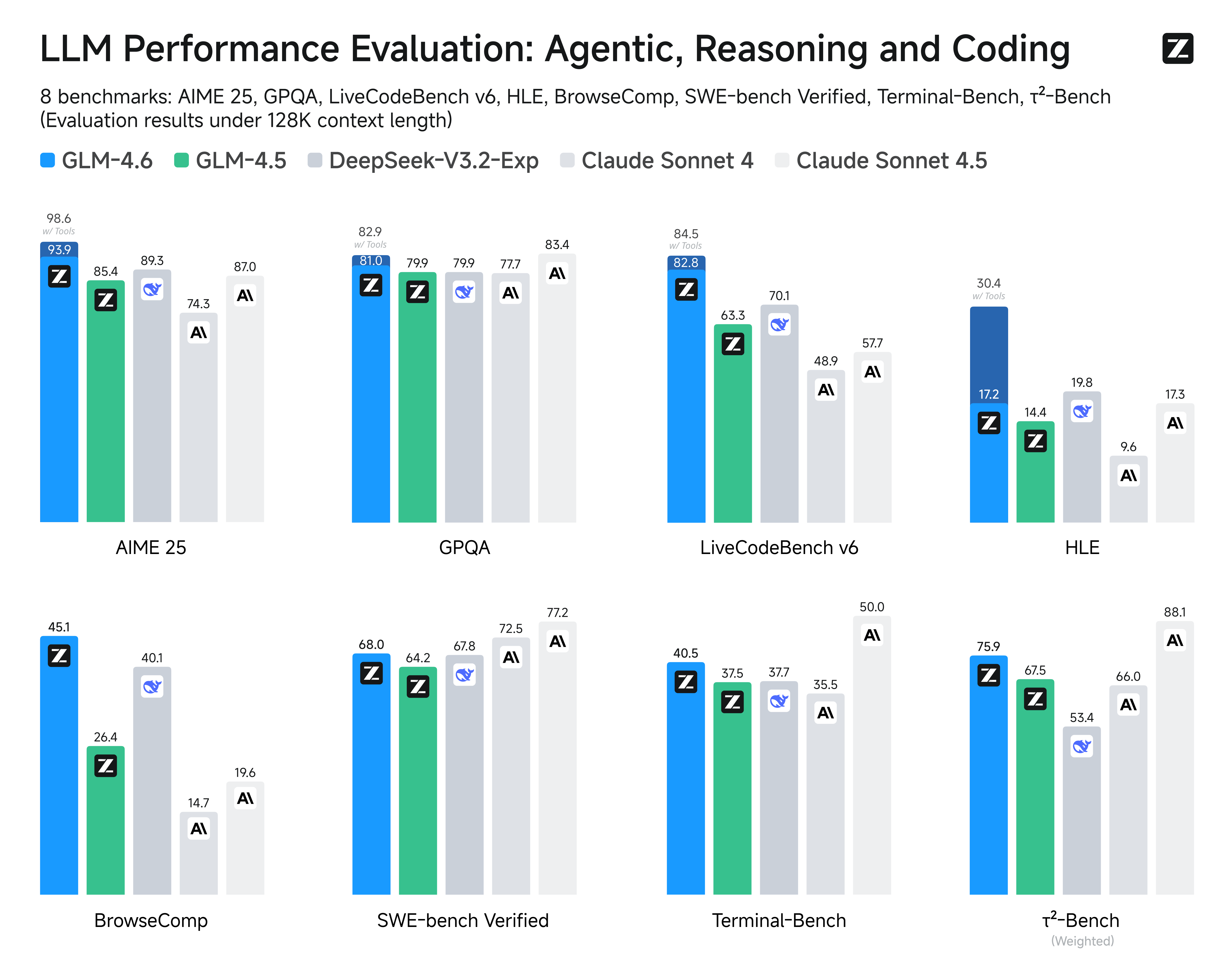

O GLM-4.6 foi rigorosamente avaliado em benchmarks de referência, demonstrando resultados competitivos ou superiores em comparação com os principais modelos:

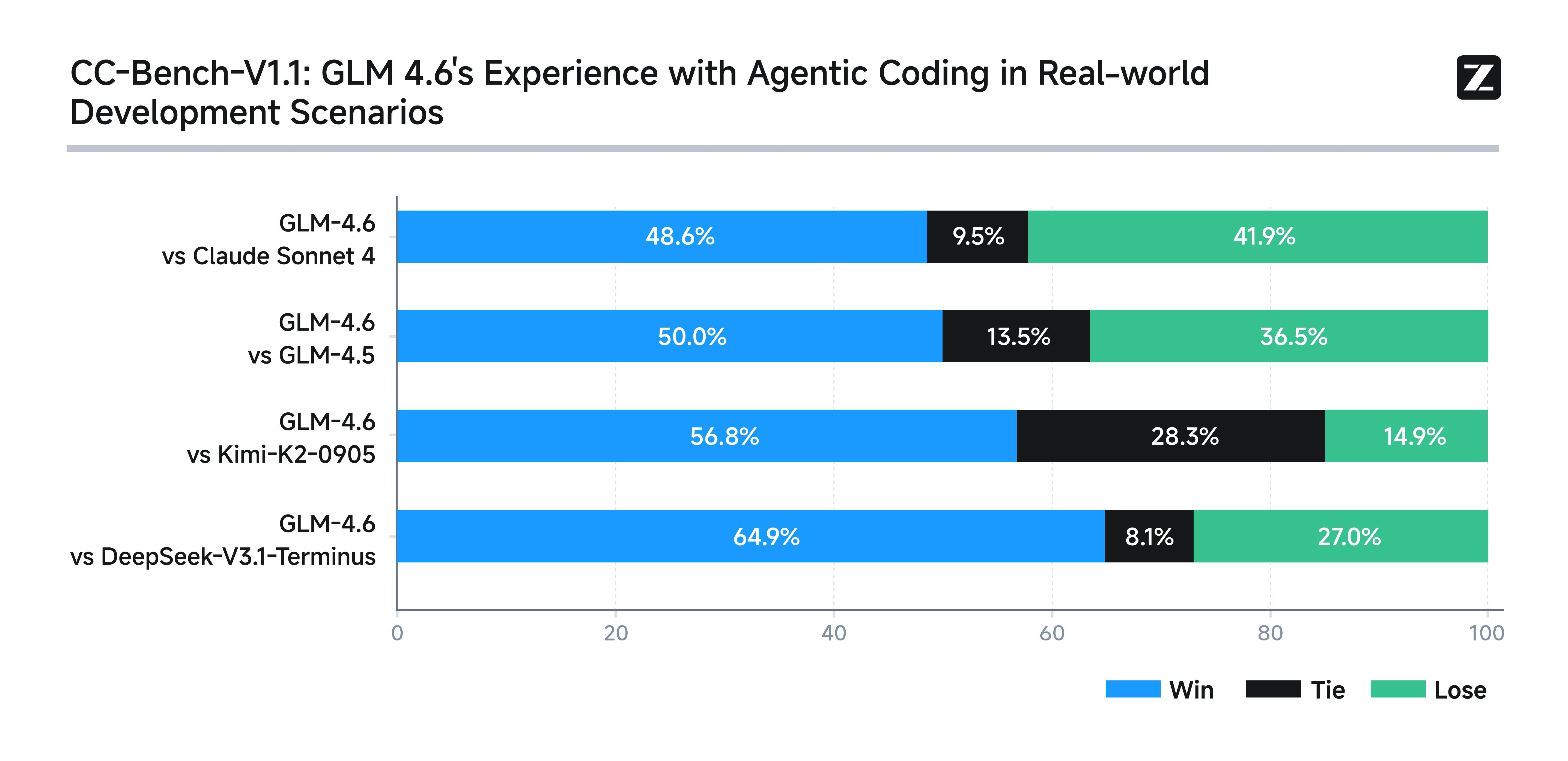

- Testes de programação do mundo real: Apresenta desempenho superior a modelos nacionais similares em 74 cenários de codificação, demonstrando melhor correção e desempenho do código.

- Eficiência comparativa: Consome aproximadamente 30% menos fichas para a mesma produção, reduzindo custos e necessidades de recursos.

- Resultados de referência: Comparável ao Claude Sonnet 4 e 4.6 em benchmarks de PNL multidomínio como AIME, GPQA, LCB v6 e SWE-Bench Verified.

- Raciocínio e tarefas do agente: Excelente desempenho na tomada de decisões e em tarefas com auxílio de ferramentas, frequentemente igualando ou superando os concorrentes em testes de referência.

- Compreensão contextual: O contexto expandido permite um desempenho superior em tarefas que exigem análise aprofundada de documentos e instruções complexas.

Imagem: Benchmarks de desempenho do GLM-4.6

💡 Principais características e funcionalidades

- Tratamento de contexto estendido: Com um enorme janela de tokens de 200 milO GLM-4.6 consegue realizar compreensão detalhada de textos longos, resolução de problemas em várias etapas e manter diálogos coerentes e prolongados.

- Desempenho de codificação superior: Supera o GLM-4.5 e muitos concorrentes nacionais em 74 testes práticos de programação no ambiente Claude Code. Destaca-se no desenvolvimento front-end, na organização de código e no planejamento autônomo.

- Raciocínio Avançado e Tomada de Decisão: A melhoria na utilização de ferramentas durante a inferência permite estruturas de agentes autônomos mais eficientes e uma execução de tarefas baseada em pesquisa mais eficaz.

- Geração de linguagem natural: Produz textos com melhor alinhamento às preferências estilísticas humanas, destacando-se em dramatizações, criação de conteúdo (romances, roteiros, anúncios) e conversas com múltiplos interlocutores.

Imagem: Principais características e funcionalidades do GLM-4.6

💰 Preços da API GLM-4.6

- Entrada: $ 0,63

- Saída: $ 2,31

- Em cache: $ 0,1155

🚀 Casos de uso para GLM-4.6

- Análise de documentos de contexto extenso e sumarização

- raciocínio complexo em várias etapas e resolução de problemas

- Programação do mundo real e geração de código em várias linguagens

- Criação de conteúdo em linguagem natural incluindo escrita criativa e roteiros

- Chatbots com conversas contínuas e coerentes em várias etapas.

- Sistemas agentes com uso de ferramentas e tomada de decisão autônoma

- Aplicações industriais de alto volume exigindo modelos com uso eficiente de tokens

💻 Exemplo de código

Esta seção normalmente apresentaria um trecho de código interativo para integração de API, por exemplo:

import openai from openai import OpenAI # Para Zhipu AI (Z.ai) GLM-4.6 client = OpenAI( api_key= "YOUR_API_KEY" , base_url= "https://api.z.ai/v1" , # Exemplo de URL base ) completion = client.chat.completions.create( model= "zhipu/glm-4.6" , messages=[ { "role" : "system" , "content" : "Você é um assistente prestativo." }, { "role" : "user" , "content" : "Explique grandes modelos de linguagem em termos simples." } ] ) print (completion.choices[0].message.content)⚖️ Comparação com outros modelos

Contra GLM-4.5: O GLM-4.6 oferece melhorias notáveis na precisão da geração de código e mantém uma vantagem consistente no tratamento de entradas de contexto ultralongas, ao mesmo tempo que preserva um forte desempenho em tarefas de agentes, próximo ao GLM-4.5.

Contra OpenAI GPT-4.5: O GLM-4.6 reduz a diferença na precisão do raciocínio e em tarefas de múltiplas etapas, aproveitando sua janela de contexto muito maior; no entanto, o GPT-4.5 ainda lidera em precisão bruta da tarefa em alguns benchmarks padronizados.

Contra Soneto 4 de Claude: Embora o Claude 4 Sonnet se destaque em codificação e eficiência multiagente, o GLM-4.6 o iguala ou o supera em raciocínio agentivo e compreensão de documentos longos, tornando-o mais robusto para aplicações de contexto estendido.

Contra Gemini 2.5 Pro: O GLM-4.6 equilibra recursos avançados de raciocínio e codificação com uma compreensão aprimorada de documentos longos, enquanto o Gemini 2.5 Pro concentra-se mais na otimização de benchmarks individuais de codificação e raciocínio.

🔗 Integração de API

Acessível via API de IA/ML. Para obter documentação detalhada, consulte: Documentação da API GLM-4.6.

❓ Perguntas frequentes (FAQ)

Q1: O que é o GLM-4.6 e quais melhorias significativas ele oferece?

O GLM-4.6 é a versão mais recente da série de Modelos Gerais de Linguagem da Zhipu AI, apresentando melhorias substanciais nas capacidades de raciocínio, desempenho multilíngue e conhecimento especializado de domínio. As principais melhorias incluem raciocínio matemático e lógico avançado, melhor geração e compreensão de código, suporte multilíngue aprimorado com capacidades superiores em chinês e maior eficiência no processamento de tarefas complexas e com várias etapas.

Q2: Como o GLM-4.6 se compara a outros modelos de linguagem líderes, como o GPT-4 e o Claude?

O GLM-4.6 demonstra desempenho competitivo com modelos de ponta, destacando-se particularmente em tarefas de linguagem chinesa, raciocínio matemático e aplicações de programação. Embora possa apresentar pontos fortes diferentes do GPT-4 em escrita criativa ou do Claude em adequação à segurança, ele frequentemente iguala ou supera modelos comparáveis em domínios técnicos e compreensão de idiomas asiáticos. Sua arquitetura eficiente também proporciona vantagens de custo para muitas aplicações corporativas.

Q3: Quais são as principais inovações técnicas na arquitetura do GLM-4.6?

O GLM-4.6 introduz diversas inovações arquitetônicas: mecanismos de atenção aprimorados para melhor processamento de contextos longos, técnicas de treinamento aperfeiçoadas para raciocínio matemático e lógico, tokenização otimizada para eficiência multilíngue, abordagens avançadas de ajuste fino para domínios especializados e melhor eficiência de parâmetros, que proporciona alto desempenho sem exigir escalabilidade extrema. Essas inovações contribuem para seu desempenho equilibrado em diversas tarefas.

Q4: Para quais aplicações práticas o GLM-4.6 é particularmente adequado?

O GLM-4.6 se destaca em: aplicações empresariais em mercados asiáticos que exigem forte suporte ao idioma chinês, documentação técnica e geração de código, análise matemática e científica, ferramentas educacionais para disciplinas STEM (Ciência, Tecnologia, Engenharia e Matemática), inteligência de negócios e análise de dados, e automação de atendimento ao cliente multilíngue. Seu desempenho equilibrado o torna versátil para tarefas criativas e analíticas em diversos setores.

Q5: Como o GLM-4.6 aborda aplicações multilíngues e interculturais?

O GLM-4.6 apresenta sofisticadas capacidades multilíngues, com particular destaque para o chinês e outros idiomas asiáticos, incluindo a compreensão do contexto cultural, expressões idiomáticas e variações regionais. O modelo demonstra forte aprendizado por transferência entre idiomas, permitindo um desempenho eficaz mesmo quando os dados de treinamento são distribuídos de forma desigual entre os idiomas. Isso o torna especialmente valioso para empresas globais que operam em mercados asiáticos ou que necessitam de um suporte multilíngue robusto.

Playground de IA

Conecte-se

Conecte-se