const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'alibaba/qwen3-max-instruct',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="alibaba/qwen3-max-instruct",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalhes do produto

Descobrir Qwen3-Max InstruçõesO Alibaba Cloud, o revolucionário modelo de linguagem em larga escala (LLM) da Alibaba, foi oficialmente apresentado no início de 2025. Este modelo de IA de ponta possui mais de [número omitido] recursos. 1 trilhão de parâmetros, marcando um salto significativo na inteligência artificial em larga escala. Treinada em conjuntos de dados massivos com uma arquitetura avançada, a Qwen3-Max Instruct demonstra capacidades excepcionais, particularmente em tarefas técnicas, de programação e matemáticasEsta variante com instruções ajustadas é especificamente otimizada para instruções rápidas e diretas, eliminando a necessidade de raciocínio passo a passo e fornecendo respostas rápidas e precisas.

✨ Especificações técnicas: Potência incomparável

- 🚀 Escala de parâmetros: Mais de 1 trilhão de parâmetros (escala de nível de trilhão)

- 💾 Dados de treinamento: 36 trilhões de tokens de dados de pré-treinamento

- 🧠 Arquitetura do Modelo: Transformador Mixture of Experts (MoE) com balanceamento de carga global em lote para maior eficiência.

- 📚 Comprimento do contexto: Até 262.144 tokens (suportando mais de 258 mil tokens de entrada + 65 mil tokens de saída)

- ⚡ Eficiência do Treinamento: Melhoria de 30% no MFU em comparação com a geração anterior do modelo Qwen 2.5 Max.

- 🗣️ Idiomas suportados: Mais de 100 idiomas, com melhorias específicas para contextos mistos de chinês e inglês.

- 💡 Modo de inferência: Modo não-pensamento, priorizando respostas rápidas e diretas a instruções (Versão com pensamento em desenvolvimento)

- 🔄 Cache de contexto: Permite a reutilização de chaves de contexto para melhorar significativamente o desempenho em conversas com múltiplas interações.

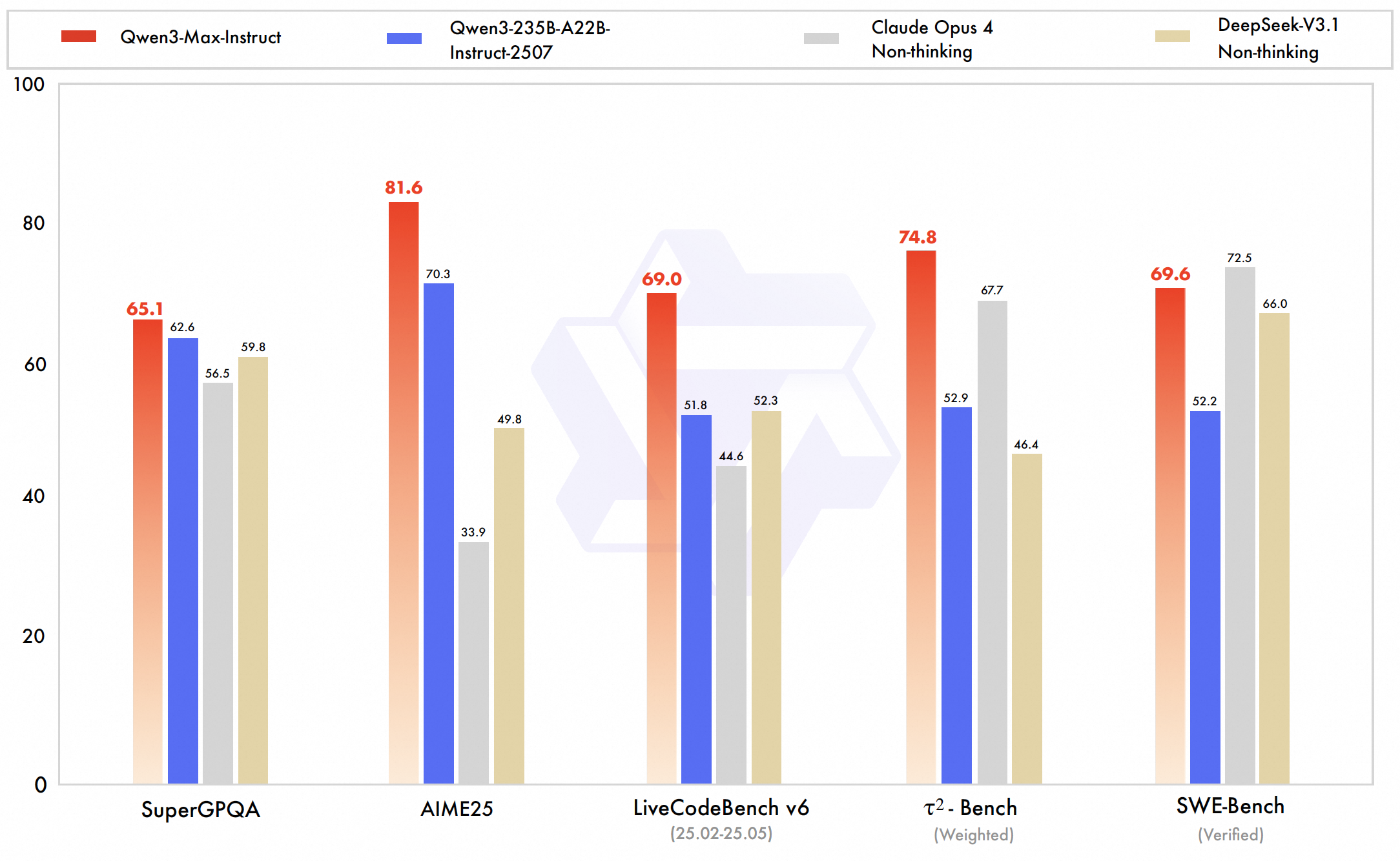

📊 Indicadores de desempenho e destaques: Definindo novos padrões

O Qwen3-Max atinge um desempenho de classe mundial, destacando-se particularmente em código, raciocínio matemático e domínios técnicosOs testes internos da Alibaba e os resultados dos rankings confirmam sua superioridade ou equivalência a modelos de IA de ponta, como GPT-5-Chat, Claude Opus 4 e DeepSeek V3.1, em diversos benchmarks.

- 💻 Verificado pelo SWE-Bench: 69,6 (Demonstra forte capacidade de resolução de desafios de programação do mundo real)

- 🔬 Banco Tau2: 74,8 (Supera o Claude Opus 4 e o DeepSeek V3.1)

- ❓ SuperGPQA: 81,4 (desempenho em responder a perguntas importantes)

- ✍️ LiveCodeBench: Excelentes resultados no desafio de código real

- 🧮 AIME25 (Raciocínio Matemático): 80,6 (superando muitos concorrentes)

- 🏆 Arena-Difícil v2: 86,1 (desempenho excepcional em tarefas difíceis)

- 🏅 Classificação da Arena LM: Em 6º lugar geral, superando muitos modelos de última geração, exceto os melhores modelos conversacionais como o GPT-40.

💰 Preços da API: IA em larga escala com ótimo custo-benefício

- Preço de entrada: $ 1,26 por milhão de tokens

- Preço de saída: $ 6,30 por milhão de tokens

💡 Principais casos de uso: Impulsionando a inovação empresarial

- 🏢 Aplicações Empresariais: Ideal para domínios técnicos que exigem processamento de contexto extenso, como: geração de código, modelagem matemática e assistência em pesquisa.

- 🌍 Suporte multilíngue: Aplicações robustas, bilíngues e internacionais com forte domínio de idiomas mistos chinês-inglês.

- 📜 Janelas de contexto enormes: Permite a compreensão de documentos extremamente longos e diálogos de múltiplas interações com persistência.

- 🛠️ Ferramenta pronta para uso: Otimizado para geração aprimorada por recuperação de dados e integração com ferramentas externas.

- 🚀 Respostas rápidas: Prioriza a execução rápida de instruções sem a sobrecarga de raciocínio complexo.

- 🔗 Integração do Ecossistema: Parte da família Qwen3 da Alibaba, incluindo variantes de visão e raciocínio (Qwen-VL-Max e Qwen3-Max-Thinking).

💻 Exemplo de código: Primeiros passos

importar openai

cliente = openai. OpenAI (

base_url= "https://api.ai.cc/v1" ,

api_key= "SUA_CHAVE_DE_API" ,

)

chat_completion = client.chat.completions.create (

modelo= "alibaba/qwen3-max-instruct" ,

mensagens=[

{

"papel" : "sistema" ,

"Conteúdo" : "Você é um assistente de IA útil."

},

{

"papel" : "usuário" ,

"Conteúdo" : "Explique o conceito de emaranhamento quântico em termos simples."

},

],

max_tokens=500,

temperatura=0,7,

)

print(chat_completion.choices[0].message.content) 🆚 Comparação com outros modelos líderes

vs GPT-5-Chat: Qwen3-Max Instruct assume a liderança em benchmarks de codificação e capacidades do agenteO Qwen demonstra um desempenho robusto em tarefas complexas de engenharia de software. O GPT-5-Chat, por sua vez, beneficia-se de um ecossistema mais maduro, com recursos multimodais mais abrangentes e maior integração comercial. Notavelmente, o Qwen oferece uma janela de contexto muito maior (aproximadamente 262 mil tokens) em comparação com os cerca de 100 mil tokens do GPT-5.

vs Claude Opus 4: O Qwen3-Max supera o Claude Opus 4 tanto em benchmarks de desempenho de agentes quanto de codificação, além de suportar um tamanho de contexto significativamente maior. O Claude se destaca em fluxos de trabalho de agentes de longa duração e comportamentos focados em segurança, tornando-se um forte concorrente em áreas específicas. Ambos os modelos apresentam desempenho geral bastante similar, embora o Claude mantenha uma vantagem em tarefas de edição de código conservadoras.

vs DeepSeek V3.1: O Qwen3-Max supera o DeepSeek V3.1 em benchmarks importantes para agentes, como o Tau2-Bench, e em diversos desafios de programação, demonstrando maior capacidade de raciocínio e uso de ferramentas. Embora o DeepSeek suporte entradas multimodais, fica atrás do Qwen no processamento de contexto estendido. As inovações avançadas de treinamento e escalabilidade do Qwen confirmam sua liderança em tarefas complexas e de grande escala.

🔌 Integração de API: Acesso simplificado

O Qwen3-Max Instruct é facilmente acessível através da API de IA/ML. A documentação completa está disponível. disponível aqui Para desenvolvedores que buscam integração perfeita.

❓ Perguntas frequentes (FAQ)

P: Quais avanços arquitetônicos distinguem as capacidades de seguimento de instruções do Qwen3-Max Instruct?

A: O Qwen3-Max Instruct emprega uma estrutura revolucionária de ajuste de instruções que combina ajuste fino supervisionado com aprendizado por reforço a partir de feedback humano em uma escala sem precedentes. Sua arquitetura apresenta compreensão de instruções multigranular, analisando diretivas complexas com restrições sutis e lógica condicional. Mecanismos avançados de atenção ponderam dinamicamente os componentes da instrução, enquanto vias de raciocínio especializadas são ativadas com base no tipo de instrução, garantindo a adesão precisa à intenção do usuário.

P: Como o Qwen3-Max Instruct alcança seu desempenho inovador em instruções complexas e multimodais?

A: O modelo integra o processamento de instruções multimodais, compreendendo e executando diretivas em texto, código, notação matemática e diagramas conceituais por meio de aprendizado de representação unificada. Ele emprega decomposição hierárquica de instruções, dividindo solicitações complexas em subtarefas executáveis com rastreamento de dependências. Algoritmos avançados de satisfação de restrições garantem que todos os requisitos sejam atendidos, enquanto a adaptação dinâmica de estilo corresponde aos tons e formatos solicitados.

P: Quais recursos especializados de seguimento de instruções tornam este modelo excepcional para aplicações empresariais?

A: O Qwen3-Max Instruct oferece recursos de instrução de nível empresarial, incluindo aderência precisa aos padrões de formatação de negócios, aplicação consistente das diretrizes de identidade visual da marca, execução precisa de especificações técnicas e conformidade confiável com os requisitos regulatórios. Ele se destaca no processamento de instruções específicas do setor com interpretação sensível ao domínio, mantendo a consciência contextual em sequências extensas e fornecendo rastreamentos de execução transparentes para verificação.

P: Como o modelo lida com instruções ambíguas ou conflitantes, mantendo sua utilidade?

A: A arquitetura incorpora mecanismos sofisticados de resolução de instruções que identificam ambiguidades, potenciais conflitos e elementos subespecificados por meio de raciocínio probabilístico e análise de contexto. Ao se deparar com instruções ambíguas, o modelo emprega protocolos de esclarecimento, sugerindo interpretações e, ao mesmo tempo, mantendo a flexibilidade. Para instruções conflitantes, implementa uma resolução baseada em prioridades, utilizando hierarquias aprendidas da intenção do usuário, garantindo tanto a fidelidade da instrução quanto a utilidade prática.

P: Quais recursos de segurança e alinhamento garantem a execução responsável das instruções?

A: O Qwen3-Max Instruct incorpora verificação de segurança em múltiplas camadas, avaliando as instruções em relação a diretrizes éticas e potenciais danos antes da execução. O modelo apresenta higienização de instruções para neutralizar reinterpretações prejudiciais, execução que preserva valores e mantém restrições éticas, e raciocínio transparente sobre decisões relacionadas à segurança. Essas salvaguardas garantem que o modelo permaneça útil, inofensivo e honesto ao executar instruções complexas e de final aberto.

Playground de IA

Conecte-se

Conecte-se