const { OpenAI } = require('openai');

const api = new OpenAI({

baseURL: 'https://api.ai.cc/v1',

apiKey: '',

});

const main = async () => {

const result = await api.chat.completions.create({

model: 'deepseek/deepseek-non-reasoner-v3.1-terminus',

messages: [

{

role: 'system',

content: 'You are an AI assistant who knows everything.',

},

{

role: 'user',

content: 'Tell me, why is the sky blue?'

}

],

});

const message = result.choices[0].message.content;

console.log(`Assistant: ${message}`);

};

main();

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.ai.cc/v1",

api_key="",

)

response = client.chat.completions.create(

model="deepseek/deepseek-non-reasoner-v3.1-terminus",

messages=[

{

"role": "system",

"content": "You are an AI assistant who knows everything.",

},

{

"role": "user",

"content": "Tell me, why is the sky blue?"

},

],

)

message = response.choices[0].message.content

print(f"Assistant: {message}")

Detalle del producto

✨ DeepSeek V3.1 Terminus (modo sin razonamiento): IA de alta velocidad y eficiente para tareas directas

El Terminal DeepSeek V3.1 modelo, específicamente en su modo sin razonamientoSe presenta como un modelo avanzado de lenguaje grande, meticulosamente diseñado para tareas de generación rápidas, eficientes y ligeras. Está diseñado para destacar donde no se requiere un razonamiento analítico profundo, lo que lo hace perfecto para la generación de contenido directa. Como parte de la serie DeepSeek V3.1, ofrece mejoras sustanciales en estabilidad, consistencia multilingüe y fiabilidad en el uso de herramientas, lo que lo convierte en la opción ideal para flujos de trabajo de agentes que exigen velocidad y bajo consumo de recursos.

⚙️ Especificaciones técnicas

- • Familia de modelos: DeepSeek V3.1 Terminus (Modo sin razonamiento)

- • Parámetros: 671 mil millones en total, 37 mil millones activos en inferencia

- • Arquitectura: Maestría en Derecho (LLM) híbrida con inferencia de modo dual (pensamiento y no pensamiento)

- • Ventana de contexto: Admite hasta 128.000 tokens entrenamiento de contexto largo

- • Precisión y eficiencia: Utiliza Microescalamiento FP8 para la memoria y la eficiencia de inferencia

- • Modos: El modo sin razonamiento desactiva la cadena elaborada de pensamiento para respuestas más rápidas

- • Soporte de idiomas: Se mejoró la coherencia multilingüe, especialmente en Inglés y chino

📊 Puntos de referencia de rendimiento

- • Razonamiento (MMLU-Pro): 85.0 (ligera mejora)

- • Navegación web de Agentic (BrowseComp): 38.5 (importantes ganancias en el uso de herramientas en varios pasos)

- • Línea de comandos (Terminal-bench): 36.7 (mejor manejo de la secuencia de comandos)

- • Generación de código (LiveCodeBench): 74.9 (se mantienen altas capacidades)

- • Verificación de ingeniería de software (SWE verificado): 68.4 (mejora en la precisión de la validación)

- • Precisión de control de calidad (SimpleQA): 96.8 (rendimiento robusto)

- • Estabilidad general: Varianza reducida y resultados más deterministas para una mayor confiabilidad en el mundo real.

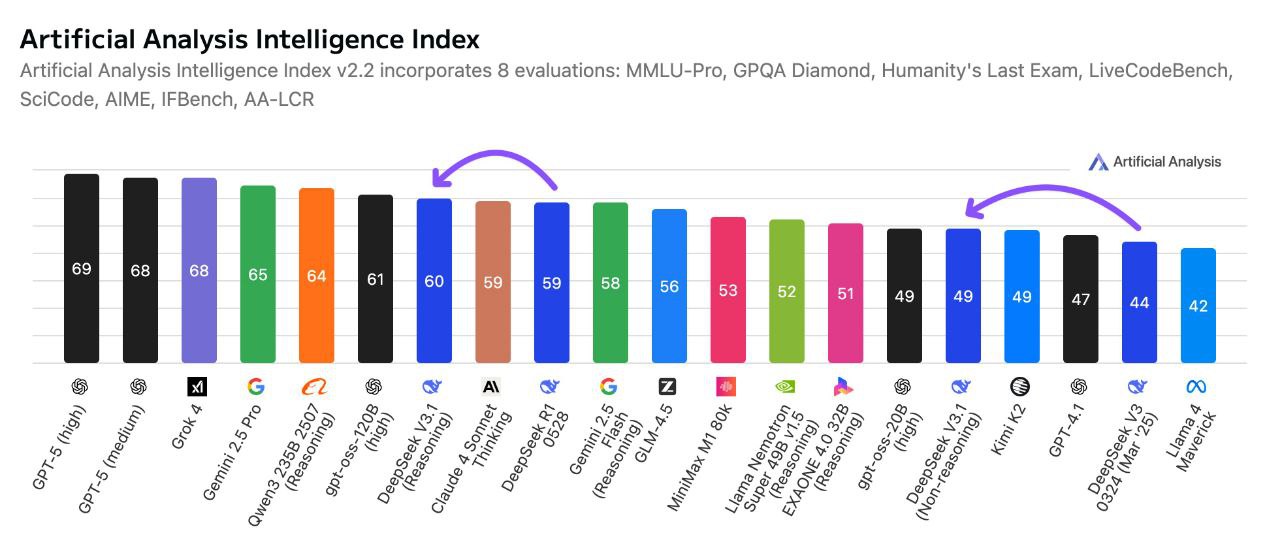

Puntos de referencia de rendimiento: DeepSeek V3.1 Terminus en acción

⭐ Características principales

- 🚀 Generación rápida y ligera: El modo de no pensar priorizado garantiza reducción del tiempo de procesamiento y del consumo de recursos, ideal para salidas rápidas.

- 🌐 Salida multilingüe robusta: Las mejoras evitan la mezcla de idiomas y los tokens inconsistentes, lo que respalda aplicaciones globales.

- 🛠️ Uso mejorado de herramientas: Refuerza la confiabilidad en los flujos de trabajo de invocación de herramientas, incluidos Ejecución de código y cadenas de búsqueda web.

- 📖 Contexto largo flexible: Admite contextos masivos de hasta 128.000 tokens para amplios historiales de entrada.

- ✅ Resultados estables y consistentes: Las optimizaciones posteriores al entrenamiento reducen significativamente las alucinaciones y los artefactos de tokenización.

- 🔄 Compatible con versiones anteriores: Se integra perfectamente en los ecosistemas API de DeepSeek existentes sin cambios disruptivos.

- ⚡ Inferencia híbrida escalable: Equilibra la capacidad del modelo a gran escala con una implementación eficiente de parámetros activos.

💰 Precios de la API

- • 1 millón de tokens de entrada: $0.294

- • 1 millón de tokens de salida: $0.441

💡 Casos de uso prácticos

- 💬 Atención al cliente rápida: Respuestas de chatbot rápidas y eficientes.

- ✍️ Generación de contenido multilingüe: Textos de marketing, resúmenes y mucho más en distintos idiomas.

- 👨💻 Asistencia de codificación automatizada: Ejecución de scripts y generación de código básico.

- 📚 Consulta de la base de conocimientos: Búsqueda y recuperación eficiente dentro de documentos largos.

- ⚙️ Automatización de tareas asistida por herramientas: Flujos de trabajo optimizados con invocación de herramientas confiable.

- 📄 Resumen rápido del documento: Reseñas rápidas sin explicaciones analíticas profundas.

Ejemplo de código

🤝 Comparación con otros modelos líderes

Terminal DeepSeek V3.1 frente a. GPT-4: DeepSeek V3.1 Terminus ofrece una ventana de contexto significativamente más grande (hasta 128.000 tokens) en comparación con los 32 000 tokens de GPT-4, lo que lo hace superior para documentos e investigaciones extensas. Está optimizado para generación más rápida en su modo especializado de no razonamiento, mientras que GPT-4 prioriza el razonamiento detallado con mayor latencia.

Terminal DeepSeek V3.1 frente a. GPT-5: Si bien GPT-5 se destaca en tareas multimodales y una integración de ecosistemas más amplia con un contexto aún más grande, DeepSeek V3.1 Terminus enfatiza rentabilidad y licencias de peso abierto, atractivo para desarrolladores y empresas emergentes centradas en las capacidades de infraestructura.

Terminal DeepSeek V3.1 frente a. Claude 4.5: Claude 4.5 prioriza la seguridad, la alineación y el razonamiento sólido con una IA constitucional robusta. DeepSeek V3.1 Terminus se centra en ligero, salida rápidaClaude suele tener precios más altos por tarea, favorecidos en industrias reguladas, mientras que DeepSeek ofrece licencias abiertas y accesibilidad para prototipado rápido.

Terminal DeepSeek V3.1 frente a. OpenAI GPT-4.5: GPT-4.5 mejora el razonamiento y la escritura creativa, pero comparte una ventana de contexto de tokens de 128K similar a la de DeepSeek. DeepSeek V3.1 Terminus logra... tiempos de respuesta más rápidos en su modo sin razonamiento, lo que lo hace ideal para aplicaciones de velocidad crítica sin una cadena de pensamiento compleja. GPT-4.5 cuenta con una generación creativa más sólida y una integración del ecosistema, mientras que DeepSeek destaca en escalabilidad y rentabilidad.

❓ Preguntas frecuentes (FAQ)

P: ¿Qué significa “sin razonamiento” para DeepSeek V3.1 Terminus?

R: «Sin razonamiento» significa que este modelo está optimizado para tareas que no exigen deducción lógica compleja, resolución de problemas de varios pasos ni análisis profundo. Prioriza la generación directa de texto, preguntas y respuestas sencillas y un procesamiento directo con la máxima eficiencia y velocidad.

P: ¿Cuáles son las principales ventajas de utilizar la variante sin razonamiento?

R: Las ventajas clave incluyen tiempos de respuesta significativamente más rápidos, menores costos computacionales, mayor rendimiento, uso eficiente de recursos y rendimiento optimizado para tareas simples donde no son necesarias todas las capacidades de razonamiento de los modelos estándar.

P: ¿Cuál es el tamaño de la ventana de contexto para DeepSeek V3.1 Terminus Non-Reasoning?

A: DeepSeek V3.1 Terminus Non-Reasoning presenta una impresionante Ventana de contexto de token de 128K, lo que le permite procesar documentos extensos y mantener el contexto de manera efectiva para tareas simples de generación y procesamiento de texto.

P: ¿Para qué tipos de tareas es más adecuado este modelo?

R: Es ideal para la generación de texto simple, preguntas y respuestas básicas, resumen de contenido, clasificación de texto, traducciones sencillas, llenado de plantillas, extracción de datos y cualquier aplicación que requiera un procesamiento de texto rápido y confiable sin razonamiento complejo.

P: ¿Cómo se compara su velocidad con los modelos de razonamiento estándar?

A: La variante sin razonamiento generalmente responde 2-4 veces más rápido que los modelos de razonamiento estándar para tareas simples, ofreciendo una latencia significativamente menor y un mayor rendimiento para aplicaciones de procesamiento de texto de gran volumen.

Patio de juegos de IA

Acceso

Acceso